DOI:

https://doi.org/10.14483/22486798.3160Publicado:

01-07-2010Número:

Vol. 15 Núm. 2 (2010): Experiencias de investigación sobre evaluación (Jul-Dic)Sección:

Artículo de ReflexiónInvestigaciones de factores asociados: ¿con cuál “desempeño” hacer las comparaciones?

Associated research factors: ¿Comparisons made which performance?

Palabras clave:

Evaluación, factores asociados, desempeño, indicadores de evaluación (es).Palabras clave:

Evaluation, associated factors, performance evaluation indicators (en).Descargas

Referencias

Administración Nacional de Educación Pública. Unidad de Medición de Resultados Educativos (1999). Estudio de los factores institucionales y pedagógicos que inciden en los aprendizajes en escuelas primarias de contextos sociales desfavorecidos en el Uruguay. Montevideo.

Arancibia, V. (1992). Efectividad escolar: un análisis comparado. Estudios públicos (47). Recuperado de www.cepchile.cl/dms

Báez de la Fe, B. (1994). El movimiento de escuelas eficaces: implicaciones para la innovación educativa. Revista Iberoamericana de Educación, (4).

Bernstein, B. (1983). La educación no puede suplir las fallas de la sociedad. Lenguaje y sociedad. Cali: Univalle.

Bernstein, B. (1993). La estructura del discurso pedagógico. Madrid: Morata.

Bustamante, G. & Díaz, G. (2003). Factores asociables al desempeño de los estudiantes. Bogotá: Universidad Nacional de Colombia.

Casas, A., et al. (2002). El efecto escuela en Colombia, 1999-2000. Serie Documentos. Borradores de Investigación, (27).

Chávez, J. C. (2002). Determinación de los factores explicativos de los resultados escolares de la educación en el Perú. Estudio de Caso No. 69. Universidad de Chile.

Departamento Nacional de Planeación (1999). Un plan indicativo para la paz. Bogotá: Universidad Pedagógica Nacional.

Gertel, H. et ál. (2006). Análisis multinivel del rendimiento escolar al término de la educación básica en Argentina. Córdoba: Universidad Nacional de Córdoba, Facultad de Ciencias Económicas.

Laboratorio Latinoamericano de Evaluación de la Calidad de la Educación (Llece) (2000). Primer estudio internacional comparativo. Segundo Informe. Santiago de Chile: Unesco. Recuperado de www.llece.unesco

Gertel, H. et ál. (2002). Estudio cualitativo de escuelas con resultados destacables en siete países latinoamericanos. Santiago de Chile: Unesco.

Ministerio de Educación Nacional de Colombia (1993a). Avances de Saber. No. 1. Bogotá: MEN.

Ministerio de Educación Nacional de Colombia (1993b). Avances de Saber. No. 3. Informe sobre repitencia. Bogotá: MEN.

Ministerio de Educación Nacional de Colombia (s.f.). Logros cognitivos y factores asociados al logro: análisis de las pruebas de matemáticas y lenguaje para tercero y quinto de primaria 1997-1998. Resumen Ejecutivo, s/p.

Ministerio de Educación Nacional de Colombia (2002). La Revolución Educativa. Plan Sectorial de Educación. 2002-2006. Bogotá: MEN.

Ministerio de Educación Nacional de Colombia (2006). La Revolución Educativa. Informe de gestión a 7 de agosto del 2006. Bogotá: MEN.

Ministerio de Educación Nacional de Perú (2001a). Evaluación Nacional del rendimiento Escolar 2001. Fundamentación de los Instrumentos de Factores Asociados. Unidad de Medición de la Calidad Educativa, Perú.

Ministerio de Educación Nacional de Colombia (2001b). Boletín Crecer 8. Lima: Unidad de medición de la calidad educativa, Grupo Grade.

Navarro, R. (2002). Factores asociados al rendimiento académico. Veracruz: Universidad Cristóbal Colón de México.

Not, L. (1994). Las pedagogías del conocimiento. Bogotá: Fondo de Cultura Económica.

Piñeros Jiménez, L. J. (Ed.) (2004). Dimensiones del mejoramiento escolar. La escuela alza vuelo. Bogotá: Convenio Andrés Bello.

Piñeros Jiménez, L. & Rodríguez, A. (1998). Los insumos escolares en la educación secundaria y su efecto sobre el rendimiento académico de los estudiantes: un estudio en Colombia. Banco Mundial.

Preal, et ál. (2003). Informe de Progreso Educativo de Colombia. Entre el avance y el retroceso. Bogotá.

Preal, et ál. (2006). Informe de Progreso Educativo de Colombia. Hay avances pero quedan desafíos. Bogotá.

Rosa Alvarado, W. (2005). Teoría de modelos multinivel y sus aplicaciones. San Salvador: Universidad de El Salvador. Recuperado de www.matematica.ues.edu.sv

Santos, A. Oportunidades Educativas en Telesecundaria y factores que las condicionan. Revista Latinoamericana de Estudios Educativos, 31(3): 11-52.

Recuperado de www.redalyc.com

Saldarriaga, O. (2000). Matrices éticas y tecnologías de formación de la subjetividad en la pedagogía colombiana, Siglos XIX y X. Pretextos pedagógicos, (9).

Vélez, E., Schiefelbein, E. & Valenzuela, J. (1994). Factores que afectan el rendimiento académico en la educación primaria. Revista OEI.

Cómo citar

APA

ACM

ACS

ABNT

Chicago

Harvard

IEEE

MLA

Turabian

Vancouver

Descargar cita

Investigaciones de factores asociados: ¿con cuál “desempeño” hacer las comparaciones?

Associated research factors: ¿Comparisons made which performance?

Patricia Duarte A.* Alba García P.** Guillermo Bustamante Z.*** Luis Guillermo Díaz M.**** Iván Díaz

Cómo citar este artículo: Duarte, P., García, A., Bustamante, G., Díaz, L. y Díaz, I.(2010). Investigaciones de factores asociados: ¿con cuál “desempeño” hacer las comparaciones?. Enunciación 15 (2) 68-83

Recibido: 10 de abril de 2010/Aceptado 18 de mayo de 2010

Presentación

Corpoeducación y las fundaciones Luker, Carvajal, Corona y Génesis desarrollaron durante el 2007 la investigación llamada “Diseño, pilotaje y ajuste de un instrumento de factores asociados a la calidad de los procesos educativos de los estudiantes”. Para ello, se elaboró un referente conceptual; se construyeron indicadores para diseñar instrumentos dirigidos a estudiantes, docentes, rectores y padres de familia; se pilotearon los instrumentos en 42 instituciones educativas de Barranquilla, Bogotá, Buenaventura, Cali y Manizales. El análisis mostró que no es posible incidir en el desempeño de los estudiantes mediante la afectación de un aspecto haciendo caso omiso de los demás; que en función de sus responsabilidades, cada instancia decide frente a las particularidades de su realidad y que las distintas formas de apreciar el desempeño son todas legítimas.

*Correo electrónico: npaduarte@yahoo.com

**Correo electrónico: albaines2500@hotmail.com

***Correo electrónico: guibuza@gmail.com

****Correo electrónico: lgdiazm@unal.edu.co

Resumen

Corpoeducación y las fundaciones Luker, Carvajal, Corona y Génesis desarrollaron durante el 2007 la investigación llamada “Diseño, pilotaje y ajuste de un instrumento de factores asociados a la calidad de los procesos educativos de los estudiantes”. Para ello, se elaboró un referente conceptual; se construyeron indicadores para diseñar instrumentos dirigidos a estudiantes, docentes, rectores y padres de familia; se pilotearon los instrumentos en 42 instituciones educativas de Barranquilla, Bogotá, Buenaventura, Cali y Manizales. El análisis mostró que no es posible incidir en el desempeño de los estudiantes mediante la afectación de un aspecto haciendo caso omiso de los demás; que en función de sus responsabilidades, cada instancia decide frente a las particularidades de su realidad y que las distintas formas de apreciar el desempeño son todas legítimas.

Palabras clave: Evaluación, factores asociados, desempeño, indicadores de evaluación

Abstract

During 2007, Corpoeducación and Luker, Carvajal, Crown and Genesis foundations have developed the research: “Design, pilotage and adjustment of an instrument of associated factors to the quality of the students educative processes”., A conceptual frame was elaborated for; some indicators were built to design instruments intended for students, teachers, directors and parents; the instruments were piloted in 42 educational institutions of Barranquilla, Bogota, Buenaventura, Cali and Manizales. The analysis demonstrated that it is not possible to affect the performance of the students considering only one aspect, ignoring the others; also that -based on its own responsibilities- each instance decides according to the particularities of its reality and that the different ways to appreciate the performance are all legitimate.

Keywords: Evaluation, associated factors, performance evaluation indicators

Introducción

De un tiempo para acá, se ha impuesto una manera de ver la educación según la cual habría unos factores que se asocian positiva o negativamente a los desempeños de los estudiantes; en consecuencia, la inversión en el sector educativo habría que hacerla con arreglo a la detección de tales factores. Pero, ¿cómo establecer los desempeños de los estudiantes y cómo determinar las razones por las cuales se obtienen tales desempeños? Los criterios de los que se sirve un maestro, por ejemplo, no necesariamente coinciden con los de otro de la misma institución y, en consecuencia, no podrían aplicarse allí los criterios de uno de los maestros de manera generalizada; así mismo, las disposiciones de un directivo pueden ir en un sentido distinto de las de otro; etcétera. Esto ha obligado, por un lado, a estandarizar las evaluaciones de desempeño, para neutralizar la variabilidad de maneras mediante las cuales se obtiene dicho desempeño y, por otro, a proponer listados de asuntos que, desde dentro o desde fuera de la escuela, estarían influyendo en que los estudiantes obtengan determinados resultados en las pruebas de desempeño. También, aunque de manera menos visible, ha empujado a una estandarización de la gestión administrativa y de la labor formativa, ante la urgencia de obtener buenos resultados en las evaluaciones, resultados que cada vez se relacionan más con medidas que instituciones y docentes no quieren ver aplicadas en ellos mismos. Este empuje pragmático viene de todos los estamentos: no se trata de una imposición al menos, no solamente, sino de algo que se siente como una “necesidad”, efecto de la evaluación y no de la revisión de las prácticas o del análisis de la relación entre gestión y academia.

De entrada, los estudios en esta dirección son principalmente de naturaleza cuantitativa, pues los requerimientos exigidos excluyen otro tipo de énfasis investigativo. Aún así, en Colombia los estudios que se han hecho utilizan diversas metodologías y han tenido alcances desiguales. Enfoques, instrumentos y metodologías han sido distintos. Esto es un impedimento para hacer comparaciones… y, sin embargo, se han hecho.

Queremos en este documento mostrar una exploración que el grupo de investigación hizo en relación con el desempeño en las áreas de matemáticas y lenguaje, lo cual arroja un resultado que, nos parece, amerita ser reflexionado, tanto por la comunidad educativa como por las instancias que agencian las evaluaciones masivas.

Estudios

Desde finales de la década de los ochenta, organismos internacionales como Unesco, Unicef, la Organización para la Cooperación y el Desarrollo Económicos (OCDE), IEA, y gobiernos de muchos países pretenden evaluar la calidad de la educación mediante estudios que analizan la relación entre desempeño estudiantil y factores escolares y extraescolares, sustentados en un enfoque de insumo-proceso-producto. La calidad de la educación se establece por los niveles de desempeño que alcanzan los estudiantes, bajo la consideración de que “a mayor desempeño, mejor calidad”, y viceversa. Bajo esta concepción, Preal et ál. (2006, p. 12), por ejemplo, dicen: “La calidad de la educación no es la esperada”; y el Laboratorio Latinoamericano de Evaluación de la Calidad de la Educación (LLECE, 2000, p. 5) afirma: “el promedio de logro de los estudiantes en cuanto a lo que se considera adecuado que ellos aprendan en Lenguaje y Matemáticas, es bajo”.

En la década de los sesenta en Estados Unidos e Inglaterra, las conclusiones de los estudios sobre la influencia que ejerce la escuela en los resultados de los estudiantes generaron sorpresa. Coleman (en 1966), Jencks (en 1972) y Plowden Committee (en 1967) indicaron que el funcionamiento de la escuela, los profesores y la organización tienen una incidencia del 10% sobre los desempeños académicos, mientras que factores sociales y económicos, características del estudiante y de su familia, pueden explicar hasta el 90% de ese desempeño. Para Heyneman y Loxley (2006, p. 1), en los países desarrollados lo que determina los rendimientos de los estudiantes es el alto nivel socioeconómico de las familias.

Los estudios inscritos en la perspectiva de las “escuelas eficaces” buscan que, en los países en vía de desarrollo, la escolarización apoye la distribución equitativa del capital cultural. Sin embargo, según TIMSS (1996 y 1998), los aprendizajes de matemáticas y ciencias están fuertemente correlacionados con características del hogar y los puntajes más altos fueron obtenidos por países de alto desarrollo económico.

Según Piñeros y Rodríguez (1998) las variables escolares explican cerca del 30% del rendimiento, mientras que las condiciones extraescolares explican el 70%. El LLECE encontró en 1997 que la variabilidad en el rendimiento en 13 países de la región Andina y el Caribe es atribuible al contexto familiar. Santos (2001, p. 38) encontró en México que “a menor condición indígena, mejores puntajes”. En Colombia, tanto los tres estudios realizados para indagar por los factores asociados al logro de los estudiantes, como los análisis sobre repitencia, también insisten en la relación entre nivel socioeconómico y desempeño.

Resultados como estos, producidos en estudios de regresión clásica (en los que todo se carga a una variable), se han querido contrastar con análisis “multinivel”, en los que la variable a explicar se pone en relación con los factores jerarquizados por su contenencia respecto al estudiante: los estudiantes están en aulas de clase, estas están en escuelas, las escuelas están en núcleos educativos, etcétera, hasta llegar al sistema educativo global. Este modelo presupone que los componentes de cada nivel comparten la información, y no les atribuye una información específica relevante. Con el fin de mostrar más influencia del lado de la escuela, esta metodología se ha adoptado recientemente en América Latina: Perú (2001), El Salvador (Alvarado, 2005), Argentina (Gertel, 2006), Chile y México. Particularmente en Colombia, han hecho estudios el Ministerio de Educación Nacional (1991, 1993, 1997), Piñeros et ál. (2001 y 1999-2000) y Misión Social y Corpoeducación (1998-1999).

Como de todas maneras aunque no sea la tendencia general hay buenos resultados en algunas escuelas situadas en sectores con características socioeconómicas desfavorables, los estudios buscan focalizar los aspectos que permiten tales excepciones y han logrado ubicar asuntos como los procesos curriculares y de aprendizaje de los estudiantes. La idea es contrarrestar el efecto negativo que las bajas condiciones socioeconómicas tienen sobre el desempeño de los estudiantes.

Por ejemplo, durante el Primer Seminario Internacional sobre Gestión y Eficacia Escolar (Bogotá, 2002), Bert, P. M. Creemers (en Piñeros Jiménez, 2004) de la Universidad de Gromiingen, Holanda, llamó la atención sobre qué hace buena a una escuela y que no se ha tenido en cuenta en las investigaciones sobre factores asociados. Esta línea de investigación la inició Weber en 1971. En un grupo de colegios “eficaces” encontró que individualizar la enseñanza, tener personal auxiliar para la lectura, hacer evaluaciones cuidadosas, tener altas expectativas y un liderazgo profesoral son factores que explican el desempeño. Este tipo de investigación considera importante la capacidad que tienen los colegios de compensar las características de entrada de los alumnos (Cuttance, citado por Arancibia, 1992, p. 5). Al comienzo de estos estudios, se denominó “colegios efectivos” a aquellos que elevan el rendimiento académico por encima del nivel predicho por el nivel socioeconómico.

En el Reino Unido, Reynolds (1976) encontró que diferentes capacidades intelectuales, sistemas de estímulos, ambientes físicos adecuados y la participación democrática orientada por el director, eran elementos centrales para lograr buenos resultados académicos. En 1979, Brookover (en Estados Unidos) y Rutter (en Inglaterra) investigaron sobre efectos escolares para mostrar que, más que la relación insumo-producto, lo central en la escuela eran las relaciones entre los participantes del proceso educativo. Como se ve, esta corriente de las “escuelas eficaces” utiliza miradas más complejas para entender la escuela, introduciendo más variables de contexto.

Vélez, Schielfelbein y Valenzuela (1993) analizaron 18 estudios latinoamericanos propiciados en América Latina por esta ola. Encontraron que el porcentaje del logro explicado por la escuela varía entre el 49% y el 60%, y que sobre un grupo grande de factores los datos no son muy concluyentes. En Estados Unidos, Teddlie y Stringfield (1993, p. 163) encontraron que los factores más incidentes en el desempeño de los estudiantes son: clima escolar, dedicación a las tareas, estímulo a las prácticas independientes y disciplina fuerte.

Hacia 1999, en América Latina se realizó el “Estudio cualitativo de escuelas con resultados destacables en siete países latinoamericanos”. En Colombia, se seleccionaron cinco instituciones. El estudio encontró algunos factores que ayudan a potenciar el aprendizaje de los estudiantes (2002, p. 16): uso pedagógico de materiales y gusto por la lectura.

En resumen, pasamos de una idea según la cual el desempeño es explicado principalmente por el nivel so- cioeconómico (90%), a otra según la cual es necesario explicar el desempeño por variables escolares (60%).

La propuesta

En general, los estudios sobre factores asociados, sea bajo el modelo insumo-proceso-producto, o con el agregado del contexto; sea con perspectivas conceptuales supuestas (las más de las veces) o expuestas; cambiando o no las variables y los métodos estadísticos (regresión clásica, multinivel, ecuaciones estructurales, entre otros); con un número muy disímil de variables en juego… de todas maneras dan por bien hecha la manera como se obtiene la evaluación del desempeño.

Independientemente de si la perspectiva de los factores asociados debilita una pregunta por las condiciones de posibilidad, independientemente de si en lugar de una lógica causal según la cual introducir cierto insumo necesariamente produce determinado efecto podría proponerse una lógica tensional de la escuela, más allá de si las mediciones tradicionales no se han centrado en criterios propiamente educativos, sino más bien de naturaleza estadística… el asunto del desempeño es una pregunta de otros especialistas. Pero, si se trata de analizar los factores asociados, es necesario cruzarlo con el resultado del desempeño (toda vez que se trata de factores asociados a ese desempeño), de manera que no es indiferente la manera como se obtenga tal información. Más adelante lo veremos en el terreno mismo que proponen estos estudios: las cifras.

El equipo definió, al contrario de la gran mayoría de estudios, una idea explícita de escuela. Por tanto, la indagación de factores no fue, como en la gran mayoría de esos estudios, un listado de asuntos que los investigadores y los financiadores de la información creen que puede estar asociado, o que se ven en la obligación de preguntar, debido a que se trata de asuntos de la política educativa en boga. Ante tal falta de criterios, se da el caso de que el número de preguntas y de cruces está en relación directa con el presupuesto de la investigación. No es infrecuente tampoco la idea de usar instrumentos ya “estandarizados” en otra parte, o de usar las mismas variables, pero con otras metodologías, para probar o rebatir investigaciones anteriores.

En nuestro caso, la concepción de escuela es explícita y arroja doce categorías de observación, ni una más, ni una menos. No es el objetivo de este artículo discutirlas, por lo que los interesados pueden remitirse al informe de la investigación. Pero, en todo caso, cualquier

“objeto de observación”, que es el caso de casi todos los asuntos preguntados en las encuestas de factores asociados (libros, deserción, repitencia, posesión de electrodomésticos, distancia de la casa a la escuela, número de años de educación de los padres, etcétera), se define en función de tales categorías. Así, por ejemplo, lo libros no son un asunto a mirar en sí, pues lucen al menos parcialmente diferentes cuando se los integra a interrogantes que indagan por su participación en la puesta en juego del proyecto escolar, o cuando se los integra a interrogantes que indagan por su participación en la construcción del currículo.

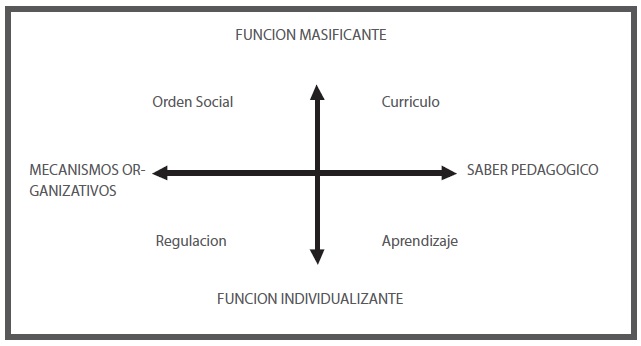

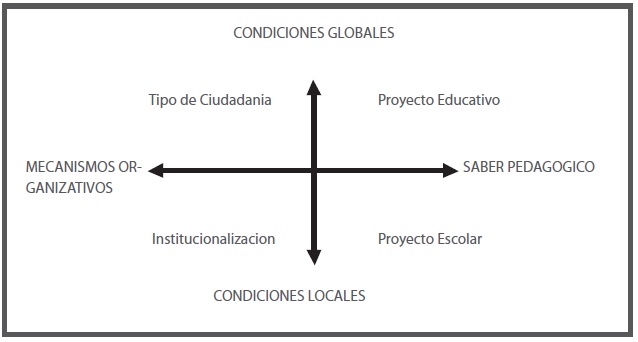

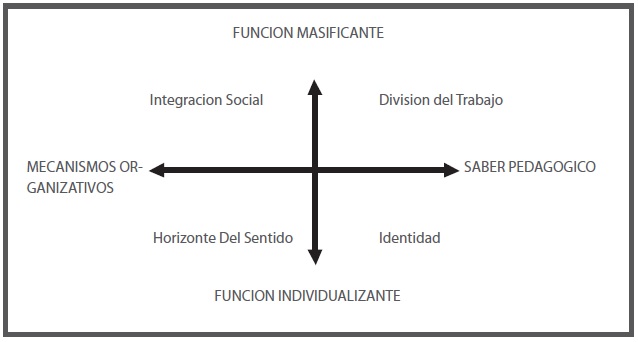

Las tensiones que dan origen a las categorías de observación son las siguientes:

•Función: tensión entre lo masificante y lo individualizante

•Mecanismos organizativos vs. saber pedagógico

•Condiciones: tensión entre local y global.

Su entrecruzamiento en tres dimensiones produce las siguientes categorías de observación: orden social, currículo, regulación, aprendizaje, tipo de ciudadanía, proyecto educativo, institucionalización, proyecto escolar, integración social, división del trabajo, horizonte de sentido, identidad:

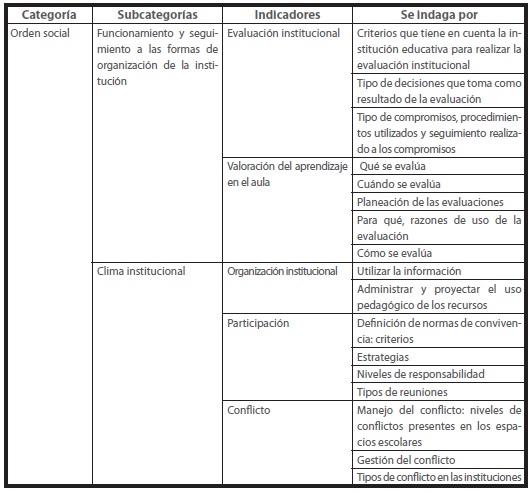

Sin embargo, en este primer estudio solo se incluyeron cuatro de estas doce categorías. El esquema sirve, además, para interpretar los resultados; recurso que parece faltar en gran medida en otros estudios, razón por la cual las cifras soportan muchos tipos de interpretación, sin que algo de lo conceptual parezca poder poner un criterio. Para seleccionar categorías de observación y definir indicadores, se discutieron las variables identificadas, su pertinencia y adecuación con el enfoque conceptual de la escuela tensional; se valoró la posibilidad de llevar dichas variables a indicadores “medibles” por medio de instrumentos. Finalmente, para el estudio se seleccionaron las siguientes cuatro categorías de observación: orden social, currículo, aprendizaje y horizonte de sentido.

Cada categoría se dividió en subcategorías y éstas, a su vez, se dividieron en indicadores, los cuales contaron con una descripción detallada de cómo se indagaría por ellos. Este mecanismo permite investigaciones a largo plazo, que no están obligadas a hacerse cuantitativamente, sino que quedan muy bien articuladas a investigaciones cualitativas.

A continuación, un ejemplo con la categoría “orden social”:

Eso para la parte de los factores asociables. Para el desempeño, recordamos que estos estudios se hacen contra evaluaciones estandarizadas. En Colombia, por ejemplo, con las pruebas Saber. Pero como una de las interrogaciones que teníamos se refería precisamente al asunto de cómo se mide el desempeño y, en consecuencia, cómo se sacan después conclusiones sobre la “calidad” de la educación, utilizamos tres maneras de valorar el desempeño de los estudiantes. Vamos a ver que sin poder descartar fácilmente ninguna de estas maneras pues todas tienen un lugar importante en los objetivos de la educación, los cruces con cada una de ellas dan resultados distintos. Las tres maneras que se escogieron para valorar el desempeño fueron las siguientes:

• Nivel de desempeño de los estudiantes en pruebas estandarizadas de lenguaje y matemáticas. Para establecer la relación entre factores y logro, se tuvo en cuenta el nivel de desempeño alcanzado por los estudiantes de grados 5° y 9° en las dos áreas básicas que se han evaluado en las últimas décadas en el país: lenguaje y matemáticas. Se utilizó la prueba Saber del 2003.

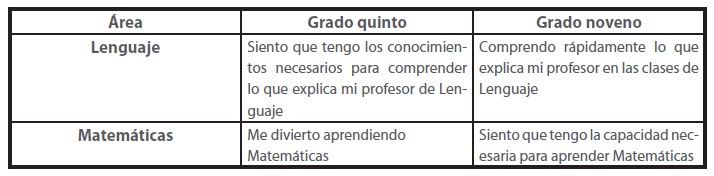

• Autopercepción de los estudiantes frente a su desempeño. En el instrumento, un grupo de preguntas indagó por la idea que los estudiantes tienen frente a su proceso de formación en cada una de las áreas mencionadas.

Para establecer el desempeño desde la perspectiva del estudiante, se seleccionó una pregunta por grado y área del conjunto de preguntas que en los instrumentos de factores se hicieron para indagar por las expectativas frente a la escolarización de los estudiantes en su contexto social y cultural específico.

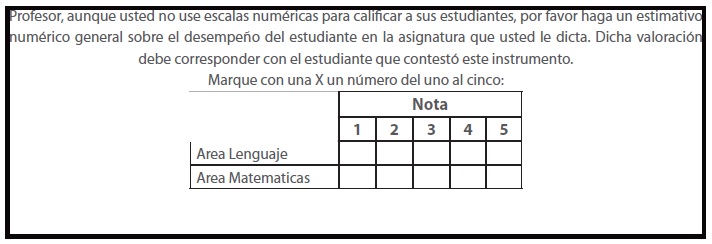

•Valoración que hace el docente. En uno de los instrumentos, se solicitó a los docentes que calificaran al estudiante en cada una de las áreas:

Procedimientos estadísticos y algunos resultados

Para describir, validar y depurar el instrumento de factores asociados, se usaron las siguientes herramientas estadísticas:

• Exploración de la distribución de las respuestas a cada una de la preguntas, para advertir sobre la posible discriminación de las respuestas (por ejemplo, reconsideración de opciones con muy baja selección).

• Exploración y descripción de la posible correlación entre las preguntas de los cuestionarios de factores asociados y los desempeños de los estudiantes, así como de las preguntas entre sí.

• Utilización de técnicas multivariadas (como el escalamiento óptimo), para detectar la redundancia (unidimensionalidad) entre los diferentes factores asociados. Esta técnica permitió reestructurar los cuestionarios por la vía de la reducción de variables; bien por mostrar alta correlación o baja variabilidad.

En atención a la naturaleza ordinal de las respuestas posibles a las preguntas de factores asociados y a la escala de intervalo con la que se miden los desempeños, se empleó el coeficiente de correlación tao de Kendall. Este coeficiente de concordancia, que permite establecer posibles asociaciones entre factores, y entre factores y desempeños, toma valores entre -1 y +1, así: valores cercanos a -1 sugieren variables discordantes; es decir, que los niveles altos de una variable se corresponden con niveles bajos de otra. Valores cercanos a +1 sugieren variables concordantes; es decir, que los niveles altos de una variable se corresponden con niveles altos de otra, y valores cercanos a 0 (cero) indican no concordancia. Para establecer cuáles de los coeficientes de concordancia de Kendall pueden interpretarse como significativos, se utilizó el criterio del p-valor, que intenta medir el grado de incertidumbre que se tiene al afirmar que un coeficiente es diferente de cero. Cuando su valor es pequeño, la hipótesis de independencia es muy poco probable.

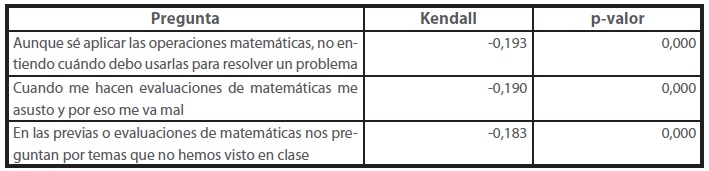

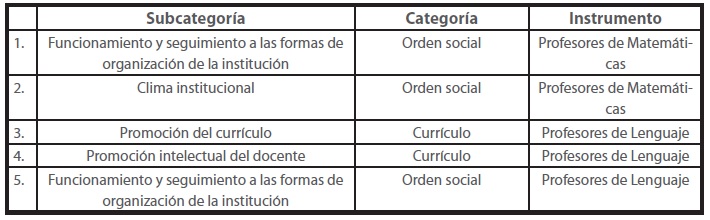

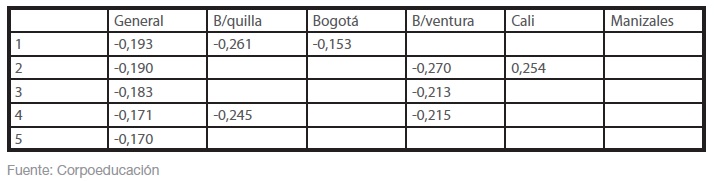

Un ejemplo: en la siguiente tabla se presentan los tres factores más asociados al desempeño de los estudiantes de quinto en la prueba Saber de Matemáticas:

En este caso, la correlación negativa indica que quienes respondieron “muy de acuerdo” a las preguntas, por lo general obtuvieron bajos puntajes en la prueba. En otras palabras, parece haber una discrepancia entre el aprendizaje y los formatos más comunes de la clase de Matemáticas y sus formas de evaluación, como si se apuntara a una mecanización de algoritmos y no a los procesos cognitivos de los estudiantes.

Esta metodología se aplicó para cada grado, área y actor. A continuación se presentan los factores asociados de mayor correlación con el desempeño en Matemáticas, grado 5º, a) definido a partir de las pruebas Saber; y b) definido a partir de la nota del profesor:

a) A partir de las pruebas Saber

• La adopción de los enfoques pedagógicos que asume la institución tiene en cuenta las tendencias en boga (Cuestionario rectores).

• Para elaborar las guías de trabajo para los estudiantes priorizamos los estándares de competencias (Profesores).

• En mi práctica pedagógica lo esencial es que los estudiantes entiendan los conceptos básicos del área (Profesores).

• En mi práctica pedagógica lo esencial es que los estudiantes aprendan a resolver los ejercicios típicos del área (Profesores).

• En mis clases promuevo el intercambio con estudiantes de otros cursos (Profesores).

• La institución cuenta con estrategias para mejorar el desempeño académico de los estudiantes (Rectores).

• Con los estudiantes, la causa principal de los problemas es la disciplina (Profesores).

•Aunque sé aplicar las operaciones matemáticas, no entiendo cuándo debo usarlas para resolver un problema (Estudiantes).

•En las previas o evaluaciones de Matemáticas nos preguntan por temas que no hemos visto en clase (Estudiantes).

•Cuando la opinión de los padres es razonable, estoy dispuesto a que se modifiquen las decisiones de la administración del colegio (Rectores).

b) A partir de la nota del profesor

•A mi hijo se le dificultan las evaluaciones de Matemáticas (Padres). •A mi hijo se le dificulta aprender Matemáticas (Padres).

• El rendimiento académico de los estudiantes se ve afectado por las relaciones con algunos docentes (Rectores).

• Cuando me hacen evaluaciones de Matemáticas me asusto y por eso me va mal (Estudiantes).

• En mi práctica pedagógica lo esencial es que los estudiantes entiendan los conceptos básicos del área (Profesores).

• Me interesan las materias que veo y cuando me evalúan saco buenas notas (Estudiantes).

• Entiendo más fácilmente un tema cuando pregunto a mis compañeros que cuando me explica mi profesor (Estudiantes).

• En el colegio he escuchado agresiones verbales de los profesores hacia los estudiantes (Profesores).

• Las discusiones sobre los enfoques pedagógicos privilegian lo conceptual (Rectores).

• La comprensión de un concepto va más allá de lo que puedo explicar con ayuda de los recursos didácticos (Profesores).

Como se ve, es muy distinto hablar de cuáles son los factores asociados a la calidad, tomando como referencia maneras distintas de valorar el desempeño. Entre las diez primeras asociaciones, ¡sólo coinciden en una! O sea que nunca nos hablan de la calidad de la educación, sino de lo que unas decisiones metodológicas permiten decir. Y, no obstante, pasamos a hablar inmediatamente de la educación, sin pasar por la aclaración necesaria; y, lo que es más delicado: a tomar “medidas de mejoramiento”.

Si bien a partir de la prueba estandarizada se obtienen unas asociaciones, no es menos cierto que a partir de la nota del profesor, que es quien está en contacto cotidiano con los estudiantes y con los padres, se obtienen otras asociaciones, distintas. Aunque la nota de un profesor no es aplicable a otros profesores, a otras instituciones, ¿podríamos descartar de entrada, por esta razón, los factores que resultan asociados a su manera de interpretar el desempeño de los estudiantes? Si no hubiera una tendencia, las cifras no marcarían una asociación.

Por otro lado, si bien los factores que resultan asociados (listados más atrás) muestran interesantes hallazgos, es necesario tener en cuenta que el modelo conceptual que sustenta esta investigación, más que indagar por factores aislados, indaga por categorías y subcategorías que dan cuenta de un modo más completo de los posibles grupos de factores que pueden intervenir en la configuración de las particularidades de una institución. Por esta razón, es necesario complementar el análisis con otras estrategias.

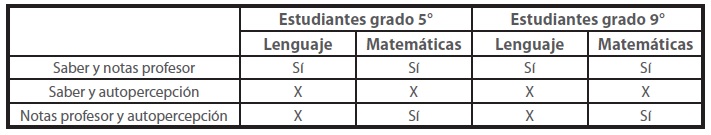

Pero, haciendo hincapié en las maneras de apreciar el desempeño, la sorpresa es grande cuando buscamos las correlaciones entre ellas:

De la tabla anterior, podemos tener las siguientes apreciaciones:

• La presencia o no de correlaciones es consistente entre grado 5° y grado 9°; o sea, lo mismo ocurre en ambos grados. Esta coincidencia tiene cierto valor en el sentido de que no se trata necesariamente de algo azaroso, pues lo mismo ocurre en ambos grupos, con un promedio de cuatro años de diferencia, con pruebas distintas.

• Hay correspondencia entre la manera como la prueba Saber y el profesor evalúan el desempeño de los estudiantes en ambas asignaturas. Esto bastaría para decir que ¡sobran las pruebas estandarizadas! una manera predice la otra. Si la apreciación del maestro varía en forma paralela a como mide la prueba Saber, ¿para qué invertir en evaluaciones masivas, si los maestros podrían dar cuenta del desempeño de los estudiantes? Y no era para menos: pese a que las evaluaciones masivas presuponen paradójicamente que el maestro y la institución no saben acerca de sus estudiantes por eso se justificarían la prueba externa y los programas de mejoramiento concomitantes, este estudio muestra que sí saben, al menos lo mismo que la prueba Saber intenta establecer.

• En cambio, entre la autopercepción del estudiante y la prueba Saber nunca hay correspondencia: ni en Lenguaje, ni en Matemáticas, ni en 5°, ni en 9°. Por un lado, podría decirse que, frente a lo que los estudiantes piensan de sí mismos, se justifica la prueba Saber, pues son “más expertos” en las disciplinas quienes hacen esas pruebas que los estudiantes. Pero, en segundo lugar, ¿no se propone la educación que los estudiantes sepan algo de su propio proceso? ¿No es desconsolador el hecho de que los estudiantes piensen acerca de sus logros en un sentido completamente distinto al que miden las pruebas? ¿No sería esperable que los estudiantes sepan algo de la relación que tienen con su rendimiento en las asignaturas?

• Y, por último, entre la percepción del profesor y la autopercepción del estudiante, hay coincidencia en el caso de Matemáticas y una falta de coincidencia en el caso de Lenguaje (igual para ambos cursos). Es decir, maestro y alumno saben de los desempeños del estudiante en Matemáticas, en el mismo sentido, pero difieren en la manera de entender el desempeño de Lenguaje. En primer lugar, podría preguntarse por qué si Saber coincide con la nota del profesor y ésta coincide con la autopercepción en el caso de Matemáticas, ¿por qué no coinciden la autopercepción de Matemáticas y Saber en esa área? Este es un fenómeno típico de las cifras. Si bien esa regla de tres es esperable en los “hechos educativos”, no se refleja en los “hechos de las cifras”, que no dependen principalmente de lo que ocurre en educación, sino de lo que ocurre entre las cifras. Lo preocupante es que estemos rigiendo las medidas educativas más con base en las “curiosidades” de las cifras que en los asuntos educativos, descritos desde su propia especificidad.

Y, para el caso de lenguaje, tenemos una duda adicional, cuando tampoco el proceso educativo está conduciendo a una apreciación compartida entre maestro y alumno acerca del desempeño estudiantil.

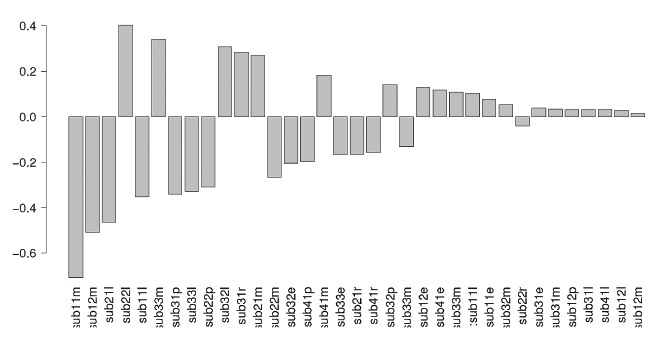

Por último, se realizó una cuantificación por medio de la técnica de análisis de datos denominada escalamiento óptimo. La técnica contiene un algoritmo que asigna valores numéricos a las categorías de las variables, de forma tal que se maximice la varianza, es decir, la cantidad de información retenida por una suma ponderada de las variables; ésta se corresponde en forma análoga con la primera componente principal, la cual podemos leer como un índice que resulta de combinar, en forma ponderada, los respectivos factores puestos en juego. Una característica de este índice es que conserva la escala de medición original de los datos que, en este caso, era ordinal. Así, los estudiantes que presentan respuestas en los niveles más bajos en todos los ítems tendrán valores bajos del índice ,mientras que los estudiantes con respuestas en los niveles altos tendrán un valor alto del índice.

El cálculo de este índice para cada subcategoría es fundamental, debido a que permite cuantificar la situación de cada individuo en esa subcategoría y relacionar esa cuantificación directamente con el desempeño académico del estudiante.

Con el objetivo de analizar la influencia conjunta de las subcategorías en el desempeño de los estudiantes, se pueden utilizar los modelos de regresión, los cuales buscan establecer el efecto de cada subcategoría en el puntaje de los estudiantes en las pruebas. Con este análisis se puede establecer el efecto que cada sub- categoría tiene en el puntaje, el cual puede ser ordenado y graficado para obtener una visualización de la importancia de cada subcategoría. En este caso, se presenta la figura para los estudiantes de grado 5º:

A manera de conclusiones

En primera instancia, los resultados solo son interpretables en función del modelo de escuela (escuela tensional), pues justamente estos instrumentos se elaboraron teniendo en cuenta, entre otras cosas, que otros estudios carecen de un modelo explícito de escuela, lo cual conlleva a una lectura fragmentaria de los resultados y a una dificultad para juzgar los efectos de la política educativa basada en ellos. En este sentido, toda vez que los instrumentos se construyeron de cara a una concepción explícita de escuela, los resultados de su aplicación se entienden sobre la base de las categorías y de la lógica que sirvieron para su construcción.

Por ejemplo, no se puede hacer una lectura puntual de un factor que correlacione con el desempeño, pues el modelo presenta una serie de aspectos articulados, que se explican mutuamente y que se suponen en tensión y transformación permanentes. Es el caso del factor que en la aplicación piloto resultó con mayor asociación al desempeño de los estudiantes de grado 5º en Matemáticas, obtenido mediante la prueba Saber del 2003. Dicho factor, del instrumento de rectores, fue: “La adopción de los enfoques pedagógicos que asume la institución tiene en cuenta las tendencias en boga”. Podría pensarse, por fuera del modelo, que si este factor está asociado positivamente al desempeño, se produciría un mejoramiento de la calidad educativa mediante la promoción del estudio de las “tendencias en boga”, o de la capacitación de los rectores en tal sentido. No obstante, la pregunta ha sido hecha también a docentes en función de la valoración que se hace de asuntos como la participación en la construcción efectiva del currículo no solamente el “plan de estudios” oficial de la institución, y la manera como se establece la posición que frente al conocimiento cada uno asume y pone en práctica en esa construcción. De tal forma, el tema de la pregunta “las tendencias en boga”, representa apenas una de las posiciones y uno de los aspectos que se miran para configurar la categoría currículo. Como se ve, pretender mejorar la calidad promoviendo el estudio de las “tendencias en boga” es una lectura impertinente incluso va en sentido contrario al modelo, porque no permite entender los vínculos entre los aspectos que se interrelacionan en una categoría.

Por otro lado, el sentido que gana la ponderación de una pregunta no puede generalizarse, pues el modelo tiene, como uno de sus ejes de tensión, el relativo a las condiciones globales y locales. En la aplicación piloto, el factor de los estudiantes que más correlación tuvo fue: “Aunque sé aplicar las operaciones matemáticas, no entiendo cuándo debo usarlas para resolver un problema”; sin embargo, este factor resulta asociado con pesos distintos solamente en dos de las cinco ciudades cuando se analizan solamente los datos de la ciudad. Además, el análisis de los resultados puede llevarse hasta identificar la interacción entre aspectos, de tal manera que el sentido que adquiere en esas dos ciudades depende de la asociación con otros factores. Tal análisis muestra que no es posible incidir en el desempeño mediante la afectación de un aspecto haciendo caso omiso de los demás.

Veamos otro ejemplo: del instrumento aplicado a los estudiantes de grado 5º, tomamos los factores más asociados al desempeño en toda la muestra. Y luego observaremos cómo se comportan esos factores en cada una de las ciudades:

• Aunque sé aplicar las operaciones matemáticas, no entiendo cuándo debo usarlas para resolver un problema.

• Cuando me hacen evaluaciones de Matemáticas me asusto y por eso me va mal.

• En las previas o evaluaciones de Matemáticas nos preguntan por temas que no hemos visto en clase.

• Cuando el profesor tiene que explicarme mucho porque no entiendo, deja de interesarme el tema.

• Como aprendo tan rápido en el colegio, no necesito estudiar en la casa.

Como se ve, algunos factores que se destacan en toda la muestra no aparecen en algunas de las ciudades. Incluso, en Manizales no aparece ninguno. Esto muestra que toda circunscripción de los datos (por ejemplo, por institución, por localidad, por ciudad, por región, por departamento, por país, etcétera), configura una “nueva población” que puede arrojar información diferente. En otras palabras, con datos de esta naturaleza no se “profundiza” el análisis a medida que se desplaza la mirada hacia unidades más grandes (región, departamento, país, etcétera) o hacia unidades más pequeñas (institución, localidad, ciudad, etcétera). Ese movimiento depende de los intereses y de las responsabilidades que se tengan frente al sector educativo. Así, una política nacional perfectamente puede establecerse bajo la idea de atender a las diferencias entre las unidades pertenecientes a los diversos niveles de análisis. Lo nacional puede leerse en función de la heterogeneidad de las regiones, la región puede leerse en función de la heterogeneidad institucional, etcétera. De todas maneras, en función de sus responsabilidades, cada instancia decide frente a las particularidades de su realidad.

Por último, toda esta heterogeneidad se hace aún más compleja cuando agregamos distintas formas de apreciar el desempeño, todas ellas legítimas en algún sentido: la prueba estandarizada, como instrumento de la administración de la educación; la calificación del profesor, como aproximación de alguien que acompaña el trabajo cotidiano del estudiante y, en consecuencia sabe sobre el desempeño del mismo; y la autopercepción del estudiante, como aproximación de alguien que es agente del trabajo y del cual, además, la educación espera la consolidación de criterios para interpretar y actuar sobre su propio desempeño.

Reconocimientos

Corpoeducación y las fundaciones Lúker, Carvajal, Corona y Génesis desarrollaron durante el 2007 la investigación llamada “Diseño, pilotaje y ajuste de un instrumento de factores asociados a la calidad de los procesos educativos de los estudiantes”.

Referencias

Administración Nacional de Educación Pública. Unidad de Medición de Resultados Educativos (1999). Estudio de los factores institucionales y pedagógicos que inciden en los aprendizajes en escuelas primarias de contextos sociales desfavorecidos en el Uruguay. Montevideo.

Arancibia, V. (1992). Efectividad escolar: un análisis comparado. Estudios públicos (47). Recuperado de www.cepchile.cl/dms

Báez de la Fe, B. (1994). El movimiento de escuelas eficaces: implicaciones para la innovación educativa. Revista Iberoamericana de Educación, (4).

Bernstein, B. (1983). La educación no puede suplir las fallas de la sociedad. Lenguaje y sociedad. Cali: Uni- valle.

—. (1993). La estructura del discurso pedagógico. Madrid: Morata.

Bustamante, G. & Díaz, G. (2003). Factores asociables al desempeño de los estudiantes. Bogotá: Universidad Nacional de Colombia.

Casas, A., et ál. (2002). El efecto escuela en Colombia, 1999-2000. Serie Documentos. Borradores de Investigación, (27).

Chávez, J. C. (2002). Determinación de los factores explicativos de los resultados escolares de la educación en el Perú. Estudio de Caso No. 69. Universidad de Chile.

Departamento Nacional de Planeación (1999). Un plan indicativo para la paz. Bogotá: Universidad Pedagógica Nacional.

Gertel, H. et ál. (2006). Análisis multinivel del rendimiento escolar al término de la educación básica en Argentina. Córdoba: Universidad Nacional de Córdoba, Facultad de Ciencias Económicas.

Laboratorio Latinoamericano de Evaluación de la Calidad de la Educación (Llece) (2000). Primer estudio internacional comparativo. Segundo Informe. Santiago de Chile: Unesco. Recuperado de www.llece.unesco

— (2002). Estudio cualitativo de escuelas con resultados destacables en siete países latinoamericanos. Santiago de Chile: Unesco. Ministerio de Educación Nacional de Colombia (1993a). Avances de Saber. No. 1. Bogotá: MEN.

— (1993b). Avances de Saber. No. 3. Informe sobre re- pitencia. Bogotá: MEN. — (s.f.). Logros cognitivos y factores asociados al logro: análisis de las pruebas de matemáticas y lenguaje para tercero y quinto de primaria 1997-1998. Resumen Ejecutivo, s/p. — (2002). La Revolución Educativa. Plan Sectorial de Educación. 2002-2006. Bogotá: MEN. — (2006). La Revolución Educativa. Informe de gestión a 7 de agosto del 2006. Bogotá: MEN. Ministerio de Educación Nacional de Perú (2001a). Evaluación Nacional del rendimiento Escolar 2001. Fundamentación de los Instrumentos de Factores Asociados. Unidad de Medición de la Calidad Educativa, Perú.

— (2001b). Boletín Crecer 8. Lima: Unidad de medición de la calidad educativa, Grupo Grade. Navarro, R. (2002). Factores asociados al rendimiento académico. Veracruz: Universidad Cristóbal Colón de México.

Not, L. (1994). Las pedagogías del conocimiento. Bogotá: Fondo de Cultura Económica.

Piñeros Jiménez, L. J. (Ed.) (2004). Dimensiones del mejoramiento escolar. La escuela alza vuelo. Bogotá: Convenio Andrés Bello.

Piñeros Jiménez, L. & Rodríguez, A. (1998). Los insumos escolares en la educación secundaria y su efecto sobre el rendimiento académico de los estudiantes: un estudio en Colombia. Banco Mundial.

Preal, et ál. (2003). Informe de Progreso Educativo de Colombia. Entre el avance y el retroceso. Bogotá.

— (2006). Informe de Progreso Educativo de Colombia. Hay avances pero quedan desafíos. Bogotá. Investigaciones de factores asociados: ¿con cuál “desempeño” hacer las comparaciones?

Rosa Alvarado, W. (2005). Teoría de modelos multinivel y sus aplicaciones. San Salvador: Universidad de El Salvador. Recuperado de www.matematica.ues.edu.sv

Santos, A. Oportunidades Educativas en Telesecundaria y factores que las condicionan. Revista Latinoamericana de Estudios Educativos, 31(3): 11-52. Recuperado de www.redalyc.com

Saldarriaga, O. (2000). Matrices éticas y tecnologías de formación de la subjetividad en la pedagogía colombiana, Siglos XIX y X. Pretextos pedagógicos, (9).

Vélez, E., Schiefelbein, E. & Valenzuela, J. (1994). Factores que afectan el rendimiento académico en la educación primaria. Revista OEI.

Licencia

La revista Enunciación es una publicación de acceso abierto, sin cargos económicos para autores ni lectores. A partir del 1 de enero de 2021 los contenidos de la revista se publican bajo los términos de la Licencia Creative Commons Atribución – No comercial – Compartir igual (CC-BY-NC-SA 4.0 CO), bajo la cual otros podrán distribuir, remezclar, retocar, y crear a partir de la obra de modo no comercial, siempre y cuando den crédito y licencien sus nuevas creaciones bajo las mismas condiciones.

El titular de los derechos de autor es la revista Enunciación, conservando todos los derechos sin restricciones, respetando los términos de la licencia en cuanto a la consulta, descarga y distribución del material.

Cuando la obra o alguno de sus elementos se hallen en el dominio público según la ley vigente aplicable, esta situación no quedará afectada por la licencia.

Asimismo, incentivamos a los autores a depositar sus contribuciones en otros repositorios institucionales y temáticos, con la certeza de que la cultura y el conocimiento es un bien de todos y para todos.