Ciencia, Investigación, Academia y Desarrollo

Asistente del Grupo de Investigación LAMIC.

Director Grupo de Investigación LAMIC. Universidad Distrital Francisco José de Caldas.

En este artículo se presenta el desarrollo de una metodología de seguimiento y discriminación del movimiento de los ojos de un paciente. Esta propuesta de investigación constituye la primera etapa de un proyecto orientado al desarrollo de una interfaz humano máquina para pacientes discapacitados. Se fundamenta en la necesidad de solucionar algunos de los inconvenientes que presentan las personas que padecen estas enfermedades, tales como la imposibilidad de comunicarse y de interactuar con el medio que les rodea. En su realización se consideraron técnicas de procesamiento de imágenes para detectar y seguir el movimiento de los ojos, y métodos de inteligencia computacional para realizar la discriminación de los movimientos.

La metodología propuesta fue implementada en una plataforma software que permitió su ejecución en tiempo real. Se realizaron pruebas sucesivas con un paciente en particular y con otros pacientes en general. Los resultados obtenidos muestran en el primer caso la efectividad del diseño. En el segundo, evidencian la necesidad de mejorar la robustez del sistema.

Palabras clave: esclerosis lateral amiotrófica, tetraplejía, detección y seguimiento del movimiento de los ojos, procesamiento de imágenes, sistemas difusos, tiempo real.

This paper describes the development of tracking and discriminate methodology for human eye movements. This methodology is the first stage of a research project oriented for the development of a human-machine interface for disability patients. The purpose of project is help to solve some common problems of this people, such as the impossibility to communicate and to interact with the environment. The methodology uses digital image processing for eye tracking and computational intelligence methods for eye movement classifying.

The methodology is software-based develop for real time operation. Several tests for a particular patient and for others were made. Results of test show the efficacy of the methodology for a particular patient. However, the develop needs to improve his robustness for work with several patients.

Key words: amyotrophic lateral sclerosis, tetraplegy, detection and tracking of the movement of eyes, image processing, fuzzy systems, real time.

En la interacción humano-computador, el seguimiento del movimiento de los ojos juega un papel especialmente importante en el caso de pacientes con enfermedades que presentan tetraplejía dentro de sus manifestaciones, tales como la Esclerosis Lateral Amiotrófica (ELA) [1,2]. En estos casos los músculos del ojo, la capacidad intelectual y la visión no se ven afectados, permitiendo vislumbrar un medio de comunicación basado tan solo en el movimiento de los ojos de los pacientes. Por esta razón, se han desarrollado diferentes métodos de detección y seguimiento del movimiento de los ojos [3],[4], [5],[6],[7]. Estos métodos utilizan herramientas físicas y matemáticas que permiten la extracción de características del ojo, permitiendo su detección y posterior seguimiento.

Las herramientas que se utilizan para la detección de un ojo pueden ser invasivas o no invasivas, según el tipo de contacto que tengan con el usuario [8]. Una variedad de éstas se han propuesto para la detección no invasiva del movimiento de los ojos, debido a la incomodidad que se ocasiona al paciente al colocarle luces dirigidas a los ojos, electrodos o lentes. Estas aproximaciones se encuentran dentro del área de procesamiento de imágenes e incluyen comparación con plantillas [4] y transformada Hough [9, 10], pero presentan inconvenientes en implementaciones en tiempo real debido a la complejidad de sus operaciones [11].

El seguimiento del ojo es también objeto de estudio debido a los movimientos propios de los ojos [8]. Cuando éstos siguen un objeto en movimiento o hacen fijaciones, realizan unos movimientos adicionales al de desplazamiento, que incluyen movimientos sacádicos, de perseguimiento y de fijación [12]. Esas variaciones introducen errores en un sistema de seguimiento si no se han considerado previamente. Por ésta razón se han desarrollado trabajos que modelan su comportamiento de forma estadística para poder eliminarlas [8]. Este tipo de modelamiento implica esfuerzo por parte del diseñador, pues se tienen que considerar métodos que involucran desarrollos matemáticos complejos. Otra posible solución a problemas de éste tipo, es el uso de técnicas de inteligencia computacional, en las que el diseñador no necesita modelar de forma matemática el comportamiento del sistema, sino que establece algunos parámetros para dar solución al problema de manera robusta [13].

En la investigación, se presenta una propuesta HCI ( del inglés Human Computer Interface ) que per mita a pacientes discapacitados interactuar con el PC sin utilizar las manos. Se compone de una metodología para el seguimiento y discriminación de ocho tipos de movimiento de un ojo (arriba rápido, arriba lento, abajo rápido, abajo lento, derecha rápido, derecha lento, izquierda rápido, izquierda lento). Este método se dirige fundamentalmente a pacientes con discapacidades físicas que les impidan el movimiento de sus extremidades, pero que no comprometan la visión ni el movimiento de los músculos de los ojos.

La metodología planteada en éste trabajo, se orienta a su funcionamiento en tiempo real y ha sido diseñada considerando este tipo de operación como una de las restricciones. El problema es tratado así de forma satisfactoria. De otra parte, la propuesta del artículo es innovadora dada la originalidad en la conceptualización y diseño de los conjuntos difusos a través del histograma, aspecto que no se encuentra reportado en la literatura explorada. Los resultados obtenidos son satisfactorios para un paciente en particular y son comparables con los referidos por otros autores [3, 5, 6 , 7 y 11]. Para pacientes en general la robutez del sistema disminuye. La presente publicación tiene como base la investigación realizada por [14].

La organización del artículo se describe a continuación: En la sección dos se exponen conceptos básicos sobre la estructura y movimientos propios de un ojo humano. En la sección tres se presenta la metodología propuesta e donde se describe el sistema de detección y seguimiento. En la sección cuatro se muestran los métodos utilizados en la extracción de características y se describe el diseño de los sistemas difusos para la velocidad del movimiento contenidos en el sistema discriminador. Los resultados referentes a la precisión, costo computacional y robustez de la metodología se presentan en la sección cinco.

Finalmente, se entregan las conclusiones del trabajo y se proponen posibles mejoras orientadas al desarrollo de una interfaz humano-máquina basada en el movimiento de los ojos para pacientes discapacitados.

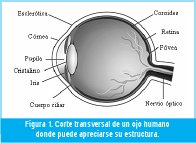

El ojo humano es el medio de adquisición y parte del sistema encargado de la percepción visual. En la figura 1 se muestra una sección transversal horizontal del ojo humano. El ojo es casi esférico, con diámetro de aproximadamente 25 mm. Está rodeado por tres membranas: la córnea y la esclerótica que constituyen la cubierta exterior, la coroides y la retina [12].

En su extremo anterior, la coroides está dividida en cuerpo ciliar e iris. Este último se abre o cierra para controlar la cantidad de luz que entra en el ojo. La abertura central del iris (la pupila) varía de diámetro desde 2 a 8 mm aproximadamente.

La retina es la membrana interna del ojo, cubre la totalidad de la pared posterior. Cuando el ojo está totalmente enfocado, la luz de un objeto exterior al ojo forma su imagen en la retina. Existen dos clases de receptores: los conos y los bastones. Los conos son muy sensibles al color y se localizan principalmente en la fóvea. Los músculos del ojo giran el globo ocular hasta que la imagen del objeto de interés queda en la fóvea. Los bastones sirven para dar una visión general del campo de visión.

Los movimientos oculares se controlan por tres pares de músculos: los rectos interno y externo, los rectos superior e inferior y los oblicuos superior e inferior [12]. Los rectos interno y externo se contraen recíprocamente, principalmente para mover los ojos de un lado a otro. Los rectos superior e inferior se contraen recíprocamente para mover los ojos de arriba abajo. Por último, los músculos oblicuos actúan para rotar los globos oculares a fin de mantener los campos visuales en posición vertical.

Los movimientos del ojo generalmente se clasifican en tres tipos, según la fijación del ojo en un momento específico [8, 12]. Estos tipos son los siguientes:

i. Movimientos sacádicos: Cuando la escena visual se mueve continuamente ante los ojos, éstos se fijan sobre un punto destacado detrás de otro en el campo visual, saltando inmediatamente al siguiente a una velocidad de dos o tres veces por segundo. A estos movimientos se les denomina movimientos sacádicos. Se usan para colocar la porción deseada de la escena visual sobre el centro de la fóvea.

ii. Movimiento de seguimiento: Se realiza cuando los ojos están siguiendo un objeto que se mueve lentamente. Está formado por dos componentes: una variación lenta de posición y un componente sacádico.

iii. Movimientos de fijación: Durante la fijación en objetos, el ojo presenta dos movimientos: el primero es un componente de alta frecuencia (entre 30 y 80 ciclos por segundo) y el segundo es un componente de desvío lento de los ojos en direcciones aleatorias.

Se plantea el desarrollo de una metodología de detección y discriminación del movimiento de un ojo humano en tiempo real. Para conseguir este objetivo se propone en primer lugar, construir un ambiente controlado que proporcione condiciones que eliminen el ruido ambiental (sombras o brillos en la región de interés) y faciliten el procesamiento de las imágenes en el contexto del proyecto. Luego, se diseña y evalúa una metodología para detectar y seguir el movimiento de un ojo, empleando técnicas de procesamiento de imágenes. Las señales de seguimiento presentan diferencias entre ellas según el tipo de movimiento que se realice. Por lo tanto, es posible extraer características relevantes que permitan una posterior discriminación. El siguiente paso es el diseño y evaluación de un procedimiento para discriminar el movimiento del ojo utilizando una técnica de inteligencia computacional. Posteriormente se implementa la metodología completa en una plataforma software, garantizando su funcionamiento en tiempo real, para luego evaluar el comportamiento general del sistema considerando su eficacia y robustez.

Se exponen las dos etapas que componen la metodología de detección y seguimiento. Esta contiene una fase de adquisición y una de procesamiento de las imágenes adquiridas.

En la etapa de adquisición es necesario evaluar tanto las herramientas utilizadas como la iluminación de la escena. En primera instancia, se considera un control de iluminación necesario para la adecuada toma de las imágenes. Se capturan utilizando una cámara que envía los cuadros a una tarjeta de adquisición, que se encuentra en un computador personal y se encarga, junto con un software específico, de adquirir y almacenar cada una de las imágenes.

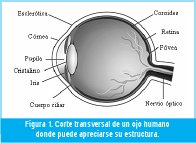

El objetivo de esta etapa es conseguir las coordenadas del centro de la pupila a partir de una imagen de entrada que comprende parte del rostro del paciente. Se compone de dos fases: una de calibración y una de ejecución, como se muestra en la figura 2. Una imagen adquirida ingresa en la etapa de calibración, allí se realiza cierto procesamiento que proporciona como salida a la siguiente etapa, de ejecución, cuatro coordenadas de corte que le permiten extraer el área de interés, para luego realizar el procesamiento necesario sobre ella solamente. Esta disminución del área de trabajo permite disminuir la carga computacional facilitando la implementación en tiempo real. En ésta sección se presenta el procesamiento que se realizó a las imágenes y los resultados obtenidos con su aplicación.

3.1.2.1 Etapa de calibración

En la etapa de procesamiento, la primera imagen adquirida se usa para detectar el centro de la pupila y obtener las coordenadas que determinan el área de interés real del sistema, la zona que encierra el ojo, y que permite a la fase de ejecución trabajar solamente sobre ella. Esta etapa se compone de una serie de fases que se describen a continuación:

i. Recorte grueso de la imagen: El recorte grueso de la imagen tiene como objetivo eliminar franjas negras que aparecen en la imagen adquirida, y que son generadas por la cámara manteniendo constante su grosor en todos los cuadros de la secuencia de video.

ii. Transformación de contraste: Un contraste alto permite diferenciar la zona perteneciente a la pupila y la perteneciente al iris. Con el fin de mantener de forma permanente ésta diferencia para hacer posible la extracción del área de interés: la pupila, se considera un ajuste automático del contraste. Se trata de una función de valor único y monótonamente creciente que aumenta el rango dinámico de los niveles de gris en la imagen.

iii. Extracción de la pupila: Para extraer el elemento de interés, se lleva a cabo un proceso de binarización de la imagen utilizando un umbral único. Esta técnica emplea la partición del histograma y permite extraer los objetos del fondo a partir de consideraciones sobre el nivel de gris de cada píxel [15, 16].

Para obtener este valor, se propone un método consistente en la toma sucesiva de pruebas en las que se obtiene el histograma de la imagen luego del aumento del contraste y se ubica el rango de niveles de gris donde se encuentra la pupila. Este tipo de umbralización, seguida de la obtención del negativo de la imagen binarizada, permite extraer la pupila como objeto.

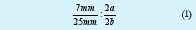

iv. Reducción del ruido en la imagen: La imagen que se obtiene luego de la binarización, se compone de un elemento de interés y una componente de ruido. Para minimizar este último, se utiliza un filtro morfológico [15] que consiste en una operación de apertura seguida de una de cierre, como el que se expresa en la ecuación (1).

Donde: C es la imagen filtrada, A es la imagen binarizada, y B es un elemento estructurante en forma de disco, debido a la forma circular de la pupila.

v. Localización del centro de la pupila: En el método aquí presentado se propone encontrar el centro de la pupila localizando el centro del cuadrilátero más pequeño que contiene el elemento de la imagen filtrada. Este método por su sencillez se constituye como una herramienta útil considerando el objetivo de operación en tiempo real. Esta medida es una buena aproximación, teniendo en cuenta que la forma de la pupila no siempre es circular sino que en la mayoría de los casos tiene forma de óvalo, debido a la posición del ojo respecto a la cámara con la que se realiza la adquisición.

vi. Detección del borde de la pupila: Este proceso se debe llevar a cabo luego del filtrado morfológico. A la señal filtrada se le extrae el borde utilizando el método Prewitt [15] para luego calcular la mayor distancia entre el centro de la pupila y su borde.

vii. Determinación de las coordenadas para el recorte fino: Una vez obtenidas las coordenadas del centro de la pupila y las del borde de la misma, se procede a encontrar la distancia más grande entre el centro de la pupila y cada uno de los píxeles del borde. Este valor se considera el radio real de la pupila si ésta se hubiese adquirido con la cámara ubicada frente a los ojos. Teniendo en cuenta esta medida y los valores reportados en la literatura por [12] para el diámetro promedio del globo ocular y de la pupila, se estima el tamaño del cuadrilátero que contiene el ojo mediante la proporción dada (2).

Donde: a es el radio medido de la pupila, b es el radio real del globo ocular que se desconoce y se puede calcular, 25 mm es el diámetro promedio del globo ocular y 7 mm es el diámetro promedio de la pupila.

En la figura 3b se muestra el resultado de llevar a cabo el recorte fino con éstas coordenadas sobre la imagen que se muestra en la figura 3a. Puede observarse una notable reducción del área de la imagen, esto se reflejará en menor tiempo de procesamiento.

3.1.2.2 Etapa de ejecución

La fase de calibración suministra a la etapa de ejecución las coordenadas del recorte fino y es en esta última donde se efectúa el seguimiento. Luego de realizarse la calibración, las imágenes adquiridas ingresan directamente al bloque de ejecución, que ya contiene como parámetro de entrada el vector de coordenadas del recorte fino. En esta parte de la metodología es donde se busca la operación en tiempo real.

En la etapa de ejecución, el procesamiento que se realiza a cada imagen es similar al de la etapa de calibración. La diferencia radica en que en el primer bloque ya no se realiza tan solo el recorte grueso, sino que se efectúa también el recorte fino. Por otra parte, solamente ejecuta la determinación de las coordenadas del centro de la pupila, las cuales constituyen la salida de la metodología de detección y seguimiento.

Los valores de salida obtenidos en la metodología de detección y seguimiento, son matrices de [N x 2], donde N es el número de puntos capturados en la secuencia de video. La primera columna corresponde a los valores de la coordenada X en cada toma, y los de la segunda columna a los de la coordenada Y.

La segunda parte de la metodología propuesta contiene dos fases y tiene como objetivo determinar el tipo de movimiento realizado. La primera fase se encarga de recibir las coordenadas del centro de la pupila generadas por la metodología de detección y seguimiento, para producir un vector de características que sirve como entrada al sistema discriminador. La segunda, recibe este vector y por medio de un clasificador genera una salida correspondiente a uno de los ocho tipos de movimientos planteados.

Las señales capturadas que describen el movimiento del ojo, son señales con una pequeña componente aleatoria y una componente de tendencia marcada según el tipo de movimiento (horizontal o vertical). Otra característica importante en el dominio temporal, es que su duración es más larga en el caso de movimientos lentos que en el de movimientos rápidos. Teniendo en cuenta estos factores y la especificación de ejecución en tiempo real, se plantea una metodología que permite caracterizar las señales del movimiento del ojo.

Con el fin de caracterizar las señales del movimiento de un ojo, se realiza una serie de pruebas que permite establecer qué información es la más relevante de la señal. En este proceso se requiere construir una base de datos que contenga muestras de los ocho tipos de movimiento y establecer el tamaño de la ventana de observación de las señales. Para establecer este tamaño, es importante considerar que se busca operación en tiempo real. Las series adquiridas deben ser divididas en segmentos más pequeños con el fin de actualizar la salida del discriminador en el menor tiempo posible.

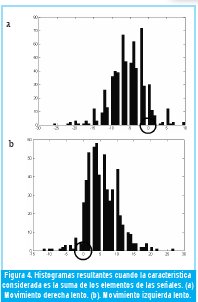

Se propone un procedimiento para el establecimiento del tamaño de la ventana basado en la generación de histogramas claramente diferenciables. Este concepto hace referencia a que los modos de los histogramas de las características de dos tipos de movimiento diferentes se encuentren separados. En la figura 4.a se muestra el histograma correspondiente a un movimiento derecha lento cuando la característica considerada es la suma de los puntos que componen la señal. La figura 4.b corresponde al movimiento izquierda lento. Los puntos donde se localiza el cero se encuentran encerrados en el círculo que aparece en las dos imágenes. Puede obser varse que en este caso los histogramas son claramente diferenciables, dado que en el primer caso, el histograma se localiza a la derecha del cero, mientras que en el segundo caso, se ubica a la izquierda del cero. El método propuesto para establecer el tamaño de la ventana se describe a continuación:

Paso 1: Determinación de la máxima longitud de la ventana. En este paso se debe determinar la longitud de cada una de las señales adquiridas para los ocho tipos de movimiento. El valor mínimo se considera como el tamaño máximo de la ventana.

Paso 2: Obtención de los segmentos de la señal. Cada una de las señales de movimiento debe ser dividida en segmentos más pequeños, cuya longitud está dada por el valor obtenido en el paso 1 si se trata de la primera iteración o por el valor obtenido en el paso 4 si es una iteración posterior.

Paso 3: Definición de una característica particular. En este paso se debe escoger una característica de la señal que será extraída a cada segmento para construir nuevos vectores que describan cada una de las señales.

Paso 4: Construcción y comparación de los histogramas. En este paso se construyen los histogramas de los vectores obtenidos en el paso 3 para los ocho tipos de movimiento. La comparación consiste en establecer por medio de la observación si existen diferencias claras en los histogramas correspondientes a cada uno de los tipos de movimiento. Si los histogramas son claramente diferenciables se procede a decrementar en uno la longitud de la ventana y se salta al paso 2. Si ya no es posible su diferenciación se establece como longitud de la ventana la encontrada en la iteración anterior y se detiene el proceso.

Luego de aplicar la metodología planteada, se observó que el tamaño de la ventana debe ser de cinco muestras. Por otra parte, luego de probar con diferentes características en el dominio del tiempo y de la frecuencia, se consideró que las características correspondientes a la suma de los elementos de cada vector y la velocidad del mismo fueron los que generaron mejores resultados. Esta última se define como la diferencia entre el valor del último y el primer elemento del vector de entrada.

El vector de características planteado esta formado entonces por cuatro elementos. El primero corresponde al valor de la suma de los cinco puntos, en el eje X, que componen el desplazamiento que se esta evaluando. El segundo contiene la suma en la coordenada Y. El tercero y el cuarto se relacionan con el valor de la velocidad en las coordenadas X y Y respectivamente.

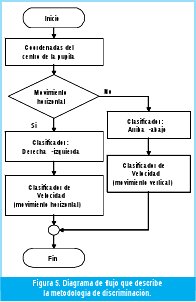

La discriminación se divide en cinco como se muestra en la figura 5. En primera instancia se determina si el movimiento realizado es de tipo vertical u horizontal. Para esto, se evalúa el signo de la diferencia de las sumatorias en X y Y: si la diferencia es positiva se trata de un movimiento horizontal pues el desplazamiento en el eje X fue mayor y además conservó la tendencia en una sola dirección. Si la diferencia es negativa se trata de un movimiento vertical ya que en este caso es en el eje Y que la serie conserva su tendencia y refiere un mayor desplazamiento.

Si el movimiento es horizontal, se procede a determinar si se realizó hacia la derecha o hacia la izquierda. Para ello, se toma el tercer elemento del vector de características que se refiere al valor de la velocidad en el eje X. Evaluando el signo de este elemento es posible determinar la dirección del movimiento. Si este es positivo, el desplazamiento se realizó hacia la izquierda. Por el contrario, si es menor que cero, el movimiento se realizó hacia la derecha. De la misma forma puede evaluarse la dirección de un movimiento vertical, sólo que en este caso se estudia el cuarto elemento del vector de características. Este contiene el valor de la velocidad en el eje Y, y presenta signo positivo si el desplazamiento se realiza hacia arriba, y negativo si se efectúa hacia abajo.

La determinación de la velocidad del movimiento se enfoca de una forma diferente debido a que no es posible establecer un umbral de clasificación.

En esta sección se plantea el diseño de un sistema difuso encargado de solucionar el problema de la ausencia de un umbral único que permita la discriminación de velocidad. A continuación se presenta la metodología seguida para diseñar los conjuntos difusos, la base de reglas correspondiente y otras consideraciones en el diseño de los sistemas difusos para movimientos horizontales y verticales.

i. Conjuntos difusos.

La construcción de los conjuntos difusos se lleva a cabo siguiendo un procedimiento que estudia los histogramas. Los universos de entrada que se consideran son la velocidad actual en el eje donde se realiza el movimiento (X o Y) y la velocidad anterior en el mismo eje (entendiendo velocidad como la diferencia entre el último y el primer punto en el vector de entrada al sistema de extracción de características). Se plantean los mismos conjuntos para los dos universos de entrada. El método seguido en la construcción de los conjuntos consta de cuatro pasos que deben realizarse para cada uno de los conjuntos y que se describen a continuación:

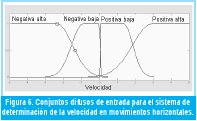

Paso 1: Planteamiento de los conjuntos iniciales. Se plantean cuatro conjuntos gaussianos correspondientes a velocidad negativa alta, negativa baja, positiva alta y positiva baja.

Paso 2: Primera modificación de los conjuntos. En este caso se localiza el máximo pico del histograma asociado al conjunto y se asigna a este valor un grado de pertenencia de uno. Las pendientes del conjunto difuso son tan abruptas como lo sean las pendientes de los datos contenidos en el histograma. Si el histograma contiene datos aislados éstos no se consideran en la construcción del conjunto difuso, pues el objetivo es construir el conjunto a la luz del histograma y no imitarlo completamente.

Paso 3: Medición del desempeño del sistema difuso. Se prueba el desempeño (número de aciertos respecto al número de pruebas) del sistema difuso con los conjuntos obtenidos en el paso 1 si se trata de la primera iteración o con los obtenidos en el paso 4 si se trata de una iteración posterior. Si el desempeño obtenido es menor al anterior se detiene el procedimiento y se establece como definitivo el conjunto resultante de la iteración anterior. Luego se retorna al paso 1 pero manteniendo la forma del conjunto ya diseñado y se procede a variar el siguiente hasta que finalice el diseño de todos los conjuntos.

Paso 4: Modificación de los conjuntos a la luz del histograma. Con el fin de mejorar la efectividad del sistema difuso, se varían los conjuntos que presenten menor desempeño. Esta variación se realiza observando el histograma y los datos a los que se asignó un grado de pertenencia pequeño o incluso ninguno. Luego de determinar cuales son las zonas significativas del histograma que se están dejando de incluir en el conjunto difuso, se realizan las variaciones pertinentes para su inclusión en el mismo. De este paso se retorna al paso 3 hasta que se consiga el mejor desempeño.

Es importante aclarar que no se está relacionando directamente la función de pertenencia de cada conjunto con su función de densidad de probabilidad asociada, puesto que la primera indica hasta qué punto cierto valor de una magnitud puede ser incluido en un conjunto difuso, mientras que la segunda, por su parte, indica la frecuencia con que los diversos valores de una magnitud se presentan. Las funciones de pertenencia fueron fijadas arbitrariamente por el diseñador, indicando el significado previamente asignado a cada una de las variables lingüísticas que definen los conjuntos. Las funciones de densidad de probabilidad fueron utilizadas solamente como una guía en el proceso de sintonización del sistema difuso. En la figura 6 se muestran los conjuntos resultantes luego de seguir el método descrito para el caso de los movimientos horizontales.

El universo de salida es velocidad. Este se compone de dos conjuntos tipo singleton: velocidad alta y velocidad baja localizados en 1 y -1 respectivamente, como se muestra en la figura 7. Finalmente la salida del sistema difuso se pasa por un bloque de comparadores que indican si esta es mayor o menor que cero para determinar la velocidad del movimiento realizado.

ii. Base de Reglas

La base de reglas se establece teniendo en cuenta dos factores: si se realiza un movimiento lento el desplazamiento es pequeño sobre la base de tiempo ya establecida como una constante. Por otra parte, si el movimiento es rápido el desplazamiento es mayor. El segundo factor está relacionado con fenómenos observados en la base de datos construida. En los movimientos rápidos, se encuentran vectores que los describen claramente, pero también vectores que se asemejan a movimientos lentos. Para evitar estos errores en la discriminación, se plantean reglas que observan el valor presente y el anterior de la velocidad en X (relativa al desplazamiento) y dan prioridad a los valores altos de las dos entradas. El peso asignado para las reglas que tienen como consecuente velocidad baja es de uno, y para las que tienen como consecuente velocidad alta es de 0.8. Esta asignación se realiza para compensar la prioridad que se esta dando a los movimientos rápidos sobre los lentos cuando uno de estos es antecedido por una velocidad alta. A continuación se mencionan las diez reglas que componen la base con su correspondiente peso:

iii. Características del sistema difuso.

Se propone un sistema difuso de tipo Mamdani con las siguientes características

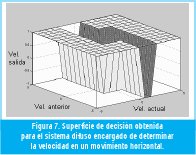

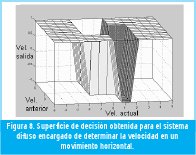

Las superficies de decisión resultantes para la clasificación de velocidad de los movimientos horizontales y verticales, se muestran en las figuras 7 y 8 respectivamente.

Una vez diseñada la metodología de seguimiento y discriminación, se procede a su implementación en una plataforma software que permite su operación en tiempo real. Esta implementación tiene como objetivo realizar pruebas de eficacia y robustez a la metodología propuesta.

La secuencia de video se capturó con una cámara de seguridad con resolución de 720X480 píxeles, una tarjeta de adquisición National Instrument y un computador con procesador Pentium 4 de 2.4 GHz y 480 Mb de memoria ram. Labview 6.5 fue la plataforma software elegida para la implementación de la metodología. La selección se debe a la facilidad que ofrece en el manejo de dispositivos periféricos y las ventajas que ofrece cuando se opera en tiempo real.

La rutina de adquisición y procesamiento de cada imagen hasta el momento de entregar las coordenadas del centro de la pupila tarda 10ms, por tanto la tasa de adquisición es de 10 imágenes por segundo. La discriminación de cada movimiento requiere 5 muestras, de esta forma el sistema entrega dos resultados por segundo.

Con el objetivo de establecer la eficacia del sistema de seguimiento y discriminación, se prueba con un paciente en particular y con otros once pacientes en general. Cada uno realiza de forma repetitiva cada uno de los ocho tipos de movimiento, mientras que el sistema realiza la discriminación.

En la figura 9 se muestra el porcentaje de discriminaciones acertadas durante la prueba de eficacia. Puede observarse que el movimiento para el caso del movimiento horizontal ( derecho) rápido se obtiene un desempeño del 100%. El movimiento vertical ( abajo ) lento por su parte, es el de menor eficacia, con un 78,45%. El valor promedio de las efectividades es de 91,65%.

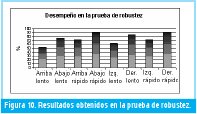

En la figura 10 se muestra el promedio del desempeño obtenido para todos los pacientes en cada tipo de movimiento. Puede observarse que el menor desempeño fue obtenido en la discriminación de la velocidad para el movimiento vertical (arriba) lento, éste fue del 51,43%. El mejor resultado se consigue en la discriminación del movimiento horizontal (derecho) rápido, donde se consigue un desempeño del 90%. El promedio del porcentaje de aciertos obtenido en éste caso es de 74,34%.

Se puede observar a partir de los promedios de desempeños obtenidos para la prueba de robustez que el sistema no es robusto, puesto que el promedio de desempeño del sistema para el paciente en particular es notablemente más alto que el promedio de los desempeños cuando se trata de diferentes pacientes.

Puede observarse en las figuras 9 y 10, que en el caso de discriminación de velocidad en movimientos verticales lentos el desempeño disminuye. Esto se debe a que el desplazamiento realizado por los ojos durante el movimiento es más corto y se ve afectado por las pestañas. Para la discriminación de la dirección en movimientos vertical y horizontal rápido la eficacia del sistema es mayor, puesto que la duración de las pruebas y el parpadeo son menores. En los movimientos lentos la presencia de perturbaciones aumenta, debido a que los movimientos de la cabeza y el cuerpo, en ocasiones, hace que el ojo salga del área de procesamiento planteada. Además el sistema discrimina el parpadeo como un movimiento vertical rápido y esto constituye un error en movimientos lentos.

En este artículo se presentó una metodología para seguir y discriminar el movimiento de un ojo humano en tiempo real, empleando procesamiento de imágenes y técnicas de inteligencia computacional.

La división de la metodología de detección y seguimiento en dos fases: calibración y ejecución, permite minimizar el área de la imagen y con ello reducir el tiempo de procesamiento. Con éste planteamiento se obtiene una tasa de muestreo mayor que la obtenida al procesar cada imagen completa durante la etapa de ejecución. Por lo tanto se describe de una mejor manera la señal de movimiento.

Los resultados experimentales confirman un funcionamiento satisfactorio de la implementación de la metodología cuando se prueba con un paciente en particular. Los resultados de las pruebas realizadas con los otros pacientes, sugieren el planteamiento de sistemas clasificadores que consideren las diferencias en los movimientos propios de los ojos para diversos pacientes.

Sobre la base de los resultados obtenidos en el desarrollo de este proyecto de investigación y su pertenencia a un proyecto mayor que consiste en el desarrollo de una interfaz humano máquina basada en el movimiento de un ojo, se pueden plantear algunos desarrollos posteriores, tales como el diseño e implementación de otras estrategias de discriminación y su comparación con la técnica actual. El desarrollo de una aplicación que sintonice de forma automática los sistemas difusos para un paciente nuevo. El diseño e implementación de un sistema de control para un dispositivo que pertenezca al ambiente del paciente y la implementación de una estructura (un casco) que soporte la cámara y el sistema de iluminación, pero que evite los movimientos de la cabeza.

Queremos agradecer a los miembros del Laboratorio de Automática, Microelectrónica e Inteligencia Computacional por su apoyo durante la realización de este proyecto. Especialmente al asistente de investigación John Jairo Rodríguez por la colaboración prestada y al Ing. Miguel Melgarejo por la asesoría durante el desarrollo de éste proyecto.

[1] Toro G. J., Neurología, Mc Graw-Hill Interamericana, Bogotá, 2001. pp. 220

[2] Amyotrophic lateral sclerosis (ALS) therapy development foundation, http://www.als.net/als101/whatisals.asp.

[3] C. Pérez, A. Palma, C. Holzmann, C. Peña. Face and Eye Tracking Algorithm Based on Digital Image Processing. Proc of IEEE International Conference on Systems, Man, and Cybernetics, vol 2, pp 1178-1183, 2001.

[4] J. Deng, F. Lai, Region based template deformation and masking for eye feature extraction and description, Patern Recognition, Vol. 30, No. 3, 1997, pp 403-419.

[5] Kyung-Nam Kim, R. S. Ramakrishna, «Vision-Based Eye-Gaze Tracking for Human Computer Interface», IEEE International Conf. on Systems, Man, and Cybernetics, Tokyo, Japan, Oct.1999

[6] Chau Michael, Betke Margrit, «Real Time Eye Tracking and Blink Detection with USB Cameras», Boston University Computer Science Technical Report No. 2005-12, Boston, USA, May. 2005.

[7] M. Betke J. Gips, and P. Fleming, «The Camera Mouse: Visual Tracking of Body Features to Provide Computer Access For People with Severe Disabilities.» IEEE Transactions on Neural Systems and Rehabilitation Engineering, Vol. 10, No. 1, pp. 1-10, March 2002.

[8] W. Almageed, M. Fadali, G. Bebis. A Non intrusive Kalman Filter Based Tracker for Pursuit Eye Movement. Proc of 2002 International Control Conference, Vol. 2, pp 380-385, 2002.

[9] L. Yin, S. Bernögger. Synthesizing realistic facial animatioins using energy minimization for model-based coding. Pattern Recognition Vol.34, No.11, November 2001, Elsevier Science, pp2201-2213

[10] W. Zorski, B. Foxon. Fingerprint and Iris Identification Method Based on the Hough Transform. Biuletyn Instytutu Automatyki I Robotyki Wat, NR 15, pp 43-53, 2001.

[11] A. Kavianpour, S. Shoari, N. Bagherzadeh, A New Approach for Circle Detection on Multiprocessors, Journal of Parallel and Distributed Computing, Vol 20, No. 2, pp 256-60, February 1994.

[12] A. Guyton y J. Hall, Tratado de fisiología médica, Mc Graw-Hill Interamericana, 10ª ed, pp 677-739, 1998.

[13] B. Martin del Brio y A. Sanz. Redes Neuronales y Sistemas Difusos. Editorial Alfa Omega, México.2002. pp. 10-90.

[14] F. Rubio, J. Rodríguez, Desarrollo de una Metodología para seguir y Discriminar el Movimiento de un Ojo Humano en Tiempo Real, Universidad Distrital, 2005.

[15] R. González y R. Woods. Tratamiento digital de imágenes. Editorial Addison-Wesley Iberoamericana, Wilmington, 1996, pp. 180-205, 478-494

[16] J. Russ, The image processing handbook, 2nd edition, CRC Press, 1995, pp. 213-225, 347-371.

Fidelia Milena Rubio Ramos.

Ingeniera Electrónica Universidad Distrital Francisco José de Caldas. Pertenece como asistente de investigación al grupo LAMIC desde agosto de 2004. Actualmente se encuentra diseñando el sistema de trazabilidad para el Sistema de Abastecimiento de Alimentos de Bogotá (SAAB) en la Universidad Distrital Francisco José de Caldas ingfideliarubio@gmail.com

Alvaro Betancourt Uscátegui

Ingeniero Electrónico Universidad Distrital Francisco José de Caldas. Especialista en Telecomunicaciones Móviles, Universidad Distrital. MSc. Ciencias Financieras y de Sistemas, Universidad Central. Magíster en Ingeniería, Informatique Appliquée, Ecole Polytechnique Université de Montreal, Canadá. Profesor Titular Facultad de Ingeniería Universidad Distrital. Director del grupo de Investigación LAMIC, Universidad Distrital. alvarobetancourt@gmail.com