DOI:

https://doi.org/10.14483/2322939X.10522Published:

2016-06-02Issue:

Vol. 12 No. 1 (2015)Section:

Research and DevelopmentLa calidad en objetos de aprendizaje empleando el eMM

Learning Objects Quality Using eMM

Keywords:

Gestión de la calidad, método delphi, modelo de madurez de e-Learning (eMM), objeto de aprendizaje (es).Keywords:

Quality management, delphi method, e-Learning maturity model (eMM), learning object. (en).Downloads

References

IEEE, “IEEE LTSC”. (2005). [En línea] Disponible en: http://ltsc.ieee.org/

Dahl, O. J. and Nygaard, K., “SIMULA - An algol based simulation language”, Communications of the ACM, Vol 9 No 9. pp. 671-678, 1996.

Velázquez, C., Álvarez, F. J., y Cardona J. P., “Determinación de la Madurez en el Desarrollo de Objetos de Aprendizaje empleando el Modelo de Madurez para E-learning”, en libro

electrónico, XXIII Congreso Nacional y IX Congreso Internacional de Informática y Computación 2010, Alfa Omega, Puerto Vallarta, Jalisco, México, 2010.

The Institute For Higher Education Policy, “QUALITY ON THE LINE: Benchmarks for Success in Internet-Based Distance Education”, 2000. [En línea], Disponible en: http://www.abanet.org/legaled/distanceeducation/QualityOnTheLine.pdf

Marshall S. and Mitchell G., “Benchmarking International E-learning Capability with the ELearning Maturity Model”, in Proceedings of EDUCAUSE in Australasia, Melbourne, 2007.

Marshall S., “New Zealand Tertiary Institution E-Learning Capability: Informing and Guiding ELearning Architectural Change and Development Project Report”, Report to the New Zealand Ministry of Education. Victoria University of Wellington, New Zealand, 2006. [En línea] Disponible en: http://www.utdc.vuw.ac.nz/research/emm/Publications.shtml

Marshall S., eMM Version Two Process Assessment Workbook. Wellington: Victoria University of Wellington, 2006.

Marshall S. and Mitchell G., “Potential Indicators of e-Learning Process Capability”, Proceedings of EDUCAUSE in Australasia 2003, Adelaide, Australia, 2003.

Landeta, J., El método Delphi, Barcelona; Ariel, 1999.

Utkin, L. V. “A method for processing the unreliable expert judgments about parameters of probability distributions”, European Journal of Operational Research, Vol 175 No 1, pp. 85-

(2002).

D. Furnish et al., AIP Conference Proceedings 620, American Institute of Physics, Melville, NY, pp. 651-654, 2002.

Alea, V., Guillen, M., et. al., Estadística con SPSS v.10.0, Barcelona: Ediciones de la Universidad de Barcelona, 2000.

How to Cite

IEEE

ACM

ACS

APA

ABNT

Chicago

Harvard

MLA

Turabian

Vancouver

Download Citation

Visitas

Downloads

La calidad en objetos de aprendizaje empleando el eMM

Learning Objects Quality Using eMM

Recibido: 18-enero-2015

Modificado: 20-enero-2015

Aprobado: 08-febrero-2015

César Eduardo Velázquez Amador

Doctor, Universidad Autónoma de Aguascalientes, México. Correo electrónico: vace555@hotmail.com

Denisse Anaid Macías Miramontes

Maestro en Ciencias, Universidad Autónoma de Aguascalientes, México. Correo electrónico: anaidmacias@hotmail.com

Francisco Javier Álvarez Rodríguez

Doctor, Universidad Autónoma de Aguascalientes, México. Correo electrónico: fjalvar@correo.uaa.mx

Félix Patlán Balandrán

(c)Doctor, Universidad Autónoma de Aguascalientes, México. Correo electrónico: fpatlan@correo.uaa.mx

Resumen

Este artículo tiene por objetivo presentar la creación de herramientas que ayuden en la administración de la calidad en el desarrollo de objetos de aprendizaje (OAs) tomando como base el modelo de madurez de e-Learning (eMM). En primer término se eligió el área de desarrollo del eMM, posteriormente se identificaron y se establecieron los procesos pertenecientes al área de proceso seleccionada para comenzar con el trabajo de traducción, depuración e interpretación para cada práctica. Se creó un panel de expertos para la validación de los instrumentos y se emplearon los métodos Delphi y de Kendall para obtener las conclusiones finales.

Palabras clave

Gestión de la calidad, método delphi, modelo de madurez de e-Learning (eMM), objeto de aprendizaje.

Abstract

This article was carried out with the aim of creating tools to help in quality management for the development process of learning objects (LOs) based on Model Maturity of e- Learning called eMM (e -Learning Maturity Model). First area of eMM development process was chosen, subsequently identified and established processes of the process area chosen and began with the work of translation, purification, aggregation and interpretation for each practice. For the validation of the instruments a panel of experts was created and the Delphi and Kendall method was used to obtain the final conclusions.

Keywords

Quality management, delphi method, e-Learning maturity model (eMM), learning object.

1. INTRODUCCIÓN

En el presente trabajo se expone la forma en que se puede determinar la madurez de una organización en el desarrollo de objetos de aprendizaje (OAs) y la forma en que se crearon y validaron los instrumentos para este fin. Para lo anterior se tomó como base el eMM, el cual es un modelo de madurez para el e-Learning.

El trabajo proporciona en primer lugar una introducción a los objetos de aprendizaje, los modelos de madurez y el eMM. A continuación, se expone el proceso de adecuación del eMM para generar los instrumentos que permitan la gestión de la calidad en el desarrollo de objetos de aprendizaje. Finalmente se presentan los instrumentos generados y los resultados de la validación de los mismos.

Los objetivos que se persiguieron en la investigación, de la cual se desprende el presente trabajo, fueron el adaptar el eMM en la creación de instrumentos para la gestión de la calidad en el desarrollo de objetos de aprendizaje y la validación de los mismos. No existe una definición completamente aceptada del término objeto de aprendizaje, una definición es: “Una entidad digital o no digital, la cual puede ser usada, reusada o referenciada durante el aprendizaje soportado por la tecnología” [1]. La orientación a objetos favorece los valores de la creación de componentes (llamados objetos) que pueden ser reutilizados en múltiples contextos [2]. Los OAs son recursos docentes que pretenden apoyar la adquisición de habilidades educativas y pueden ser aplicados en diferentes ambientes de aprendizaje, como lo son: los formales, semi formales e informales, esto incluye también a las comunidades virtuales. El conocimiento de la madurez de una organización en sus procesos es importante ya que proporciona lineamientos para una mejora de los mismos en el desarrollo de software, al indicar de manera objetiva qué prácticas se tienen institucionalizadas y qué prácticas hacen falta definir a nivel organizacional. Algunos de los marcos de referencia para la mejora de procesos de software que más se han empleado en la determinación del nivel de madurez de las organizaciones que desarrollan software son el CMM y el SPICE.

El problema que existe con el desarrollo de OAs es que este proceso no siempre está alineado a uno de gestión de calidad bien definido. Se ha encontrado que muchos de esos procesos no incluyen instrumentos que auxilien el de gestión de calidad. De lo anterior se desprende que un OA debe de ser desarrollado con lineamientos que lo guíen a la mayor calidad posible de acuerdo con las exigencias de cada área donde será aplicado, de aquí la importancia de que se apliquen instrumentos que ayuden en el proceso de gestión de calidad, como lo hace en general el e-Learning con el modelo de madurez e-Learning Maturity Model (eMM) [3].

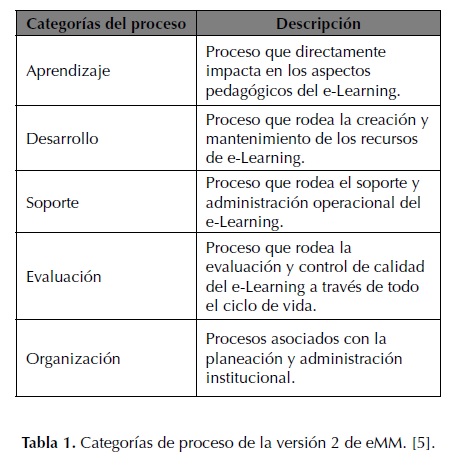

Los creadores del modelo de madurez de e-Learning, Marshall y Mitchell, tomando como base el documento de Quality on the Line: Benchmarks for Success in Internet-Based Distance Education [4], dieron a conocer el eMM en 2002. Este modelo ha tenido cambios, y en su segunda versión se tienen definidas cinco categorías para organizar los procesos y las prácticas que contribuyen a un efectivo desempeño de los procesos individuales relacionados al desarrollo del e-Learning [5], estas categorías se muestran en la tabla 1.

La principal diferencia con el modelo SPICE, al definir las categorías o áreas de proceso, es la introducción del área de aprendizaje, la cual reemplaza el área de cliente/proveedor que es usada en ingeniería de software [6].

En el eMM la capacidad se refiere a la habilidad de una institución de asegurar que el diseño, desarrollo y despliegue del e-Learning se hace conforme a las necesidades de los estudiantes, personal de apoyo y la institución. Críticamente la capacidad incluye la habilidad de una institución de sostener la entrega de e-Learning y del soporte de la enseñanza y aprendizaje con crecimientos en la demanda y cambios en el personal de apoyo [7].

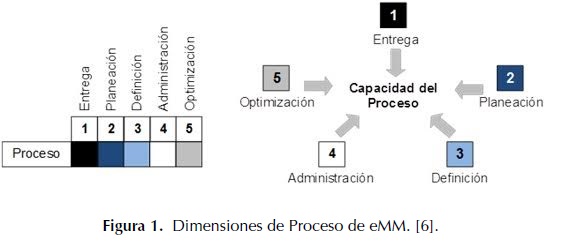

Originalmente el modelo reutilizó de CMM y SPICE el concepto de nivel, pero en la segunda versión adoptó el concepto de dimensión para referirse al grado de capacidad, considerando que una organización que ha desarrollado capacidad en todas las dimensiones para todos los procesos será más capaz que una que no lo ha hecho [6].

Al pensar en la relación entre las cinco dimensiones definidas en eMM, es útil considerarlas ordenadas como en la figura 1. La matriz de cajas usada a la izquierda para mostrar el resumen de las capacidades de proceso es útil cuando realizamos comparaciones dentro o entre instituciones.

Cada una de las cinco dimensiones refleja un aspecto de la capacidad del proceso desde una perspectiva única [6].

- La dimensión 1 (entrega) se refiere a la creación y abastecimiento de los productos del proceso. Evalúa el grado en que se ve que opera el proceso en la institución.

- La dimensión 2 (planeación) evalúa el uso de los objetivos y planes predefinidos en la conducción del trabajo del proceso.

- La dimensión 3 (definición) cubre el uso durante el proceso de implementación de los estándares, líneas guía, patrones y políticas institucionalmente definidos y documentados

- La dimensión 4 (administración) se refiere a cómo maneja la institución el proceso de implementación y asegura la calidad de sus productos.

- La dimensión 5 (optimización) captura la extensión con que una organización usa un acercamiento formal para mejorar su capacidad. La capacidad de esta dimensión refleja una cultura de mejora continua.

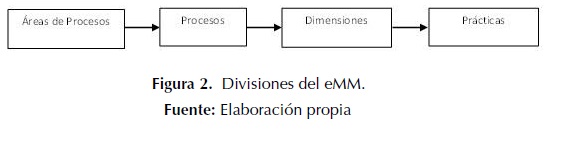

Cada proceso en el eMM es dividido dentro de cada dimensión en prácticas que definen cómo logrará la institución los productos del proceso. Las prácticas intentan capturar las esencias clave de las diferentes dimensiones de los procesos como una serie de ítems. Las divisiones del eMM se aprecian en la figura 2

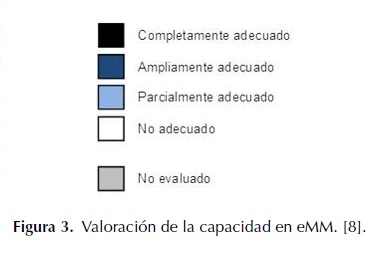

Cuando se conduce la evaluación de un proceso, cada práctica es evaluada en su desempeño con valores desde no adecuado hasta completamente adecuado como se puede observar en la figura 3. Una vez que cada práctica ha sido evaluada, el resultado es promediado para valorar la dimensión

2. METODOLOGÍA

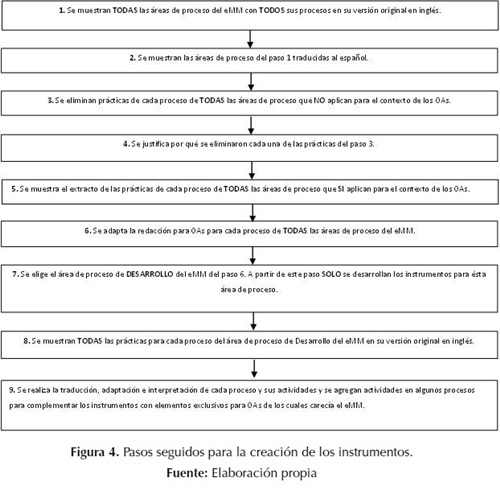

En esta sección se presenta la metodología seguida para la creación de los instrumentos que ayuden en la gestión de calidad en el desarrollo de OAs basados en el eMM. El proceso completo seguido se puede apreciar en la figura 4.

De todas las áreas de proceso, se decidió seleccionar la de desarrollo para la adaptación a objetos de aprendizaje. Además de haber elegido dicha área, se realizó un zoom a este proceso y se eliminaron, también, los procesos que pertenecen a esta área de proceso que quedan fuera del alcance de la investigación por no relacionarse con los OAs, dejando como resultado un total de cuatro procesos los cuales son el proceso D1, D2, D3 y D7, que se explican más adelante, de los siete que originalmente el eMM tiene en esta área.

Es importante recalcar que es necesaria la adaptación debido a que el eMM abarca todo el proceso de e-Learning, pero nos interesa centrar la atención únicamente en los recursos instruccionales, que en este caso son los objetos de aprendizaje.

Al haber elegido el área de proceso base para la creación de los instrumentos y sus procesos, se siguió una fase de traducción, adaptación, interpretación y adecuación de las actividades por cada dimensión de cada uno de los cuatro procesos elegidos para diseñar los instrumentos.

3. RESULTADOS

Una vez que se siguieron los pasos presentados en la metodología, se obtuvieron los instrumentos para los siguientes procesos (ya adaptados a objetos de aprendizaje):

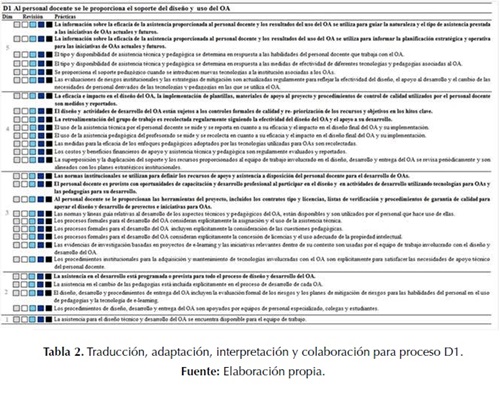

3.1 D1. Al personal docente se le proporciona el soporte del diseño y uso del OA

La justificación de la capacidad en este proceso se ve en la disponibilidad de asistencia técnica y desarrollo del personal para toda la gama de tecnologías que se ofrecen en la institución, junto con la asistencia de expertos en el diseño de los enfoques pedagógicos para los cursos. Con el acceso a este apoyo se logra asegurar el uso eficiente y equitativo de tiempo y el logro de los objetivos estratégicos, así como las necesidades a corto plazo. Los enfoques eficaces en el contexto institucional se comunican a través de ejemplos, estudios de casos, normas y directrices para la institución, así como durante el entrenamiento para el personal docente.

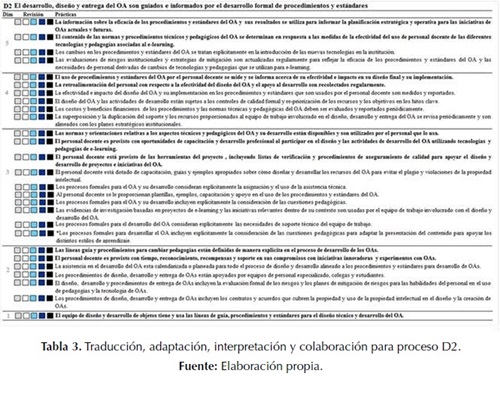

3.2 D2. El desarrollo, diseño y entrega del OA es guiado e informado por el desarrollo formal de procedimientos y estándares

La justificación de la capacidad en esta área es vista a través de la utilización de la práctica constante, documentadas porque reúsan la experiencia previa dentro de la institución para construir capacidad.

Las normas formales son utilizadas cuando estén disponibles para informar y guiar la práctica, así como garantizar la calidad y la reutilización de materiales. Estas normas y directrices se dan a conocer ampliamente dentro de la institución para fomentar una adopción más extensa por el personal docente

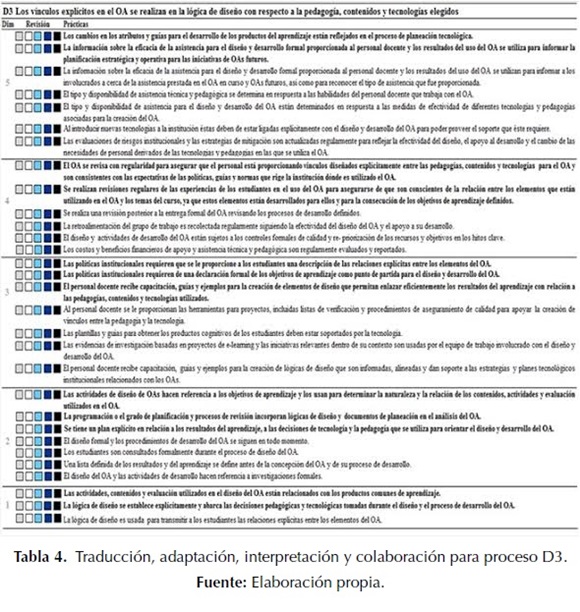

3.3 D3. Los vínculos explícitos en el OA se realizan en la lógica de diseño con respecto a la pedagogía, contenidos y tecnologías elegidas

La justificación de la capacidad en esta área es vista con el uso de los procesos de diseño y planes explícitos que enlazan las decisiones de tecnología con los resultados de aprendizaje de los estudiantes previamente definida sus atributos. Esto también incluye la realización de la lógica del diseño subyacente y la pedagogía evidente para los estudiantes cuando son orientados sobre cómo se utilizará la tecnología en el OA en particular. Al personal docente se proporcionan con las plantillas, ejemplos, formación y apoyo en el uso de la gama de tecnologías disponibles para apoyar el aprendizaje de los estudiantes en una variedad de contextos y disciplinas.

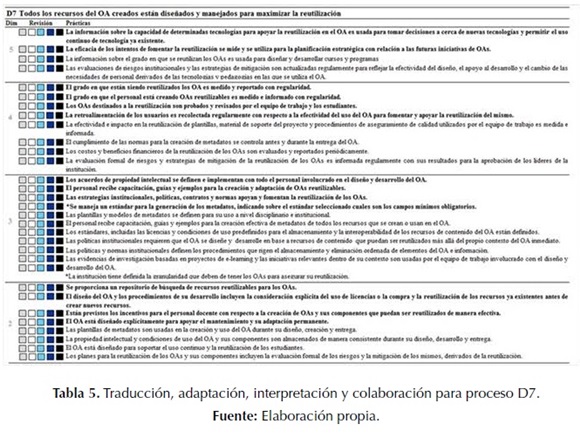

3.4 D7. Todos los recursos del OA creados están diseñados y manejados para maximizar la reutilización

La justificación de la capacidad en este proceso es vista a través de la creación y el uso de estándares de metadatos y plantillas, junto con los depósitos de almacenamiento y acceso a los recursos del curso para su reutilización. El personal docente debe recibir capacitación y apoyo en la creación y reúso de los recursos, así como debe ser informado de los incentivos, tanto al crear recursos reutilizables en primer lugar, como al permitir la reutilización de los mismos

En las tablas 2, 3, 4 y 5 se presentan los instrumentos con su serie de actividades por dimensión para el área de proceso de desarrollo para cada uno de los procesos: D1, D2, D3 y D7 respectivamente.

Se recurrió al método Delphi [9] para llevar a cabo la validación de los instrumentos generados. En la aplicación del método, primeramente se obtuvo por parte del panel de expertos el grado de concordancia entre cada uno de los criterios a evaluar de los instrumentos; posteriormente, luego de atender las observaciones de los expertos, se enviaron nuevamente los instrumentos a los expertos para su evaluación. Finalmente, se obtuvieron las conclusiones. A continuación se lista el proceso de validación usado en la investigación.

- El investigador elaboró el cuestionario (primera ronda método Delphi)

- El panel de expertos dio respuesta al cuestionario

- El investigador realizó: a) análisis cualitativo y cuantitativo de las respuestas del grupo, uso de Frecuencias Relativas y Kendall [10]; b) envío de justificación de observaciones del cuestionario hacia los instrumentos (segunda ronda método Delphi).

- El panel de expertos realizó la lectura de la justificación de observaciones y resultados obtenidos.

- El investigador realizó las conclusiones en base a los resultados obtenidos.

Una vez recolectados los datos obtenidos por medio de método Delphi, se procedió a analizarlos empleando el método Kendall, siguiendo el siguiente procedimiento.

- Se muestra un listado inicial de posibles personas que cumplen con los requisitos para ser expertos en el tema de la investigación. Se propusieron nueve personas, ya que resultó una tarea complicada encontrar a expertos relacionados no solamente al área de OAs, sino también en eMM y en Calidad de OAs.

- Se realiza una valoración sobre el nivel de experiencia que posee cada experto, evaluando los niveles de conocimientos que poseen sobre la materia. Para ello se realiza una primera pregunta para una autoevaluación de los niveles de información y argumentación que tienen sobre el tema en cuestión. En esta pregunta se les pide que marquen con una X, en una escala creciente del 1 al 10, el valor que corresponda con el grado de conocimiento o información que tienen sobre el tema a estudiar. Por ejemplo: “¿Qué tan experto se es en el área de objetos de aprendizaje?, Marque del 1 al 10 con una ‘X’ el valor que más le identifique siendo 1 el menor y 10 el mayor”. En este punto se obtuvo el valor de 10 por cada uno de los nueve expertos.

- A partir de ese valor se calculó el coeficiente de conocimiento o información (Kc) para cada experto, a través de la siguiente fórmula: Kc = n(0,1), obteniendo el Kc=1 para cada uno de los nueve expertos.

- Se realizó una segunda ronda de preguntas para cada investigador que permite valorar un grupo de aspectos que influyen sobre el nivel de argumentación o fundamentación del tema a estudiar y se evaluó en base a una tabla de seis valores patrón que ofrece el método Delphi.

- Los aspectos que influyen sobre el nivel de argumentación o fundamentación del tema de investigación permiten calcular el coeficiente de argumentación (Ka) de cada experto, estos aspectos se toman de los valores obtenidos en el paso 4: Ka =a, ni = (n1 + n2 + n3 + n4 + n5… n6) obteniendo para siete de los expertos un coeficiente de argumentación de 1 y para dos de los expertos de 0,97.

- Una vez obtenido el Kc y Ka se procede a obtener el valor del coeficiente de competencia (K), el cual es el coeficiente que determina en realidad qué experto se toma en consideración para trabajar en esta investigación. Este se calcula con la siguiente fórmula: K = 0,5 (Kc + Ka). Al obtener los resultados de K, se valoran de la siguiente manera: Si 0,8 < K < 1,0 coeficiente de competencia alto; si 0,5 < K < 0,8 coeficiente de competencia medio; y si K < 0,5 coeficiente de competencia bajo.

- Se trabajó con los expertos que dieron como resultado un coeficiente de competencia alto, no obstante pueden valorar si se utilizan expertos de competencia media en caso de que el coeficiente de competencia promedio de todos los posibles expertos sea alto, pero nunca se utilizará expertos de competencia baja. Para esta investigación se obtuvieron expertos de coeficiente de competencia alto.

Una vez que se seleccionaron los expertos se les presentan los aspectos a valorar para la evaluación de los instrumentos previamente determinados por el investigador, a través de una tabla de Aspectos / Rangos de Valoración. Los rangos de valoración para los instrumentos son cinco, es decir, Muy adecuado (MA), Bastante adecuado (BA), Adecuado (A), Poco adecuado (PA) e Inadecuado (I), a los que asignamos valor numérico del uno al cinco en el mismo orden. Este proceso se describe a continuación:

- Primero se les hizo llegar a los expertos la descripción del problema con una breve introducción, un breve marco teórico y la explicación del eMM y su evaluación en base a instrumentos, se les mostró el proceso de creación de los instrumentos en una forma acotada y al final se les pidió que respondieran la encuesta con base en los criterios que se seleccionaron por el investigador para poder valorar la propuesta. Las respuestas de los expertos fueron llegando y en ellas se recogieron los elementos enriquecedores de las aportaciones de los expertos.

- Se realizó una evaluación estadística para determinar la frecuencia en cuanto a los criterios y valoración de estos, se muestra en el resultado un pequeño análisis de los datos que guían a la conclusión de la investigación.

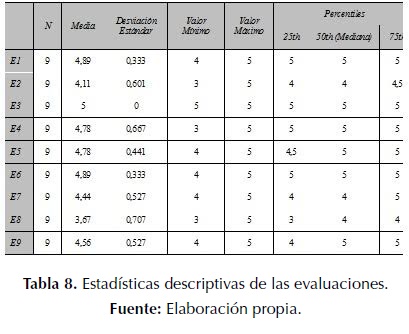

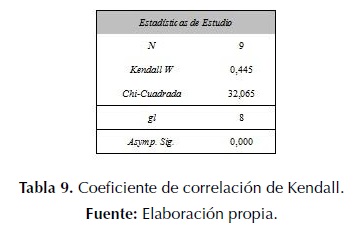

- Finalmente se obtuvieron una tabla con la estadística descriptiva de las evaluaciones realizadas por los expertos y se calculó el grado de concordancia de Kendall. Las estadísticas descriptivas de las evaluaciones realizadas por los expertos se presentan en la tabla 8, y los cálculos del coeficiente de correlación de Kendall se muestran en la tabla 9

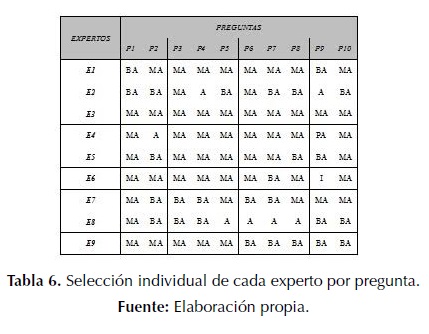

En la tabla 6 se presenta la selección individual de cada experto por pregunta.

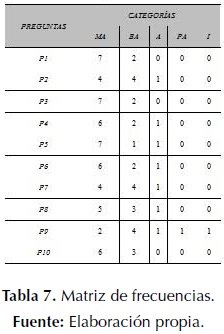

Posteriormente se obtiene la tabla matriz de frecuencias [11]; para el caso de la presente investigación, la matriz de frecuencias se muestra en la tabla 7.

Para el nivel de concordancia de Kendall se establecen las siguientes hipótesis:

Ho. Si W < 0 No existe concordancia entre las opiniones de los expertos con respecto a los instrumentos creados.

H1. Si W > 0 Si existe concordancia entre las opiniones de los expertos con respecto a los instrumentos creados.

De los resultados del coeficiente de correlación de Kendall mostrados en la tabla 9 se obtiene que el grado de acuerdo de los expertos es de 0,445 lo cual se encuentra entre los valores establecidos de Muy Adecuado y Bastante Adecuado

La significancia obtenida fue de 0,000 lo cual es menor a 0,05 lo que indica que los expertos sí se encuentran en un acuerdo con respecto a la creación de los instrumentos, todo lo anterior en definitiva resulta favorable para la investigación.

De los resultados se puede afirmar que los instrumentos son considerados como válidos y son calificados como Bastante Adecuados debido a que la mayoría obtuvo el valor de cuatro, el cual se refiere a Bastante adecuado. Se observa también que los valores de la media se acercan bastante al valor de cinco, lo cual también resulta positivo.

Finalmente, una vez analizados los datos, se envió a los expertos una retroalimentación de acuerdo a las inquietudes y observaciones que se hicieron a los instrumentos creados. Para con esto dar fin al método de investigación aplicado. Cabe señalar que aunque el panel de expertos no se encontraba en un mismo lugar, los resultados obtenidos fueron similares a los de una lluvia de ideas.

4. CONCLUSIONES

Como conclusiones se logró la creación de los instrumentos para realizar la gestión de calidad en el desarrollo de OAs, tomando como base el eMM. Al ser validados los instrumentos por expertos de diferentes países e instituciones utilizando el método Delphi y el coeficiente de correlación de Kendall y habiendo obtenido una valoración positiva, se tiene la confianza de poderse aplicar estos instrumentos en una organización para mejorar el proceso de desarrollo de sus objetos de aprendizaje. Como estudio futuro se contempla la aplicación práctica de los instrumentos obtenidos con la finalidad de hacer una validación por uso; adicionalmente, se tiene como finalidad el desarrollo de los instrumentos para las otras áreas de proceso y con ello poder aportar una herramienta completa para la gestión de calidad en el desarrollo de OAs en todas las áreas de proceso que ofrece el eMM.

5. REFERENCIAS

[1] IEEE, “IEEE LTSC”. (2005). [En línea] Disponible en: http://ltsc.ieee.org/

[2] Dahl, O. J. and Nygaard, K., “SIMULA - An algol based simulation language”, Communications of the ACM, Vol 9 No 9. pp. 671-678, 1996.

[3] Velázquez, C., Álvarez, F. J., y Cardona J. P., “Determinación de la Madurez en el Desarrollo de Objetos de Aprendizaje empleando el Modelo de Madurez para E-learning”, en libro electrónico, XXIII Congreso Nacional y IX Congreso Internacional de Informática y Computación 2010, Alfa Omega, Puerto Vallarta, Jalisco, México, 2010.

[4] The Institute For Higher Education Policy, “QUALITY ON THE LINE: Benchmarks for Success in Internet-Based Distance Education”, 2000. [En línea], Disponible en: http://www.abanet.org/legaled/ distanceeducation/QualityOnTheLine.pdf

[5] Marshall S. and Mitchell G., “Benchmarking International E-learning Capability with the ELearning Maturity Model”, in Proceedings of EDUCAUSE in Australasia, Melbourne, 2007.

[6] Marshall S., “New Zealand Tertiary Institution E-Learning Capability: Informing and Guiding ELearning Architectural Change and Development Project Report”, Report to the New Zealand Ministry of Education. Victoria University of Wellington, New Zealand, 2006. [En línea] Disponible en: http://www.utdc.vuw.ac.nz/ research/emm/Publications.shtml

[7] Marshall S., eMM Version Two Process Assessment Workbook. Wellington: Victoria University of Wellington, 2006.

[8] Marshall S. and Mitchell G., “Potential Indicators of e-Learning Process Capability”, Proceedings of EDUCAUSE in Australasia 2003, Adelaide, Australia, 2003.

[9] Landeta, J., El método Delphi, Barcelona; Ariel, 1999.

[10] Utkin, L. V. “A method for processing the unreliable expert judgments about parameters of probability distributions”, European Journal of Operational Research, Vol 175 No 1, pp. 385- 398. (2002).

[11] D. Furnish et al., AIP Conference Proceedings 620, American Institute of Physics, Melville, NY, pp. 651-654, 2002.

[12] Alea, V., Guillen, M., et. al., Estadística con SPSS v.10.0, Barcelona: Ediciones de la Universidad de Barcelona, 2000.

3.png)