DOI:

https://doi.org/10.14483/22487638.22525Publicado:

30-09-2025Número:

Vol. 29 Núm. 85 (2025): Julio - SeptiembreSección:

InvestigaciónRobot móvil para agarre de objetos por color, con visión artificial y control difuso Mamdani

Mobile robot capable to grasp color objects using Mamdani fuzzy control and artificial vision

Palabras clave:

artificial vision, fuzzy logic, fuzzy reasoning, PD fuzzy control (en).Palabras clave:

control difuso PD, lógica difusa, razonamiento difuso, visión artificial (es).Descargas

Resumen (es)

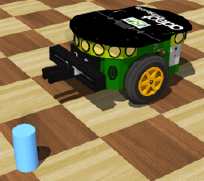

Contexto: este trabajo analizó la movilización autónoma de un robot diferencial simulado, por medio de un sistema de control PD, retroalimentado con una cámara a bordo. Tanto el controlador como el proceso de segmentación de imágenes en tiempo real utilizan un sistema de inferencia difusa tipo Mamdani.

Metodología: se dotó al robot con un sistema de percepción visual para identificar un objeto de cierto color, en la imagen capturada por su cámara, con el fin de que el controlador reaccione según la ubicación variable del objeto. Se hicieron pruebas con el objeto estático y en movimiento, además de modificar las condiciones de iluminación ambiental.

Resultados: se observó la efectividad de dichos sistemas difusos para movilizar el robot, ya que este logra acercarse y posicionarse para poder agarrar el objeto identificado en su campo visual. En el caso de no verlo, el robot panea hasta encontrarlo, si existe.

Conclusiones: los sistemas difusos empleados fueron suficientes y eficientes para el control de un robot móvil que requiere de la información cromática que provee una cámara abordo. Su diseño, basado en términos lingüísticos que representan nociones intuitivas sobre el comportamiento necesario, permite introducir a estudiantes interesados en el campo de la robótica móvil con visión artificial. A futuro, se podría combinar con otros sistemas basados en lenguaje natural, en una sociedad artificial de robots.

Resumen (en)

Context: Autonomous mobilization of a simulated differential robot, by means of a PD control system with onboard camera feedback, where both the controller and the real-time image segmentation use Mamdani-type fuzzy inference.

Methodology: The robot was equipped with a visual perception system to identify an object of a specific color, in the image captured by its camera, so that the controller could react according to the object’s changing position. Tests were carried out with the object both stationary and in motion, as well as varying ambient lightning conditions. Results: The effectiveness of the fuzzy systems was observed in enabling the robot to move toward the object identified in its visual field in order to grasp it. If the object is not initially visible, the robot pans until it finds it, provided it exists.

Conclusions: The employed fuzzy systems were sufficient and efficient for controlling a mobile robot that relies on chromatic information provided by an onboard camera. Their design, based on linguistic terms representing intuitive notions of the required behavior, makes them suitable for introducing students interested in robotics and computer vision. In the future, it appears feasible to combine such systems with other natural language-based approaches within an artificial society of robots.

Referencias

[1] M. S. Güzel, “Autonomous vehicle navigation using vision and mapless strategies: a survey”, Adv. Mech. Eng., vol. 5, pp. 234747, 2013.

[2] A. Krizhevsky, I. Sutskever, y G. E. Hinton, “Imagenet classification with deep convolutional neural networks”, Adv. Neural Inf. Process. Syst., vol. 25, 2012.

[3] R. Girshick, J. Donahue, T. Darrell et al., “Rich feature hierarchies for accurate object detection and semantic segmentation”, en Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2014, pp. 580-587.

[4] J. Redmon, S. Divvala, R. Girshick et al., “You only look once: unified, real-time object detection”, en Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016, pp. 779-788.

[5] W. B. Shen, D. Xu, Y. Zhu et al., “Situational fusion of visual representation for visual navigation”, en Proceedings of the IEEE/CVF International Conference on Computer Vision, 2019, pp. 2881-2890.

[6] H. Rashed, M. Ramzy, V. Vaquero et al., “Fusemodnet: real-time camera and lidar based moving object detection for robust low-light autonomous driving”, en Proceedings of the IEEE/CVF International Conference on Computer Vision Workshops, 2019.

[7] T. Zhou, M. Brown, N. Snavely et al., “Unsupervised learning of depth and ego-motion from video”, en Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017, pp. 1851-1858.

[8] E. Jung, N. Yang, y D. Cremers, “Multi-frame GAN: image enhancement for stereo visual odometry in low light”, en Conference on Robot Learning, PMLR, 2020, pp. 651-660.

[9] J. Cheng, P. Liu, Q. Zhang et al., “Real-time and efficient 6-D pose estimation from a single RGB image”, IEEE Trans. Instrum. Meas., vol. 70, pp. 1-14, 2021.

[10] W. Chen, J. Duan, H. Basevi et al., “PointPoseNet: point pose network for robust 6D object pose estimation”, en Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision, 2020, pp. 2824-2833.

[11] Y. Becerra y D. G. Sterpin Buitrago, “Actividades de construcción sencillas desarrolladas por sistemas aéreos no tripulados”, Tecnura, vol. 27, n.º 76, pp. 12-30, jul. 2023, DOI: https://doi.org/10.14483/22487638.18612

[12] Y. A. Becerra-Mora y S. Soto-Gaona, “Seguimiento y agarre de objetos en movimiento empleando manipuladores aéreos robóticos: un breve resumen”, Rev. UIS Ing., vol. 22, n.º 4, pp. 115-128, nov. 2023, DOI: https://doi.org/10.18273/revuin.v22n4-2023011

[13] V. Ortenzi, N. Marturi, R. Stolkin et al., “Vision-guided state estimation and control of robotic manipulators which lack proprioceptive sensors”, en 2016 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), IEEE, 2016, pp. 3567-3574.

[14] P. Vicente, L. Jamone, y A. Bernardino, “Towards markerless visual servoing of grasping tasks for humanoid robots”, en 2017 IEEE International Conference on Robotics and Automation (ICRA), jun. 2017, pp. 3811-3816, DOI: https://doi.org/10.1109/ICRA.2017.7989441

[15] Y. Becerra, J. León, S. Orjuela et al., “Smart manipulation approach for assistant robot”, en AETA 2018 - Recent Advances in Electrical Engineering and Related Sciences: Theory and Application, I. Zelinka, P. Brandstetter, T. Trong Dao et al., eds., Cham: Springer International Publishing, 2020, pp. 904-913.

[16] W. -J. Baek, C. Pohl, P. Pelcz et al., “Improving humanoid grasp success rate based on uncertainty-aware metrics and sensitivity optimization”, en 2022 IEEE-RAS 21st International Conference on Humanoid Robots (Humanoids), nov. 2022, pp. 786-793, DOI: https://doi.org/10.1109/Humanoids53995.2022.10000206

[17] I. Emmanuel, “Fuzzy logic-based control for autonomous vehicle: a survey”, Int. J. Educ. Manag. Eng., vol. 7, n.º 2, p. 41, 2017.

[18] E. Martínez-Martin y A. P. del Pobil, “Object detection and recognition for assistive robots: experimentation and implementation”, IEEE Robot. Autom. Mag., vol. 24, n.º 3, pp. 123-138, 2017.

[19] T.-L. Nguyen, R. Boukezzoula, D. Coquin et al., “Combination of Sugeno fuzzy system and evidence theory forNAOrobot in colors recognition”, en 2015 IEEE International Conference on Fuzzy Systems (FUZZ-IEEE), IEEE, 2015, pp. 1-8.

[20] A. Celestine y J. D. Peter, “Investigations on adaptive connectivity and shape prior based fuzzy graph-cut colour image segmentation”, Expert Syst., vol. 37, n.º 5, p. e12554, oct. 2020. DOI: https://doi.org/10.1111/exsy.12554

[21] Y. I. Daradkeh, I. Tvoroshenko, V. Gorokhovatskyi et al., “Development of effective methods for structural image recognition using the principles of data granulation and apparatus of fuzzy logic”, IEEE Access, vol. 9, pp. 13417-13428, 2021.

[22] P. Melo-Pinto, P. Couto, H. Bustince et al., “Image segmentation using Atanassov’s intuitionistic fuzzy sets”, Expert Syst. Appl., vol. 40, n.º 1, pp. 15-26, 2013

[23] M. N. Khan, M. Al Hasan, y S. Anwar, “Improving the robustness of object detection through a multi-camera-based fusion algorithm using fuzzy logic”, Front. Artif. Intell., vol. 4, p. 638951, 2021.

[24] N. Delavarpour, S. Eshkabilov, T. Bon et al., “The tractor-cart system controller with fuzzy logic rules”, Appl. Sci., vol. 10, n.º 15, p. 5223, 2020.

[25] F. del P. González, J. G. Guarnizo, y G. Benavides, “Emulation system for a distribution center using mobile robot, controlled by artificial vision and fuzzy logic”, IEEE Lat. Am. Trans., vol. 12, n.º 4, pp. 557-563, 2014.

[26] J. de J. Zavala Zavala, H. D. Vázquez Delgado, y A. de J. Ley Clemente, “Robot diferencial con lógica difusa para evadir obstáculos frontales”, Rev. Alta Tecnol. Soc., vol. 11, n.º 1, 2019.

[27] B. Wu, T. Cheng, T. L. Yip et al., “Fuzzy logic based dynamic decision-making system for intelligent navigation strategy within inland traffic separation schemes”, Ocean Eng., vol. 197, p. 106909, febr. 2020, DOI: https://doi.org/10.1016/j.oceaneng.2019.106909

[28] F. Kamil y M. Y. Moghrabiah, “Multilayer decision-based fuzzy logic model to navigate mobile robot in unknown dynamic environments”, Fuzzy Inf. Eng., vol. 14, n.º 1, pp. 51-73, 2022.

[29] M. Munadi, B. Radityo, M. Ariyanto et al., “Automated guided vehicle (AGV) lane- keeping assist based on computer vision, and fuzzy logic control under varying light intensity”, Results Eng., vol. 21, p. 101678, 2024.

[30] M. T. Ahmad, M. Greenspan, M. Asif et al., “Robust apple segmentation using fuzzy logic”, en 2018 5th International Multi-Topic ICT Conference (IMTIC), abr. 2018, pp. 1-5, DOI: https://doi.org/10.1109/IMTIC.2018.8467275

[31] J. M. Soto-Hidalgo, J. M. Alonso, G. Acampora et al., “JFML: a Java library to design fuzzy logic systems according to the IEEE Std 1855-2016”, IEEE Access, vol. 6, pp. 54952-54964, 2018, DOI: https://doi.org/10.1109/ACCESS.2018.2872777

[32] N. A. Nasruddin y F. S. Ismail, “Color segmentation and recognition using fuzzy logic human based perception approach for color vision deficiency”, 2016.

[33] Z. Li, F. Liu,W. Yang et al., “A survey of convolutional neural networks: analysis, applications, and prospects”, IEEE Trans. Neural Netw. Learn. Syst., vol. 33, n.º 12, pp. 6999-7019, 2021.

[34] C. Urrea, “Artificial intelligence-driven and bio-inspired control strategies for industrial robotics: a systematic review of trends, challenges, and sustainable innovationstoward industry 5.0”, Machines, vol. 13, n.º 8, 2025, DOI: https://doi.org/10.3390/machines13080666

[35] B. L. Quiroga Gavilán, Módulo de procesamiento de lenguaje natural para el proceso de enseñanza y aprendizaje en una sociedad de robots, trabajo final de especialización, Facultad de Ingeniería, Universidad de Buenos Aires, 2023. [En línea]. Disponible en https://lse-posgrados-files.fi.uba.ar/tesis/LSE-FIUBA-Trabajo-Final-CEIA-Leandro-Quiroga-2023.pdf

[36] Webots documentation: webots user guide, Cyberbotics, Gollion, Suiza, 2024. Disponible en https://cyberbotics.com/doc/guide/index

Cómo citar

APA

ACM

ACS

ABNT

Chicago

Harvard

IEEE

MLA

Turabian

Vancouver

Descargar cita

Licencia

Derechos de autor 2025 Dante Giovanni Sterpin Buitrago, Brayan Steven Mendivelso García, Yeyson Alejandro Becerra Mora

Esta obra está bajo una licencia internacional Creative Commons Atribución-CompartirIgual 4.0.

Esta licencia permite a otros remezclar, adaptar y desarrollar su trabajo incluso con fines comerciales, siempre que le den crédito y concedan licencias para sus nuevas creaciones bajo los mismos términos. Esta licencia a menudo se compara con las licencias de software libre y de código abierto “copyleft”. Todos los trabajos nuevos basados en el tuyo tendrán la misma licencia, por lo que cualquier derivado también permitirá el uso comercial. Esta es la licencia utilizada por Wikipedia y se recomienda para materiales que se beneficiarían al incorporar contenido de Wikipedia y proyectos con licencias similares.