DOI:

https://doi.org/10.14483/23448393.2095Published:

2006-11-30Issue:

Vol. 12 No. 1 (2007): January - JuneSection:

Science, research, academia and developmentCaracterización Automática de Imágenes Faciales

Automatic Characterization Of Face Images

Keywords:

Adquisición de imágenes faciales, antropometría facial, caracterización facial, segmentación (es).Downloads

References

M. Pantic y J.M. Rothkrantz, "Automatic Analysis of Facial Expressions: The state of the Art", IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 22, No. 12, Pág. 1424 1445, 2000.

Y.M. Huang y C.L. Huang, "Facial Expression Recognition Using Model-Based Feature Extraction and Action Parameters Classification", J. Visual Comm. And Image Representation, Vol. 8, No. 3, Pág. 278-290, 1997.

M. Pantic y J.M. Rothkrantz, "Expert System for Automatic Analysis of Facial Expression", Image and Vision Computing J., Vol. 18, No. 11, Pág. 881-905, 2000.

H. Kobayashi y F. Hara, "Facial Interaction between Animated 3D Face Robot and Human Beings", Proc. Int'l Conf. Systems, Man, Cybernetics, Pág. 3732-3737, 1997.

Q. Chen, M. Yachida y H. Wu, "Face Detection from Color Images Using a Fuzzy Pattern Matching Method". IEEE Transactions on Pattern Analysis and Machine Intelligence. Vol. 24. 2002.

M. Abdel-Mottaleb, A. Jain y R. Hsu, "Face Detection in color Images", IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 24, No. 5, Pág. 696 706, 2002.

T.F. Cootes, C.J. Taylor y G.J. Edwards, "Face Recognition Using Active Appeareance Models". Proc. Eurepean Conf. Computer Vision. Vol. 2. 1998.

J. Albergh, "Model-Based Coding. Extraction, Coding and Evaluation of Facial Model Parameters". Ph.D. Thesis. Linköping University. 2002.

S. Guangda, D. Cheng y g. Hua, "Feature Points Extraction from Faces", Research Institute of Image and graphics, Department of Electronic Engineering, Tsinghua University.

S.M. Smith y J.M. Brady, "SUSAN A new approach to Low Level Image Processing", Int. Journal of Computer Vision, Vol. 23, No. 1, Pág. 45-78, 1997.

J. Yang, A. Waibel y R. Stiefelhagen, "A Model-Based Gaze Tracking System", Interactive System Laboratories, Carnegie Mellon University, University of karlsruhe.

J.A. Chacón, J.F. López y C. Quintero, "Antropometría Facial en Niños entre 5 y 10 Años de la Ciudad de Manizales", 1999.

D. Metaxas, M. Stone y D. Decarlo, "An Anthropometric Face Model Using Variational Techniques", Proc. SIGGraph. 1998.

"Antropometry" [en línea], En línea http://www.skepdic.com/anthropo.html (Consulta: 28 de Febrero de 2004).

L.G. Farkas,, "Anthropometry of the head and Face in Medicine", Elsevier. 1984.

M. Deriche, y P.T. Jackway, "Scale-space properties of the multiscale morphological dilation-erosion", IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 18, No. 1, Pág. 36 51, 1996.

J. Yang, A. Waibel y R. Stiefelhagen, "A model-based gaze tracking system, Iteractive system Laboratories", Carnegie Mellon University, University of Karlsruhe.

T. Poggio y R. Brunelli, "Face recognition: Features versus templates", IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 15, No. 10, Pág. 1042 1052, 1993.

B. Martinkauppi, "Face Colour Under Varying Illumination Analyisis and Applications", Ph.D. Thesis, University of Oulu, 2002.

A. Salazar y F. Prieto, "Extracción y Clasificación de Posturas Labiales en Niños entre 5 y 10 Años de la Ciudad de Manizales". En DYNA, Revista de la Facultad de Minas, Medellín, Colombia. Vol. 73, No. 150, Páginas 175-188. 2006.

How to Cite

APA

ACM

ACS

ABNT

Chicago

Harvard

IEEE

MLA

Turabian

Vancouver

Download Citation

Ingeniería, 2007-00-00 vol:12 nro:1 pág:14-23

Caracterización automática de imágenes faciales

Automatic characterization of face images

Ivonne M.Mejía Gómez

Ingeniera Electrónica, Universidad Nacional de Colombia, Sede Manizales Miembro del Grupo de investigación en Percepción y Control Inteligente.

Flavio A.Prieto

Profesor, Facultad de Ingeniería y Arquitectura, Universidad Nacional de Colombia, Sede Manizales y Miembro del Grupo de Investigación en Automática de la Universidad Nacional.

Colombia Quintero G.

Profesora de la Facultad de Medicina de la Universidad de Caldas.

Resumen

En este artículo se presenta un sistema automático para la caracterización de imágenes faciales empleando técnicas de procesamiento digital de imágenes. El trabajo se orientó a la extracción de seis características del complejo facial, relacionadas con los ojos y la boca. Se discuten las etapas del sistema, como son: adquisición de la imagen facial, detección del rostro en la escena, extracción de características faciales e interpretación de las características. Se emplearon técnicas de tratamiento de la información de color, de proyecciones integra- les, y de análisis de bordes y esquinas. El sistema fue probado empleando 1320 imágenes de 660 sujetos, los cuales poseen características físicas diferentes, tales como el color de la piel, el color de los ojos, bocas y ojos grandes, entre otras.

Abstract

It's proposed an automatic system for the face images characterization using digital images processing techniques. The work was oriented to the extraction of six features of the face complex, related to the eyes and the mouth. The stages of the system are discussed, they are: face image acquisition, face detection in the scene, face features extraction and features interpretation. Processing of color data, integral projections, and edges and corners analysis techniques were used. The system was tested using 1320 images from 660 subjects, with different physical characteristics, such as the skin color, the eyes color and the mouths and eyes size.

Key words:

Face images acquisition, face anthropometry, face features, segmentation.

1. Introducción

La detección e interpretación de rostros y expresiones faciales en una escena es una tarea fácilmente realizada por un humano en base a diferentes criterios subjetivos. Por otro lado, desde el punto de vista computacional, el desarrollo de un sistema automático de análisis facial envuelve diferentes tareas, como la adquisición de la imagen facial, detección del rostro en la escena, extracción de características faciales, las cuales constituyen el proceso de caracterización, el que a su vez precede la etapa de clasificación y reconocimiento.

A través de la adquisición de la imagen facial, se obtiene la fotografía (análoga o digital) del rostro del sujeto a analizar. Los elementos empleados y su respectiva disposición en la escena afectan la calidad de la imagen, por lo cual esta es una de las etapas que más trabajo requiere, ya que de sus condiciones y resultados depende el costo computacional y la eficiencia de las etapas subsiguientes, como lo son el preprocesamiento, la segmentación y la caracterización.

La detección facial permite resolver dos tareas fundamentales, la existencia de un rostro en la imagen, y si esta existe, su posición exacta; ha sido un problema que se ha aproximado de manera holística (detección del rostro como una unidad completa) y de manera analítica (detección del rostro a partir del establecimiento de algunas características) [1]. Dentro de la primera aproximación, se tiene el modelo de distribución de puntos [2], y un análisis del histograma [3], los cuales emplean la información de bordes y de color, respectivamente. Para la segunda aproximación, se tiene, entre otros, un trabajo basado en la distribución de brillo a partir de la información de una cámara CCD [4] y un método de ajuste de patrones difusos basado en lógica difusa [5]. Para el desarrollo de este trabajo se emplea un método holístico y analítico, el cual realiza la detección facial en función del tratamiento de la imagen de color a través de una técnica de compensación de iluminación y transformación no lineal al espacio de color YCbCr, y una segmentación de regiones [6]. Para este caso, se interpreta como detección facial, la localización del rostro en la escena, y la localización del área de los ojos y de la boca.

La extracción automática de características faciales, ha sido un problema que se ha abordado desde dos puntos de vista, el método basado en plantillas (contornos activos, modelos deformables) y el método basado en características (ojos, cejas, boca, nariz) [1]. Se encuentran diversos trabajos basados en análisis de componentes principales [7], en modelos de distribución de puntos [2] y en técnicas de normalización geométrica [8]. En este trabajo, se emplea el segundo método, en el cual se emplean el detector de bordes y esquinas SUSAN [9] [10], y la técnica de proyecciones integrales [11], para la extracción de características de ojos y boca, respectivamente.

En aplicaciones médicas, el estudio de anomalías faciales en niños se realiza comparando sus medidas con datos promedio obtenidos dentro de la población a la cual pertenece el sujeto, las cuales deben presentar índices de normalidad. En la ciudad de Manizales - Colombia, la determinación de anomalías en la población infantil debe ceñirse a datos obtenidos en estudios extranjeros, llevando esto a diagnósticos incorrectos, por lo cual surge la necesidad de establecer las medidas de los niños entre 5 y 10 años a través de un sistema automático de extracción de características faciales, permitiendo analizar un mayor número de sujetos y eliminar las variaciones indeseadas que afectan el criterio de evaluación del experto.

La determinación de las diferentes medidas faciales se realiza en función de los diferentes puntos característicos del rostro, por lo cual se tiene como objetivo fundamental la localización de las comisuras internas y externas de los ojos, el centro de las pupilas de los ojos y las comisuras de la boca.

Este artículo está organizado de la siguiente manera: La sección 2 presenta la definición de antropometría facial. La sección 3 presenta el procesamiento digital de la imagen facial, a través de la adquisición, detección y extracción de características. La sección 4 presenta los resultados del trabajo y finalmente la sección 5 presenta las conclusiones.

2. Antropometría facial

La antropometría facial es la medida de la superficie de la cabeza y de la cara. La evaluación antropométrica facial está basada en la determinación de zonas particulares del sujeto, para el caso más concreto, los puntos característicos del rostro, definidos en términos de las características visibles o palpables del complejo facial. Un conjunto de medidas entre dichos puntos es obtenido empleando procedimientos e instrumentos de medida exactos [13] [14].

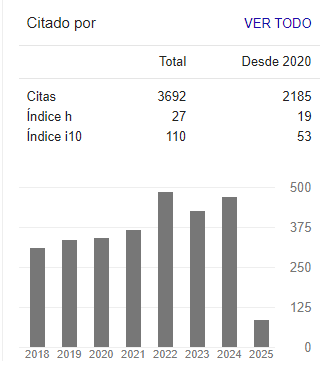

En las seis regiones del complejo facial (cabeza, cara, ojos, nariz, labios, boca y orejas), se han descrito 150 medidas lineales y angulares y 155 índices de proporción [15]. Para el establecimiento de dichas medidas se tienen las líneas de referencia vertical, horizontal, lateral y angular. Las medidas obtenidas en este trabajo se encuentran en la Figura 1. En este trabajo, a diferencia de [20], nos concentraremos no sólo en el análisis de las características de la boca, sino también de los ojos.

3. Procesamiento de la imagen facial

Dentro de las tareas más desafiantes para el análisis de formas visuales y para el reconocimiento de objetos están el entendimiento de cómo las personas procesan y reconocen el rostro de los demás, y el desarrollo de los correspondientes modelos computacionales para su reconocimiento automático. Un sistema automático de reconocimiento facial envuelve tareas básicas de procesamiento de la imagen, como lo son, detección de un patrón como un rostro, extracción de características, y reconocimiento y verificación facial [8].

3.1. Adquisición de la imagen facial

Aunque en el modelado de la formación de la imagen de color (fotografía), los principales factores involucrados son la distribución espectral de potencia (SPD), las sensibilidades espectrales de la cámara y las reflectancias de las superficies, existen otros factores que pueden tener un efecto esencial: escena y geometría de adquisición, alrededores, iluminación (intensidad, calidad y dirección de la luz), ajustes de la cámara, tipo de cámara y otros factores no ideales de esta como la exposición (enfoque, abertura) [19].

El procedimiento implementado para la adquisición de las imágenes faciales de este trabajo se realizó bajo condiciones controladas empleando una cámara digital Cybershot Sony DSC-F717, un conjunto de luces artificiales con sus respectivos reflectores y difusores ubicados en un espacio completamente oscuro, con el objetivo de tener total control sobre la iluminación del sujeto y así resaltar las características de interés.

Dentro de la configuración de la geometría de la escena, el sujeto a fotografiar está sentado en una silla fija, en posición frontal a la cámara fotográfica con una separación de 2 m aproximadamente.

Junto a él se encuentra el patrón de medida. La distancia que lo separa del fondo negro es de aproximadamente 1 m, con el fin de evitar sombras indeseadas, las cuales pueden ser generadas por las luces artificiales. Está rodeado de tres focos de luces artificiales dispuestas de tal manera que la iluminación sea simétrica y completamente distribuida. En la Figura 2 se puede observar una fotografía de la escena de adquisición.

3.2. Detección facial

La detección del rostro es una de las tareas fundamentales en el procesamiento digital de imágenes faciales, puesto que permite aislarlo en una imagen compuesta disminuyendo el costo computacional. En este trabajo se emplea la técnica de compensación de iluminación y transformación no lineal del espacio de color YCbCr planteado en [6], la cual es una aproximación holística y analítica, empleada en imágenes de color que presentan variaciones en sus condiciones de iluminación.

El algoritmo primero estima y corrige el color basado en una técnica de compensación de iluminación. Las componentes corregidas de rojo, azul y verde son transformadas de manera no lineal al espacio de color YCbCr. Los píxeles de tono de piel son detectados usando un modelo de piel elíptico en el espacio transformado. Los píxeles de tono de piel detectados son segmentados a través de un análisis de conectividad de las regiones de la imagen. El módulo de detección de características localiza las regiones de los ojos y de la boca, construyendo sus mapas característicos en función de la información de luminancia y crominancia de la imagen.

3.2.1. Compensación de iluminación

Las diferencias en las condiciones de iluminación de la imagen son compensadas empleando la técnica de "blanco de referencia", para la cual se realiza una observación de los píxeles que poseen el 5% del valor máximo de luminancia. Si el número de dichos píxeles supera un umbral (>100), estos son establecidos como los píxeles de referencia. A continuación, las componentes R, G y B de la imagen son transformadas linealmente de tal forma que el valor promedio del valor en escala de grises de dichos píxeles sea escalado linealmente a 255.

3.2.2. Modelado del color de la piel

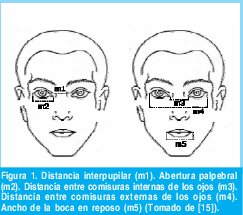

Para modelar el color de la piel se realiza una transformación no lineal al espacio de color YCbCr, el cual concentra la mayor parte de la información en la crominancia y no en la luminancia, y permite determinar un cluster compacto de la piel. Para detectar el color de la piel en la imagen se emplea el modelo elíptico establecido a partir de la observación de un conjunto de imágenes faciales de prueba, el cual se puede observar en la Figura 3.

3.2.3. Mapa de la boca

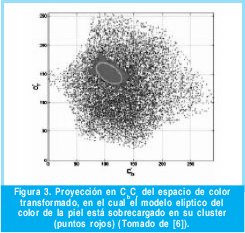

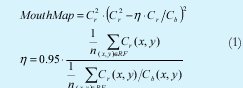

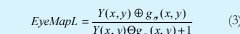

El color de la región de la boca posee mayor efecto de la componente roja, y menor influencia de la componente verde, en comparación con otras regiones faciales. Razón por la cual la componente Cr es mayor que la componente Cb. De igual manera, la boca presenta una baja respuesta en la característica Cr /Cb, y de forma contraria en Cr2 . Con base a estos criterios, el mapa de la boca es construido mediante las expresiones de la Ecuación 1, donde Cr2 y Cr /Cb están normalizados al rango [0, 255], y h es el número de píxeles dentro de la región facial (RF).

3.2.4.Mapa de los ojos

Se construyen dos mapas de los ojos separados, uno a partir de la componente de crominancia, y el otro de la componente de luminancia, los cuales son finalmente combinados en un único mapa de los ojos. El mapa basado en el croma, trabaja bajo la observación que alrededor de los ojos se encuentran valores de Cb altos y de Cr bajos y está establecido por la Ecuación 2, donde (Cr )2, Cr2 y Cr /Cb están normalizados al rango [0,255] y Cr es el negativo de Cr (Cr - 255).

Los ojos usualmente contienen, píxeles tanto oscuros, como brillantes, por lo cual, se implementan operadores morfológicos en escala de grises (dilatación y erosión) para enfatizarlos en la componente luma. Se emplea un elemento estructurante hemisférico [16] para construir el mapa de los ojos de luma, descrito en la Ecuación 3.

El mapa del croma es combinado con el mapa del luma mediante una operación de multiplicación (AND) con el fin de obtener el mapa de ojos resultante, el cual es normalizado, dilatado, y segmentado para resaltar ambos ojos y eliminar otras áreas faciales.

3.3. Extracción de características faciales

Después de detectar la presencia de un rostro en la escena observada, el siguiente paso es extraer la información de este. Tanto la representación facial, como el tipo de imágenes de entrada afectan el método de aproximación para la extracción de características faciales.

3.3.1. Extracción de características de la boca

La búsqueda de las características labiales para la determinación de las medidas de la boca se basa en la técnica de proyecciones integrales [17] [18].

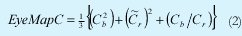

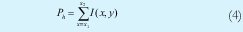

Para determinar la posición vertical de la línea entre los labios, se aplica la proyección integral horizontal (Ph) de la Ecuación 4, en la imagen en escala de grises de la región de la boca, y se realiza una búsqueda de su mínimo global. Las fronteras horizontales de los labios son establecidas con base a la proyección vertical (Pv) de la Ecuación 5, de la imagen de bordes horizontales, alrededor de la posición estimada de la línea de los labios. Las fronteras izquierda y derecha de los labios, pueden ser localizadas, donde Pv exceda un cierto umbral T o caiga debajo de este, respectivamente. El umbral es escogido como el promedio de la proyección Pv. Las posiciones verticales de las comisuras de los labios son encontradas realizando la búsqueda de los píxeles más oscuros alrededor de las columnas de las regiones de las fronteras previamente establecidas.

3.3.2. Extracción de características de los ojos

La extracción de características de los ojos se divide en dos módulos fundamentales, la localización del iris, y la localización de las comisuras de los ojos.

3.3.2.1 Localización del iris

La localización del iris del ojo se realiza a partir de un detector de círculos en la imagen. Este detector de círculos emplea la información de la imagen de bordes SUSAN Ie(x,y) [10], en la cual se obtiene como mayor área circular aquella comprendida por el iris del ojo. El algoritmo de detección del iris se basa en tres principios básicos [8]:

- La localización del ojo es conocida.

- El iris es aproximadamente circular.

- El iris está descrito por las coordenadas de su centro y su radio, los cuales son determinados a partir de la expresión de la Ecuación 6, donde r [r min, r max], y [x 0,y 0 ] Ie(x,y).

3.3.2.2 Localización de las comisuras

Inicialmente se debe estimar una región de búsqueda de los extremos interiores y exteriores del ojo, para lo cual se emplea el detector de esquinas SUSAN [10]. Alrededor de los párpados del ojo, se encuentran las pestañas, las cuales pueden agregar información espuria, contribuyendo a una mala detección de una esquina o borde en la imagen del ojo, por lo cual, se le debe aplicar un suavizado. La localización de las comisuras de los ojos es establecida a partir de la búsqueda de los mínimos alrededor de cada una las regiones estimadas [9]

3.4. Determinación de las medidas faciales

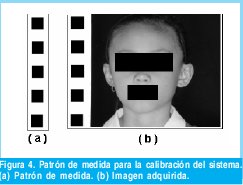

Las medidas faciales son determinadas a partir de la distancia euclidea tomada entre dos puntos característicos de la región del complejo facial a analizar. Se tiene como característica principal, el hecho que las imágenes adquiridas en la base de datos, no están en tamaño real, por lo cual se debe realizar una calibración del sistema partiendo del patrón de medida, el cual se muestra en la Figura 4. Dicha calibración se realiza estableciendo la cantidad de píxeles abarcados por la distancia entre los centros de masa de dos cuadrados del patrón (medida previamente conocida y correspondiente a un valor de 40 mm.). A partir de este valor estándar se puede establecer la relación lineal entre píxeles y milímetros, para así obtener la medida en tamaño real de cada una de las regiones del complejo facial.

4. Resultados

Los diferentes algoritmos de detección y extracción de características fueron probados empleando 1320 imágenes de 660 sujetos clasificados de acuerdo a la edad y el género, los cuales poseen características físicas diferentes, tales como el color de la piel, el color de los ojos, bocas y ojos grandes, entre otras.

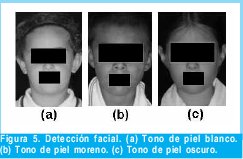

Para la detección facial, la segmentación del color de la piel se obtiene de manera eficiente gracias a la robustez del modelo elíptico establecido en [6], el cual es aplicable a cualquier tono de piel. Sin embargo, la detección de la región de la boca y los ojos, depende ampliamente de los brillos y sobre-iluminaciones del rostro, conllevando a una detección de falsos negativos en la escena. En la Figura 5, se pueden observar algunos rostros detectados de acuerdo al tono del color de la piel.

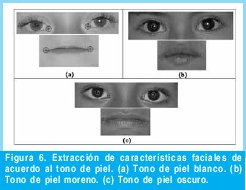

Algunos resultados para la localización de los puntos característicos se pueden observar en las Figura 6.

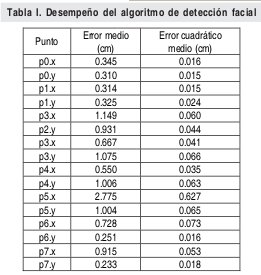

El error para la localización de puntos es establecido como la distancia euclidea existente entre el punto manual y el punto automático en las coordenadas x e y. Se obtiene el error promedio en píxeles, para lo cual se tiene en cuenta que, con base al patrón de calibración de medidas, 1 píxel corresponde a 0.128 mm. La técnica de proyecciones integrales es bastante eficiente para la localización de las comisuras de la boca, presentando un bajo error como se puede observar en la Tabla I. La localización de las comisuras de los ojos depende directamente de la presencia de las pestañas alrededor de los ojos, presentando un alto error, principalmente en el caso de las comisuras externas.

La notación en la columna punto de la Tabla I, corresponde a: p0 y p1: Centros pupila de los ojos izquierdo y derecho. p2 y p3: Comisuras externa e interna del ojo izquierdo. p4 y p5: Comisuras interna y externa del ojo derecho. p6 y p7: Comisuras de la boca.

En las imágenes faciales adquiridas el sujeto puede poseer algún tipo de rotación, lo que ocasiona que la ubicación exacta de la línea de los labios no sea encontrada, sin embargo, se determina una región de búsqueda alrededor de su posición vertical, para ubicar las esquinas de la boca. Para localizar de manera más exacta cada uno de los queilión, se realiza una búsqueda de mínimos en la imagen, sin embargo este procedimiento depende directamente de la condición de la boca en la escena y del color de la piel. Es posible que el algoritmo caiga en un mínimo local, cuando la boca está abierta, lo cual se compensa realizando una búsqueda adicional del interior de esta hacia afuera. En el caso de sujetos con color de piel oscura o con lunares o sombras marcadas alrededor de la boca, el algoritmo establece un mínimo global en dichos puntos produciendo un error en la localización como se muestra en la Tabla I, para los puntos p6 y p7.

La localización de los diferentes puntos de los ojos depende directamente de la información obtenida de sus bordes y esquinas, procesadas empleando el operador SUSAN. Para la detección del iris, y subsecuentemente el centro de la pupila, se toma como región inicial de búsqueda, la luz reflejada por el flash empleado durante la adquisición, ya que esto asegura que es la región con valor de intensidad de 255 en la imagen en escala de grises y coincide de manera aproximada con la pupila. Cada píxel blanco encontrado es asumido como centro para la búsqueda del círculo, lo cual prácticamente asegura la detección satisfactoria del iris, obteniendo niveles de error bajos en comparación con el etiquetado manual de las imágenes como se muestra en la Tabla I, para los puntos p0 y p1.

Después de encontrar el iris, y con base a la información de esquinas se realiza la búsqueda de las comisuras de cada ojo, sin embargo este proceso es altamente dependiente de las pestañas que lo rodean y el color de la piel del sujeto de análisis. Para disminuir el efecto de las pestañas, se realiza un suavizado de la imagen, el cual es un procedimiento que está establecido a través de la manipulación de umbra- les que pueden tener efectos que beneficien o perjudiquen la localización de las esquinas de los ojos. Se presenta un error menor en la localización de las comisuras internas (p3 y p4), dado que es de manera general una zona que no posee pestañas. Caso contrario al de las comisuras externas (p2 y p5), lugar en el que se encuentra la mayor cantidad de pestañas y es difícil establecer las verdaderas esquinas a través del detector, obteniendo un error bastante considerable (Tabla I).

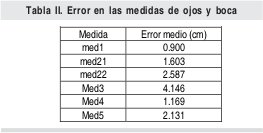

Los errores en centímetros de las medidas, obtenidas a partir de los puntos característicos localizados de manera automática, se pueden observar en la Tabla II. La notación en la columna medida corresponde a: Med1: distancia interpupilar. Med21 y Med22: ancho de la abertura palpebral izquierda y derecha. Med3: distancia entre comisuras externas de los ojos. Med4: distancia entre comisuras internas de los ojos. Med5: ancho de la boca.

El mayor error se presenta en la medida correspondiente a la distancia entre las comisuras externas y la anchura palpebral derecha, las cuales se justifican de acuerdo a los errores en milímetros mencionados en la Tabla II.

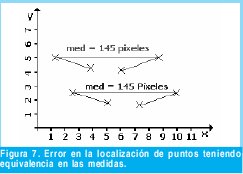

La evaluación de la extracción de características faciales se realiza comparando la localización de puntos y las medidas obtenidas de manera automática con aquellas obtenidas a través del etiquetado manual de 250 imágenes. Sin embargo, el error obtenido para las medidas del rostro no da una clara información de la eficiencia de los algoritmos de localización de puntos, ya que puede existir un desplazamiento en los puntos cuya distancia euclidea coincida con la medida real como se muestra en la Figura 7.

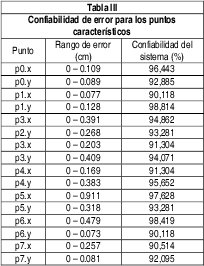

Dadas las condiciones de trabajo del sistema y los errores promedio obtenidos, tanto en las medidas como en la localización de puntos, se halló la confiabilidad (en porcentaje), de que el resultado tenga un rango de error determina- do, la cual puede observarse en la Tabla III. Para el Punto en el eje de las abscisas correspondiente al centro de la pupila del ojo izquierdo (P0.x), hay una confiabilidad del sistema del 96.44% para equivocarse entre 0 y 0.109 cm.

5. Conclusiones

En el procesamiento digital de las imágenes adquiridas, las condiciones de iluminación de la escena y el tono de la piel son los factores más importantes que determinan el desempeño de los algoritmos de detección y extracción de características faciales. Las técnicas empleadas, basadas en la información de color, las proyecciones integrales, los detectores de bordes y esquinas y la búsqueda de mínimos, son invariantes a la rotación y traslación del rostro en la escena. Sin embargo, dependen directamente de si los ojos o la boca se encuentran abiertos o cerrados. Desde el punto de vista algorítmico la presencia de las pestañas en los ojos afecta la detección de bordes y esquinas de la región de los ojos, ya que, adhieren información espuria que introduce un error en la determinación de la región de búsqueda de mínimos, la cual a su vez depende altamente de la presencia de sombras, manchas y lunares, los cuales se pueden convertir en mínimos globales que generan una localización incorrecta de los puntos característicos.

El planteamiento de la confiabilidad de caer en un rango de error permite establecer si el desempeño del sistema se acopla a determinada aplicación, por ejemplo, si se requiere un sistema que permita una variación en la localización entre 0 y 10mm, los resultados presentados muestran que este trabajo está a punto y tendría un alto desempeño. Sin embargo, para aplicaciones de alta precisión, específicamente para trabajos en cirugía plástica, se deben realizar ciertos ajustes y mejoras a los diferentes algoritmos.

Referencias bibliográficas

[1] M. Pantic y J.M. Rothkrantz, "Automatic Analysis of Facial Expressions: The state of the Art", IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 22, No. 12, Pág. 1424 - 1445, 2000.

[2] Y.M. Huang y C.L. Huang, "Facial Expression Recognition Using Model-Based Feature Extraction and Action Parameters Classification", J. Visual Comm. And Image Representation, Vol. 8, No. 3, Pág. 278-290, 1997.

[3] M. Pantic y J.M. Rothkrantz, "Expert System for Automatic Analysis of Facial Expression", Image and Vision Computing J., Vol. 18, No. 11, Pág. 881-905, 2000.

[4] H. Kobayashi y F. Hara, "Facial Interaction between Animated 3D Face Robot and Human Beings", Proc. Int'l Conf. Systems, Man, Cybernetics, Pág. 3732-3737, 1997.

[5] Q. Chen, M. Yachida y H. Wu, "Face Detection from Color Images Using a Fuzzy Pattern Matching Method". IEEE Transactions on Pattern Analysis and Machine Intelligence. Vol. 24. 2002.

[6] M. Abdel-Mottaleb, A. Jain y R. Hsu, "Face Detection in color Images", IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 24, No. 5, Pág. 696 706, 2002.

[7] T.F. Cootes, C.J. Taylor y G.J. Edwards, "Face Recognition Using Active Appeareance Models". Proc. Eurepean Conf. Computer Vision. Vol. 2. 1998.

[8] J. Albergh, "Model-Based Coding. Extraction, Coding and Evaluation of Facial Model Parameters". Ph.D. Thesis. Linköping University. 2002.

[9] S. Guangda, D. Cheng y g. Hua, "Feature Points Extraction from Faces", Research Institute of Image and graphics, Department of Electronic Engineering, Tsinghua University.

[10] S.M. Smith y J.M. Brady, "SUSAN A new approach to Low Level Image Processing", Int. Journal of Computer Vision, Vol. 23, No. 1, Pág. 45-78, 1997.

[11] J. Yang, A. Waibel y R. Stiefelhagen, "A Model-Based Gaze Tracking System", Interactive System Laboratories, Carnegie Mellon University, University of karlsruhe.

[12] J.A. Chacón, J.F. López y C. Quintero, "Antropometría Facial en Niños entre 5 y 10 Años de la Ciudad de Manizales", 1999.

[13] D. Metaxas, M. Stone y D. Decarlo, "An Anthropometric Face Model Using Variational Techniques", Proc. SIGGraph. 1998.

[14] "Antropometry" [en línea], En línea <http://www.skepdic.com/ anthropo.html> (Consulta: 28 de Febrero de 2004).

[15] L.G. Farkas,, "Anthropometry of the head and Face in Medicine", Elsevier. 1984.

[16] M. Deriche, y P.T. Jackway, "Scale-space properties of the multiscale morphological dilation-erosion", IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 18, No. 1, Pág. 36 51, 1996.

[17] J. Yang, A. Waibel y R. Stiefelhagen, "A model-based gaze tracking system, Iteractive system Laboratories", Carnegie Mellon University, University of Karlsruhe.

[18] T. Poggio y R. Brunelli, "Face recognition: Features versus templates", IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 15, No. 10, Pág. 1042 1052, 1993.

[19] B. Martinkauppi, "Face Colour Under Varying Illumination - Analyisis and Applications", Ph.D. Thesis, University of Oulu, 2002.

[20] A. Salazar y F. Prieto, "Extracción y Clasificación de Posturas Labiales en Niños entre 5 y 10 Años de la Ciudad de Manizales". En DYNA, Revista de la Facultad de Minas, Medellín, Colombia. Vol. 73, No. 150, Páginas 175-188. 2006.

Ivonne Mejía

Ingeniera Electrónica, Universidad Nacional de Colombia Sede Manizales, Colombia. Durante el desarrollo de este trabajo estuvo vinculada al grupo de investigación en Percepción y Control Inteligente de la Universidad Nacional de Colombia Sede Manizales. Actualmente se encuentra laborando en una entidad privada. ivonita90@hotmail.com

Flavio Prieto

Ingeniero Electrónico, Universidad Distrital Francisco José de Caldas. Magíster en Ingeniería Eléctrica, Universidad de los Andes. PhD. del Instituto Nacional de Ciencias Aplicadas de Lyon, Francia. Desde febrero de 2000 se vinculó al Departamento de Ingeniería Eléctrica, Electrónica y de Computación de la Universidad Nacional de Colombia, Sede Manizales. Coordinó la Maestría en Ingeniería Automatización Industrial y el Doctorado en Ingeniería Automática, que se ofrecen en dicho departamento. Actualmente se desempeña como profesor en el área de Visión Artificial en la Universidad Nacional de Colombia Sede Manizales, y hace parte del grupo de investigación de Automática de la Universidad Nacional de Colombia. faprietoo@unal.edu.co

Colombia Quintero

Médica Cirujana, Universidad de Caldas. Obtuvo su Especialización en Cirugía Plástica, Estética, Maxilo Facial y de la Mano, en la Universidad de Caldas. Se vinculó como docente en la Universidad de Caldas donde laboró hasta el año 2006. Se ha destacado por el trabajo en pro de los niños con Labio y/ o Paladar Hendido. Ha participado como voluntaria en innumerables misiones médicas en distintos países del Mundo. Recibió el premio Mujer Cafam. Se ha caracterizado por su gran espíritu investigativo, con el cual ha desarrollado varios estudios en el área de la antropometría facial. Actualmente se desempeña como profesora en la facultad de Medicina de la Universidad de Manizales. coloquin@hotmail.com

Creation date:

License

From the edition of the V23N3 of year 2018 forward, the Creative Commons License "Attribution-Non-Commercial - No Derivative Works " is changed to the following:

Attribution - Non-Commercial - Share the same: this license allows others to distribute, remix, retouch, and create from your work in a non-commercial way, as long as they give you credit and license their new creations under the same conditions.

2.jpg)