DOI:

https://doi.org/10.14483/23448350.20866Published:

09/01/2023Issue:

Vol. 48 No. 3 (2023): September-December 2023Section:

Research ArticlesIntegración de herramientas para la evaluación de indicadores de publicaciones científicas

Integration of Tools for the Evaluation of Indicators of Scientific Publications

Keywords:

editorial management, interoperability, open science, science indicators, scientific journals (en).Keywords:

ciencia abierta, indicadores de ciencia, interoperabilidad, gestión editorial, revistas científicas (es).Downloads

References

Allison, D. A. (2016). OAI-PMH Harvested Collections and User Engagement,” Journal of Web Librarianship, 10 (1), 14-27, 2016. https://doi.org/10.1080/19322909.2015.1128867

Banzato, G., Rozemblum, C. (2019). Modelo sustentable de gestión editorial en Acceso Abierto en instituciones académicas. Principios y procedimientos. Palabra Clave (La Plata), 8 (2), e069. https://doi.org/10.24215/18539912e069

Barros, M. (2015). Altmetrics: Métricas alternativas de impacto científico com base em redes sociais. Perspectivas em Ciência da Informação, 20 (2), 19-37. https://doi.org/10.1590/1981-5344/1782

Cho, H., Yu, Y. (2018). Link prediction for interdisciplinary collaboration via co-authorship network. Social Network Analysis and Mining, 8 (1), 1-12. https://doi.org/10.1007/s13278-018-0501-6

Crossref. (2020). About us - Our mission. https://www.crossref.org/about/

De Volder, C. (2016). Métricas alternativas: ¿una nueva forma de medir el impacto científico?. Épocas. Revista de ciencias sociales y crítica cultural, 3, 1-12

Fairhurst, V. (2018). The international reach of Crossref, Science Editing, 5 (1), 62-65. https://doi.org/10.6087/kcse.121

García, A. B., Espinosa, R. L., Matín, J., Espinosa, J. M. (2016). Enfoque semántico para el descubrimiento de recursos sensible al contexto sobre contenidos académicos estructurados con OAI-PMH. Computación y Sistemas, 20 (1), 127-142. https://doi.org/10.13053/CyS-20-1-2189

Haak, L. L., Meadows, A., Brown, J. (2018). Using ORCID, DOI, and Other Open Identifiers in Research Evaluation. Frontiers in Research Metrics and Analytics, 3, 1-7. https://doi.org/10.3389/frma.2018.00028

Habermann, T. (2020). Metadata and Reuse: Antidotes to Information Entropy. Patterns, 1 (1), e100004. https://doi.org/10.1016/j.patter.2020.100004

Hendricks, G., Tkaczyk, D., Lin, J., Feeney, P. (2020). Crossref: The sustainable source of community-owned scholarly metadata. Quantitative Science Studies, 1 (1), 414-427. https://doi.org/10.1162/qss_a_00022

Ice, M. (2016). Applications of BePress Digital Commons in special collections: Initial experiences at Abilene Christian University. Journal of Electronic Resources Librarianship, 28 (2), 118-120. https://doi.org/10.1080/1941126X.2016.1167536

Keßler, C., D’aquin, M., Dietze, S. (2013). Linked data for science and education. Semantic Web, 4 (1), 1-2, 2013. https://doi.org/10.3233/SW-120091

López, Y., Torréns, R., Viloria, A., Ramírez, M. (2012). OJS: Una herramienta de gestión editorial en línea. Estrategias para su adopción en la universidad de Los Andes. Disertaciones, 5 (1), 217-228

López-Pellicer, F. J., et al. (2016). El desafío de los identificadores persistentes y accionables,” Mapping, (180), 32-41

McNutt, M. K., et al. (2018). Transparency in authors’ contributions and responsibilities to promote integrity in scientific publication. Proceedings of the National Academy of Sciences, 115 (11), 2557-2560. https://doi.org/10.1073/pnas.1715374115

Paskin, N. (2015). Digital Object Identifier (DOI) System. Encyclopedia of Library and Information Sciences, 1-7. https://doi.org/10.1081/E-ELIS3-120044418

Prerna, S. (2018). Scholarly open access publishing: Growth of LIS open access journals visible through directory of open access journals. Library Philosophy and Practice, 1749, 1-15

Subbiah, A., Muthu, M. (2016). Adopting ORCID as a unique identifier will benefit all involved in scholarly communication. The National Medical Journal of India, 29 (4), 1-8

Raoof, A., Ehab, M. (2019). Open Researcher and Contributor Identifier and other author identifiers: Perspective from Pakistan. Journal Of Pakistan Medical Association, 69 (6), 888-891

Razzaq, S., Malik, A.K., Raza, B., Khattak, H.A., Moscoso Zegarra, G.W., Zelada, Y.D. (2022). Research Collaboration Influence Analysis Using Dynamic Co-authorship and Citation Networks. International Journal of Interactive Multimedia and Artificial Intelligence, 7(3), 103-116. https://doi.org/10.9781/ijimai.2022.03.001

Reller, T. (2017). Elsevier acquires BePress, a leading service provider used by academic institutions to showcase their research. https://www.elsevier.com/about/press-releases/corporate/elsevier-acquires-bepress,-a-leading-service-provider-used-by-academic-institutions-to-showcase-their-research

Sancho, R. (1990). Indicadores bibliométricos utilizados en la evaluación de la ciencia y la tecnología, Revisión bibliográfica. Revista española de documentación científica, 13, 3-4, 1990

Thelwall, M. (2020). The Pros and Cons of the Use of Altmetrics in Research Assessment,” Schoolar Assessments Reports, 2 (1), 2

Torres-Salinas, D., Ruíz-Pérez, R. (2015). Las diez claves sobre métricas alternativas. https://digibug.ugr.es/handle/10481/34922

Vásquez, C. L., Luna-Cardozo, M., Torres-Samuel, M. (2019). Arquitectura informacional de portales web de las universidades latinoamericanas en los rankings. Lousada, 24, 250-259

Wilkinson, M. D., et al. (2016). The FAIR Guiding Principles for scientific data management and stewardship. Science Data, 3 (1), 1-9. https://doi.org/10.1038/sdata.2016.18

Zhao, R., Wang, X., Liu, Z., Qi, Y., Zhang, Z., Chang, R. (2019). Research on the impact evaluation of academic journals based on altmetrics and citation indicators. Proceedings of the Association for Information Science and Technology, 56 (1), pp. 336-345. https://doi.org/10.1002/pra2.27

How to Cite

APA

ACM

ACS

ABNT

Chicago

Harvard

IEEE

MLA

Turabian

Vancouver

Download Citation

Recibido: de noviembre de 2022; Aceptado: de marzo de 2023

Resumen

Cada día surgen más herramientas tecnológicas para ayudar en la gestión de los procesos editoriales que lleva una revista científica, desde el envío de un trabajo hasta su publicación y seguimiento de citas. Sin embargo, dado este incremento de opciones, se ha vuelto más complejo para los responsables hacer un adecuado seguimiento y validación de los procesos, pues la información se encuentra más dispersa y a veces carece de interoperabilidad. Este trabajo propone una arquitectura de integración para las herramientas esenciales del flujo editorial, haciendo una comparación analítica y técnica que permita obtener la mejor integración, en aras de simplificar toda la información requerida en una única plataforma. Como resultado se presenta un primer prototipo de plataforma que aplica la arquitectura definida, obteniendo resultados favorables para el seguimiento y validación de los trabajos e indicadores de las revistas.

Palabras clave:

ciencia abierta, gestión editorial, indicadores científicos, interoperabilidad, revistas científicas.Abstract

Every day, more technological tools emerge to aid in the management of the editorial processes carried out by a scientific journal, from the submission of a paper to its publication and follow-up of citations. However, given this increase in options, it has become more complex for those responsible to properly monitor and validate processes, as the information is more dispersed and sometimes lacks interoperability. This work proposes an architecture for integrating the essential tools of editorial flow, making an analytical and technical comparison allowing to obtain the best integration, in order to simplify the entirety of the required information in a single platform. As a result, a first prototype of the platform is presented which applies the defined architecture, obtaining favorable results for the monitoring and validation of journal works and indicators.

Keywords:

editorial management, interoperability, open science, science indicators, scientific journals.Resumo

A cada dia surgem mais ferramentas tecnológicas para auxiliar na gestão dos processos editoriais de uma revista científica, desde a submissão de um artigo até sua publicação e acompanhamento das citações. No entanto, face a este aumento de opções, tornou-se mais complexo para os responsáveis acompanhar e validar adequadamente os processos, uma vez que a informação está mais dispersa e por vezes carece de interoperabilidade. Este trabalho propõe uma arquitetura de integração para as ferramentas essenciais do fluxo editorial, fazendo um comparativo analítico e técnico que permite obter a melhor integração, de forma a simplificar todas as informações necessárias em uma única plataforma. Como resultado, é apresentado um primeiro protótipo de plataforma que aplica a arquitetura definida, obtendo resultados favoráveis para o acompanhamento e validação dos trabalhos e indicadores das revistas.

Palavras-chaves:

ciência aberta, gestão editorial, indicadores científicos, interoperabilidade, revistas científicas.Introducción

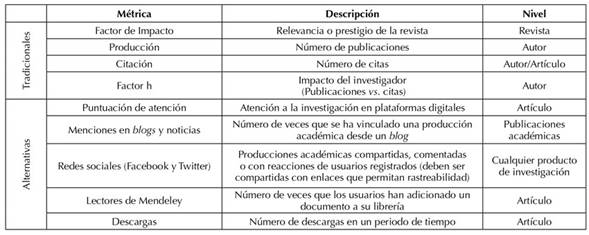

Desarrollar un trabajo de investigación implica financiación e infraestructura, por lo que medir la relevancia, el impacto, el reconocimiento y la validez de los productos resultantes afecta las decisiones que toman las instituciones y entidades en cuanto a asignación de recursos, planificación futura, reconocimiento de autores y evaluación de calidad. Para dichas mediciones, se hace uso de las métricas, las cuales permiten establecer el impacto por medio de la estimación del comportamiento, las tendencias y el análisis de la actividad científica (Sancho, 2009). En primera instancia, existen las métricas tradicionales, dentro de las cuales se encuentran los indicadores bibliométricos que analizan la investigación y la ciencia usando principalmente las citas recibidas, el número de documentos publicados y el factor de impacto (Torres-Salinas & Ruíz-Pérez, 2015; de Volder, 2016).

Adicionalmente, existen las métricas alternativas (Altmetría), que pretenden medir el impacto de los productos de investigación en un público no necesariamente científico o especializado, a través de herramientas, servicios y plataformas web (Torres-Salinas & Ruíz-Pérez, 2015; de Volder, 2016). Dentro de las métricas alternativas, se tienen, entre otros, la vinculación a un sistema gestor de referencias y las reacciones y menciones o citas en blogs y redes sociales. Esto permiten conocer en tiempo real los comentarios, descargas y citas de plataformas que pertenecen a ecosistemas emergentes, brindando una posibilidad mayor de impacto, saliendo del concepto tradicional de influencia científica (Barros, 2015; Thelwall, 2020).

Las métricas tradicionales y alternativas no son excluyentes entre sí, y, si bien aún hay diversos aspectos por mejorar, pueden brindar información de interés para determinar el impacto que tienen los trabajos más allá de las instituciones, haciendo uso de diversos componentes. En la Tabla 1 se presentan las métricas más conocidas para la evaluación del impacto de revistas y artículos científicos.

Tabla 1: Métricas para evaluación del impacto de revistas y artículos científicos

Para poder determinar las métricas presentadas en la Tabla 1 para un objetivo en particular, ya sea un artículo o una revista, es necesario hacer uso de diversos sistemas, herramientas y tecnologías que permitan vincular sistemas de información con datos de producción científica. Sin embargo, dada la aparición de nuevas tecnologías y del volumen de artículos que se publican a nivel mundial, es necesario buscar estrategias que permitan su identificación de forma única y correcta.

A partir de esto, es necesario contar con una solución que vincule los datos de diferentes herramientas en una plataforma que permita intercambiar información, estableciendo unas reglas de comunicación y una estructura para su intercambio. Así, haciendo uso de algoritmos que reciben toda la información de los artículos publicados en una revista, se puede clasificar la información recolectada, evaluándola por medio de expresiones regulares y validando así las características de cada documento, en aras de contar con información fiable.

Dicha disponibilidad de datos tiene como objetivo que todos los resultados de la investigación sean fáciles de encontrar, citar, vincular, evaluar y reutilizar (Fairhurst, 2018; Crossref, 2020). Así, este trabajo tiene por objetivo proponer una arquitectura para integrar los servicios encargados de la difusión de metadatos de investigación para su vinculación y reutilización, generando así indicadores bibliométricos sobre revistas.

Metodología

Para el desarrollo de la arquitectura, se utilizó una metodología analítica y experimental, en el marco de la cual se revisaron y compararon los datos que cada herramienta es capaz de proveer, con el fin de proponer aquellos que tuvieran mayor calidad de información y fueran interoperables.

A continuación, se presenta la definición y comparación de los actores a incluir en la arquitectura. El primer apartado describe los identificadores persistentes y su participación en las publicaciones científicas, comparando sus características generales. Posteriormente, se comparan las herramientas de gestión editorial y sus características principales. Igualmente, se describen los cosechadores de metadatos, los servicios que proveen y un análisis comparativo entre las agencias que ofrecen este servicio.

Identificadores Persistentes Digitales (PID)

Un PID es una referencia estandarizada de un recurso digital cuyo fin es identificarlo de manera única en la red. Puede ser usado entre personas, organizaciones, documentos, conjuntos de datos y objetos de investigación, y debe ser persistente, abierto e interoperable, permitiendo establecer conexiones entre recursos (Haak, et al., 2018; López-Pellicer, et al., 2016; Habermann, 2020). Estas características están diseñadas para mejorar la reutilización de los datos científicos, proyectando su uso a largo plazo. Para esto, se han adoptado protocolos que aseguren su interoperabilidad y recuperación, siguiendo los principios FAIR (siglas que corresponden a los términos en inglés findable, accessible, interoperable y reusable), un conjunto de principios para hacer que los datos de investigación sean fáciles de encontrar, accesibles, interoperables y reutilizables, proporcionando una guía para la gestión de los datos científicos, en aras de sacar el máximo provecho de los datos de investigación (García, et al., 2016; Wilkinson, et al., 2016; Cho & Yu, 2018).

Dando cumplimiento a los principios propuestos, las organizaciones han diseñado estándares de identificación única, abarcando diferentes características. Los identificadores persistentes se dividen en identificadores de autores o colaboradores, identificadores de objetos e identificadores de organizaciones. Para el alcance de este trabajo, se hablará principalmente de los dos primeros.

1) Identificador de autores. La variación del nombre de un mismo autor en trabajos o citaciones debido a factores como el contexto cultural, errores de escritura, omisión de partes o reglas de publicación puede causar problemas de ambigüedad, donde se puede adjudicar la autoría de un trabajo a la persona incorrecta. Esto lleva a disminuir la visibilidad de los trabajos de autores que tengan un nombre similar, afectando los resultados de indicadores a nivel de autor y revista, así como otros aspectos de las redes de conocimiento (Razzaq et al., 2022), junto con la pérdida de transparencia (McNutt et al., 2018).

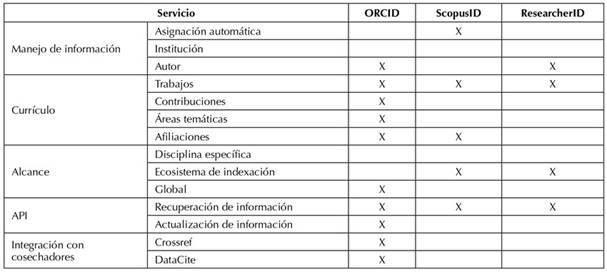

La identificación apropiada de autores y de sus trabajos es crucial para todos los involucrados en el entorno de la comunicación científica. Es por esto que se busca identificar a investigadores, autores y científicos, evitando la ambigüedad entre colaboradores y la producción asociada a estos (Raoof & Ehab, 2019). Existen identificadores con alcances locales que se centran en campos específicos a nivel de país, institución o área de estudio. Sin embargo, se vuelve más necesaria una solución con un enfoque global que permita establecer una relación autor-producto-institución. En la Tabla 2 se exponen tres de los principales identificadores de autor, resaltando las características de cada uno.

Tabla 2: Identificadores de autor

De acuerdo con lo definido en la Tabla 2, el Open Research and Contributor Identifier (ORCID) resuelve el problema de ambigüedad de nombres de la manera más precisa. Así mismo, permite acceder a la hoja de vida del autor, reuniendo todos los trabajos, resultados de investigación e instituciones a las que ha estado vinculado (Raoof & Ehab, 2019). Por lo anterior, se usará ORCID en la arquitectura, dada su facilidad de integración con otros sistemas como cosechadores de datos y gestores de referencias. Así mismo, el ORCID brinda garantías de atribución correcta de trabajos, interoperabilidad y enlace con identificadores externos, simplificación de las búsquedas y globalidad (Subbiah & Muthu, 2016).

2) Identificador de objetos. Los objetos pueden corresponder a libros, artículos, borradores, capítulos, conjuntos de datos, figuras, videos o cualquier dato significativo. Los identificadores de objetos son URL persistentes en el tiempo que direccionan a servicios de resolución, los cuales mantienen información sobre la ubicación actual del recurso, permitiendo así mantener el acceso y la trazabilidad de los objetos, independientemente de su ubicación.

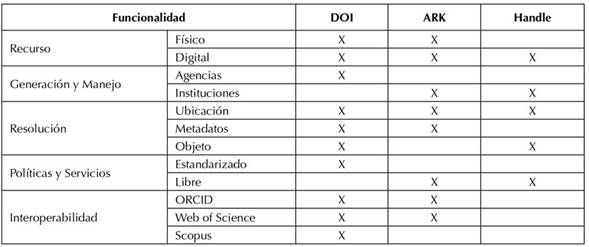

Respecto a los identificadores de objetos (Tabla 3), se encontró que el Digital Object Identifier (DOI) es mayoritariamente usado para identificar artículos científicos, revistas o cualquier tipo de objeto físico o digital. Este consiste en una URL que indica el servicio que resolverá el DOI, un prefijo que identifica a una institución y un sufijo que identifica el objeto digital, cuya estructura es definida libremente por los editores. El uso del DOI garantiza el acceso a los recursos y conlleva a un aumento en la visibilidad y el impacto de una publicación científica. Además, es interoperable con otras plataformas o repositorios de contenido (Carpenter, 2012).

Tabla 3: Identificadores de objeto.

Herramientas de gestión editorial

La gestión editorial no es solo el uso de software para el proceso de publicación, lo cual implicaría solo una aplicación robusta donde se alojen los trabajos, sino debe ser el puente para el intercambio de información (Vásquez et al., 2019). A partir de esto, se requiere de plataformas que tengan la posibilidad de intercambiar información, para que cualquier usuario pueda leer descargar, copiar, distribuir, imprimir y rastrear material para su indexación, estableciendo unas reglas de comunicación y una estructura para su intercambio (García et al., 2016).

Las herramientas de gestión editorial son soluciones tecnológicas para sistematizar los procesos de publicación de contenidos científicos difundidos en la web, los cuales van desde la recepción hasta la publicación de un documento, simplificando costos tanto en tiempo como en dinero. Diversas organizaciones han desarrollado software de gestión editorial (Elsevier, Public Knowledge Project), algunos como iniciativas open-access (OA) que pueden ser configuradas directamente por la revista. También hay organizaciones que proveen el servicio en la nube para el gestor de una revista, con una suscripción por revista almacenada.

Adicionalmente, con el fin de garantizar la recuperación de la información desde las herramientas de gestión, estas herramientas adoptan protocolos y formatos estandarizados para el intercambio de metadatos que las hagan interoperables e integrables, permitiendo un marco de trabajo para la recuperación de la información de un documento (Keßler et al., 2013). Lo anterior genera un canal de comunicación entre la revista y el usuario por medio de gestores de búsqueda, indexando identificadores e información clave de los recursos para que puedan ser encontrados, asegurando el control de la integridad de los trabajos y su debido reconocimiento y citación.

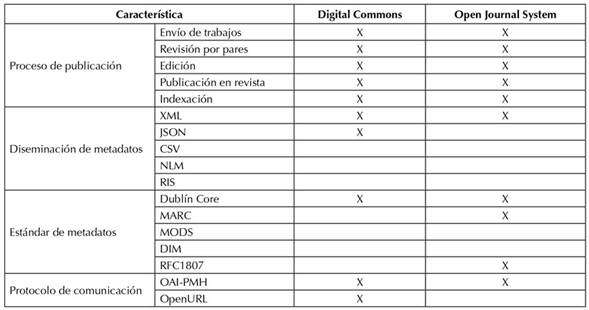

En la Tabla 4 se muestra una matriz de comparación entre las herramientas de gestión editorial más utilizadas (Prerna, 2018), con las características que pueden suministrar a las instituciones en cuatro componentes: i) el proceso de publicación, que comprende la comunicación con el autor, la carga de trabajos, la asignación de pares para su revisión y su serialización para indexación; ii) el formato de los datos que definen el contenido informativo del objeto, iii) el formato estandarizado para su intercambio máquina a máquina, habilitando la disponibilidad de los metadatos en la web y aumentando la visibilidad de los contenidos, de los autores, revista y de la misma institución; y, iv) el protocolo de comunicación en la red para su recuperación en el marco de la integración con otros gestores (Allison, 2016).

Tabla 4: Comparación de herramientas de gestión editorial.

Digital Commons ofrece un servicio de suscripción por revista para alojar cualquier activo digital en la nube. Este permite organizar, recopilar, preservar y difundir la producción intelectual, fomentando la participación en la web (Ice, 2016). Aunque su uso es pago, la revista tiene la libertad de realizar las configuraciones que requiera para su uso, brindando una página web a la revista, manejo de agenda y recordatorios para usuarios, y estadísticas sobre los recursos de los trabajos, e.g., promedio de descarga y visualización. Debido a la presión por parte de las instituciones, Digital Commons actualmente permite la integración con servicios de ORCID y DOI en sus recursos, proporcionando así un grado de OA (Reller, 2017).

Por otra parte, el Open Journal System (OJS) es una iniciativa de varias universidades que desarrollan software de código abierto (Banzato & Rozemblum, 2019). La herramienta unifica el proceso editorial que tienen las publicaciones seriadas, integrando funciones de evaluación, edición y publicación. La revista debe proveer la solución tecnológica para su configuración y uso, dando control directamente al editor de la revista de su funcionamiento. Debido a esto, OJS es uno de los gestores más utilizados, así como por el crecimiento que ha tenido en la comunidad, permitiendo la interoperabilidad con otros sistemas y la indexación de sus publicaciones en diferentes portales de búsqueda (López et al., 2012; Hendricks et al., 2020).

Cosechadores de metadatos

El ecosistema de investigación académica tiene, principalmente, dos tipos de participantes (Habermann, 2020; Allison, 2016): i) los proveedores de datos, lo cual incluye los trabajos realizados, que pueden ser visualizados y descargados por el lector, y sus metadatos, que se distribuyen a través de los canales de comunicación entre sistemas; y ii) los proveedores de servicio, encargados de cosechar los metadatos y ofrecer interfaces de integración y búsqueda. Asegurando su uso, los proveedores de datos ceden la gestión de sus metadatos a las agencias especializadas, que centralizan los registros y proporcionan una infraestructura para su recuperación a través de múltiples fuentes y dominios (Haak et al., 2018)

Así, agencias como Crossref y DataCite recopilan la información de las instituciones adscritas con el fin de ofrecer un valor agregado a los datos para cualquier interesado. Esto permite la recolección de datos para la construcción del dataset de un proyecto de investigación y su uso en la generación de métricas por parte de la revista evaluada, entre otros.

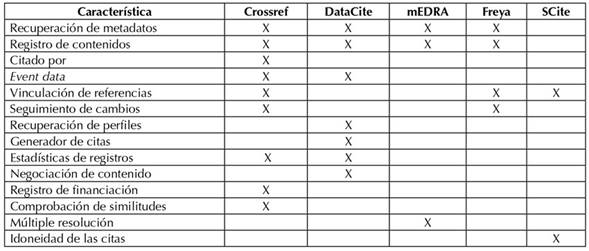

La Tabla 5 desglosa los servicios que ofrecen los cosechadores más utilizados (Hendricks et al., 2020), algunos de los cuales hacen uso de datos de terceros. Generalmente, estos cosechadores establecen diferentes protocolos de comunicación (OAI-PMH) y estándares de metadatos (Dublin Core).

Tabla 5: Comparativa de servicios ofrecidos por los cosechadores de metadatos.

Una de las características en común entre los cosechadores es la recuperación de los metadatos. Esto corresponde a la información de trabajos, autores y entidades, permitiendo realizar búsquedas especializadas sobre un recurso a través identificadores indexados. En esta misma línea está el registro del contenido, mediante el cual las agencias permiten la serialización de un recurso digital para identificarlo en la red. Un ejemplo de esto es el DOI, que es registrado por la agencia para utilizarlo al momento de publicar un trabajo en una revista, para así tener una trazabilidad a través de las citaciones en artículos, menciones en redes sociales y apariciones en blogs (Zhao et al., 2019).

Arquitectura propuesta

Teniendo en cuenta las herramientas y tecnologías expuestas anteriormente, este apartado define una arquitectura de integración para el diseño de una plataforma que obtenga metadatos de publicaciones científicas diseminados en repositorios instruccionales y cosechadores, con el fin de transformarlos en estadísticas e indicadores sobre las revistas y sus trabajos.

Analizando las alternativas en cuanto a la recolección de información por parte de las revistas para determinar indicadores bibliométricos, se optó por vincular las revistas disponibles en OJS. Esto, por la disponibilidad que tienen de los datos por medio del protocolo OAI-PMH. Dicho protocolo recibe peticiones por medio de la URL, obteniendo los datos registrados por las revistas para cada artículo publicado. Por otra parte, como estándar de metadatos, se seleccionó Dublin Core, al ser un estándar ampliamente reconocido por los elementos que lo componen, i.e., la instanciación del recurso con su identificador y la información del mismo.

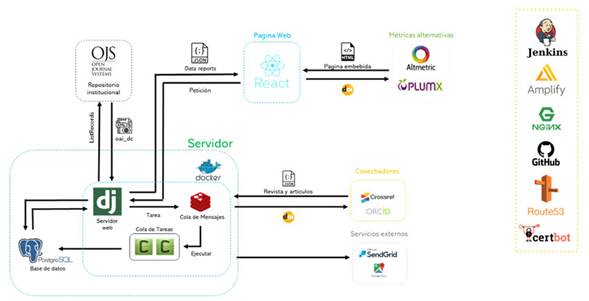

Como no todos los datos suministrados por el repositorio brindan información relevante, es necesario limpiar y transformar los datos. En la Figura 1 se observa la instanciación de un servidor web desarrollado en Python, el cual realiza la petición al repositorio institucional y captura todos los datos correspondientes a la consulta. De los datos recopilados, se obtienen principalmente las referencias usadas en los trabajos y los identificadores DOI. Estos identificadores se utilizan para hacer peticiones a las APIs de Crossref, Datasite y Freya. Debido a que estos comparten características, se puede distribuir la carga de peticiones por cada agencia y no depender de un solo punto para obtener los datos, solicitando información sobre visualizaciones, citaciones, el perfil del investigador, seguimiento de cambios y menciones en redes sociales de los trabajos. Estos datos son capturados y transformados para enviarlos como respuesta bajo el servicio REST al dispositivo por el cual fue realizada la consulta.

Figura 1: Diseño de arquitectura propuesta

Los indicadores se visualizan a través de una página web desarrollada bajo el framework de React. Como se observa en la Figura 1, se manejan cuatro relaciones: i) como punto de inicio, donde el usuario realiza la consulta al servidor; ii) como receptor de la respuesta que obtiene por parte del servidor luego de la obtención de los datos y su transformación; iii) el uso del identificador DOI para realizar la consulta en Altmetrics; y iv) la obtención de un recurso html embebido para visualizarlo a la par con los indicadores obtenidos a través de la consulta de los cosechadores.

Esta arquitectura permite el uso de múltiples usuarios en aplicación, sin necesidad de un software o requisitos específicos. Desacoplar las funcionalidades de captura y transformación de datos con su visualización permite una arquitectura adaptable a cambios tanto de lógica como de presentación, brindando la posibilidad de realizar ajustes sin afectar la codificación ya realizada. Como, a nivel de servidor, solo se hacen los procesos de extracción y transformación, si es necesario, se puede hacer de un balance de carga, teniendo múltiples instancias del servidor para ofrecer una mayor concurrencia.

La selección de tecnologías en la arquitectura se basó en el rendimiento. En cuanto al servidor, se necesitaba un lenguaje robusto que permitiera el manejo de grandes volúmenes de datos sin consumir muchos recursos a nivel de hardware, sin llegar a cuellos de botella al realizar los procesos de transformación de datos. A nivel de la página web se escogió un framework que estuviera bajo el principio de Single Page Application (SPA), en aras de brindar una experiencia fluida al usuario, buscando que el nivel de la codificación fuera modular, de tal manera que la implementación de cambios fuera sencilla.

Conclusiones

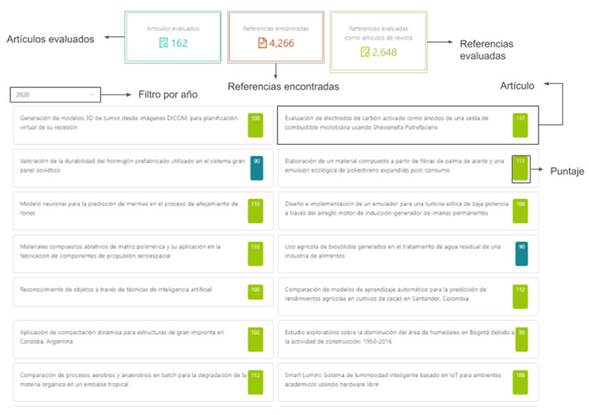

La arquitectura presentada anteriormente se implementó en un primer prototipo funcional de una plataforma para la validación de referencias citadas en revistas científicas. En esta arquitectura, a través del protocolo OAI-PMH de una revista, se extraen las referencias y metadatos de interés de los artículos disponibles para analizarlos y evaluarlos. En el proceso se realiza una clasificación de referencias, como se muestra en la Figura 2, indicando los artículos que fueron evaluados y la cantidad y la calidad de las referencias encontradas. Adicionalmente, se puede ver la lista de artículos filtrados por año con su respectivo puntaje. Al seleccionar un artículo, se muestra la información extraída del sistema OJS al detalle, junto con la evaluación realizada, en donde se consideran las referencias, el puntaje total y el puntaje obtenido en cada criterio de la evaluación.

Figura 2: Pantalla de resultados de análisis

Contar con una arquitectura interoperable permite que el responsable de una revista no tenga que estar continuamente verificando diversas plataformas, sino que, a través de un solo sistema, se consolide y valide la información. Sin embargo, es necesario resaltar que la calidad de la información depende de la veracidad de la información, la cual dependerá de lo reportado en los metadatos de los sistemas y de la información que tanto autores como editores hayan ingresado en cada uno de los sistemas. Por tanto, es necesario sensibilizarse sobre la necesidad de usar de manera adecuada las herramientas mencionadas en el trabajo

Referencias

License

Copyright (c) 2023 Juan-Sebastián González-Sanabria, Elena Verdú, Xiomara-Patricia Blanco-Valencia, Camila-Andrea Herrera-Melo, Julián-Camilo Serna-Vargas

This work is licensed under a Creative Commons Attribution-NonCommercial-ShareAlike 4.0 International License.

When submitting their article to the Scientific Journal, the author(s) certifies that their manuscript has not been, nor will it be, presented or published in any other scientific journal.

Within the editorial policies established for the Scientific Journal, costs are not established at any stage of the editorial process, the submission of articles, the editing, publication and subsequent downloading of the contents is free of charge, since the journal is a non-profit academic publication. profit.