DOI:

https://doi.org/10.14483/23448393.2091Published:

2007-11-30Issue:

Vol. 13 No. 1 (2008): January - JuneSection:

Science, research, academia and developmentControl de Calidad de Datos Oceanográficos Mediante una Herramienta Computacional

Oceanographic Data Quality Control By Means Of A Computational Tool.

Keywords:

Algoritmos, banderas de calidad, instrumentación oceanográfica, manejo de datos, RUP (es).Downloads

References

BODC. 2006. Data Quality Control Procedures: Draft Version 1.0 [en línea]. Sixth Framework of EC DG Research. [Consulta: 24 de abril de 2007]. Disponible en: http://www.simorc.com/documents/simorc/html_page/0617_simorc_quality_control_of_data__document.doc

CARDIN V. y PERINI L. 2005. Data quality control procedure applied to the M3A buoys [en línea]. Istituto Nazionale di Oceanografia e di Geofisica Sperimentale. [Consulta: 23 de abril de 2007]. Disponible en: www.mersea.eu.org/Insitu-Obs/DQCL0_M3A.pdf

CORIOLIS. 2005. In-situ data quality control [en línea]. Coriolis data centre. [Consulta: 24 de abril de 2007]. Disponible en: http://iodeweb5.vliz.be/ oceanteacher index.php?module=contextview&action= contextdownload&id=gen11Srv32Nme37_1766.

IOC. 1993. Manual of Quality Control Procedures for Validation of Oceanographic Data [en línea]. Manuals and Guides No. 26. [Consulta: 23 de abril de 2007]. Disponible en: http://unesdoc.unesco.org/ulis/cgibin/ ulis.pl?database=ged&set=462FB810_5_88&rec=9&mode=e&lin=1&req=2&nl= 1&sc1=1&sc2=1&ref=http://unesdoc.unesco.org/ulis/index.html&by=2.

IOC. 2008. IODE/JCOMM Forum on Oceanographic Data Management and Exchange Standards [en línea]. IOC Project Office for IODE. [Consulta: 10 de enero de 2008]. Disponible en: http://www.iode.org/ index.php?option=com_oe&task=viewEventRecord&eventID=181

NDBC. 2003. Technical Document 03-02, Handbook of Automated Data Quality Control Checks and Procedures of the National Data Buoy Center [en línea]. Consulta [Febrero de 2007]. Disponible en: www.ndbc.noaa.gov/ handbook.pdf

PLATE, M. 2001. Methods for Data Validation and Handling [en línea]. Consulta [Abril 24 de 2007]. Disponible en: www.sma.df.gob.mx/simat20/ ponencias/sesion5/validatinmplate_mathew2.pdf

PRESSMAN, R. 2002. Ingeniería de Software un enfoque práctico. Quinta edición. Editorial Mc Graw Hill.

SANCHEZ, R. 2006. Diseño e implementación de una herramienta computacional para el control de calidad y validación de datos oceanográficos físicos. Tesis de pregrado. Centro Control Contaminación del Pacífico y Programa de Ingeniería Física de la Universidad del Cauca. Colombia. 141 pp.

Bernal, Puente, Rodríguez. Aplicación de las tecnologías de la información y las comunicaciones en el control de calidad de datos oceanográfico. Universidad Distrital francisco José de Caldas. Tesis de Pregrado

How to Cite

APA

ACM

ACS

ABNT

Chicago

Harvard

IEEE

MLA

Turabian

Vancouver

Download Citation

Ingeniería, 2008 vol:13 nro:1 pág:77-83

Control de calidad de datos oceanográficos mediante una herramienta computacional

Oceanographic data quality control by means of a computational tool.

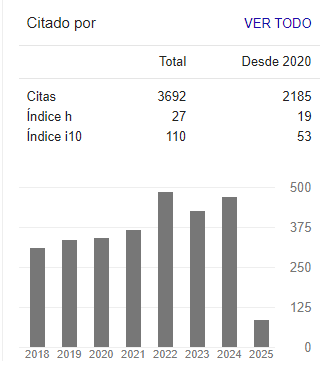

Octavio José Salcedo

Director del grupo de Investigación Internet Inteligente de la Universidad Distrital Francisco José de Caldas

Francisco Javier Puente

Pertenece al grupo de Investigación Internet Inteligente de la Universidad Distrital Francisco José de Caldas

Ruby Viviana Ortiz

Pertenece al grupo de Investigación Oceanografía Operacional del CCCP

Resumen

Este articulo describe una aplicación de las Tecnologías de la Información (TI) en el procesamiento de datos y la implementación de pruebas de calidad a datos oceanográficos tomados por una boya de oleaje direccional con el propósito de contar con información confiable para pronósticos en el área de oceanografía.

El desarrollo de los algoritmos computacionales y la asignación de la calificación están integrados al desarrollo de una herramienta computacional construida bajo el Proceso Racional Unificado que permite, de acuerdo a los estándares propios del programa Internacional de Intercambio de Datos e Información Oceanográfica (IODE-COI), validar los datos ordinarios medidos por los sensores propios de este tipo de equipos de investigación: Waverider (oleaje) y thermistor embedded (temperatura), y ADCP (corriente), y la asignación de banderas de calidad a partir de reglas y algoritmos desarrollados a partir de las investigaciones realizadas y consultado los documentos del área que reúnen las recomendaciones y experiencias de la comunidad internacional oceanográfica en esta área.

Como resultado de esta investigación se obtuvo una herramienta software llamada "ZuNaMy" que garantiza que datos medidos por este tipo de sensores que actualmente se han fondeado en la costas colombianas, sean sometidos a cada una de las etapas que comprende el control de calidad de datos oceanográficos (entre ellas la verificación de su consistencia y calificación); en este contexto se asegura la interoperabilidad bajo el formato NetCDF[1] (Network Common Data Form) ampliamente utilizado y aceptado por la comunidad internacional para el intercambio de mediciones oceanográficas.

Palabras clave: Algoritmos, banderas de calidad, instrumentación oceanográfica, manejo de datos, RUP.

Abstract

This paper describes an application of Information Technologies (IT) in the data- processing and implementation of quality tests to oceanographic data measured by a wave directional ocean buoy with the goal of having reliable information for forecasting in the field of oceanography.

The development of computational algorithms and the allocation of qualification flags are integrated into the development of a computational tool built under the Rational Unified Process which, according to the standards of the program International Exchange and Ocean Information (IODE - COI), validate the data measured by this kind of devices: Waverider (wave) and embedded thermistor (temperature), and ADCP (current), and the allocation of quality flags from rules and algorithm developed from research and consulting enhancements documents of the area that meet the recommendations and experiences of the international oceanographic community in this area.

As a result of this research was a software tool called "ZuNaMy" which ensures that data measured by this kind of sensors that investors are currently at anchor of the Colombian coast, are subjected to every step that includes oceanographic data control quality (including verification of their qualifications and consistency), in this context will ensure interoperability under the format NetCDF (Network Common Data Form) widely used and accepted by the international community to exchange oceanographic measurements.

Key words: Algorithms, quality flags, oceanographic instrumentation, data managing, RUP.

1. Introducción

La Autoridad Marítima Nacional (DIMAR) en calidad de organismo regulador del desarrollo sostenible del ambiente marino en Colombia, ha especializado a sus centros de investigación ubicados en el Pacífico (Centro Control Contaminación del Pacífico - CCCP) y en el Caribe (Centro de Investigaciones Oceanográficos e Hidrográficos - CIOH), en la medición de parámetros oceanográficos físicos y de meteorología marina para mejorar la capacidad de observación, diagnóstico, análisis, conocimiento y predicción de la variabilidad climática. Esto ha generado un interés para el aseguramiento de la calidad de los datos que enriquecerán los sistemas de monitoreo colombiano[2] con el fin de utilizar dicha información en el mejoramiento de la calidad de la vida humana en el mar y en la toma de decisiones relacionadas con actividades marítimas como navegación, fenómenos naturales del océano y comportamiento del litoral.

La calidad de las mediciones oceanográficas recopiladas por los sensores está estrechamente relacionada con el estado de los dispositivos electrónicos que pueden sufrir fallas de calibración, transmisión, configuración o bien pueden presentarse las propiedades emergentes inherentes de cada sistema que ocasionen datos inconsistentes e incorrectamente geo-referenciados. En este contexto, la aplicación de las TI brinda la posibilidad de revelar la calidad de la información científica, recurso fundamental del presente estudio, y brindar una serie de ventajas claves como la de mantener estándares comunes, obtener datos consistentes y entregar datos confiables, íntegros y disponibles en los diferentes estudios oceanográficos del orden nacional, regional e internacional.

El objetivo primordial de esta investigación es descubrir los mecanismos necesarios para validar los parámetros, acto seguido se pretende utilizar las TI mediante el desarrollo de una herramienta computacional para garantizar la obtención de valores lógicos y coherentes con las condiciones del escenario de medición, ya sea in situ o a través de sensores remotos. Con el apoyo de las TI se espera mejorar los tiempos en los que se realiza esta operación.

2. Antecedentes

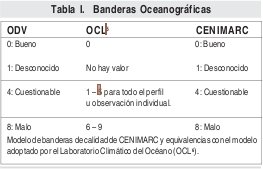

A la fecha no se ha definido un estándar único mundial en cuanto a procedimientos de validación y control de calidad de datos de boyas de oleaje y corrientes (IOC, 2008), sin embargo, pueden encontrarse varias experiencias en el ámbito internacional; la primera de ellas la presentó la Comisión Oceanográfica Intergubernamental (COI) a través del programa IODE, desarrollando un manual de procedimientos de control de calidad para la validación de datos oceanográficos en el cual describe algoritmos base para el control de calidad de datos oceanográficos con distintos instrumentos, entre ellos el CTD (Conductivity Temperature Depth) y boyas de oleaje (IOC, 1993). En Norte América, el Centro Nacional de Datos de Boyas (NDBC) ha desarrollado una guía para la automatización de pruebas de calidad y procedimientos específicamente para datos provenientes de boyas de oleaje (NDBC, 2003), el cual introduce algoritmos para el control de calidad y asignación de banderas de dos tipos (Banderas Suaves y Banderas Fuertes) que fueron el punto de partida del presente estudio. Más recientemente, el Centro de Datos Oceanográficos Británico junto con la comunidad SIMORC[3] presenta su primera versión del manual de procedimientos para el control de calidad y validación de datos oceanográficos y meteorológicos, sobre asignación de banderas de calidad y finalmente introduce una descripción del for mato NetCDF para el intercambio de datos (BODC, 2006). En el ámbito colombiano, se reconoce una primera experiencia en el tema de estudio con la participación del programa de Ingeniería Física de la Universidad del Cauca, en donde su resultado genero por parte del CCCP una herramienta software en donde se efectúa el control de calidad de datos de temperatura de la columna de agua y salinidad medida con CTD (SANCHEZ, 2006). En el documento final se describen los algoritmos utilizados y el modelo de banderas de calidad adaptadas por la Central de Información Marina de Colombia (CENIMARC), modelo hacia el cual se enfocan los resultados de este estudio.

3. Metodología utilizada

Para el desarrollo de la herramienta computacional se siguió la metodología RUP[4], escogida por que está basada en mejores prácticas, lo que contribuye a la definición y planteamiento de los requerimientos, la metodología se puede ir retroalimentando hito a hito y además tiene mucha aceptación en el desarrollo de software debido a que es un modelo de proceso de software híbrido (PRESSMAN, 2002), combinando elementos de los modelos de procesos genéricos.

3.1. Fase I. Inicio

En la fase de inicio se realizó el análisis del entorno, la identificación de variables que intervienen en el proceso, la identificación de actores y entidades que hacen parte del manejo de los datos de estudio. Se elaboró el modelo que recopila información de las entidades involucradas.

En el análisis del entorno e identificación de variables que intervienen en el proceso se tomó como base documental el modelo de banderas de calidad implementadas en el Ocean Data View (ODV) y a las adoptadas por el repositorio colombiano de datos oceanográficos (ver Tabla I).

[5][6}

[5][6}

Durante esta etapa se definieron los parámetros para el control de calidad y validación de datos oceanográficos, estos parámetros son: Altura Significativa de la ola, dirección de la ola, temperatura de la columna de agua y velocidad de la corriente en la columna de agua.

Para concluir la fase, teniendo en cuenta los siguientes hallazgos in situ, se realizó el análisis de riesgos respecto a las características de los datos disponibles en el repositorio de la estación receptora, los cuales serán ingresados a la Central de Información Marina Colombiana (CENIMARC):

• El sistema se configuró para transmitir información cada hora y no se observaba la constante horaria.

• La información se almacena en carpetas y se evidenció la ausencia de carpetas que contienen las medidas de los parámetros.

• Se encontraron valores de los parámetros que sobrepasan los valores lógicos.

• Los datos son almacenados por el software del fabricante de los sensores en forma matricial, pero ante la ausencia de datos dicho sistema registra espacios en blanco, los cuales no pueden ser interpretados por el validador de entrada de datos de CENIMARC.

Estos riesgos y los problemas asociados inherentes a ellos fueron hallados una vez que se adaptaron los archivos planos del repositorio de varios meses a un formato el cual pudiera ser importados por una hoja de cálculo, debido a la imposibilidad de generar un grafico continuo durante el tiempo de muestra, se concluyo que algunos archivos planos no tenían la información completa del estado del océano en un día. De la misma manera se observaron valores por debajo del valor esperado para la época del año.

Así, el análisis del entorno se delimitó a los errores presentes en los datos debido a la pérdida de información durante la transmisión, la cual podría causar según Plate, 2001: (a) afirmaciones que no estén acordes con el comportamiento real del océano, (b) análisis equivocados de la información, (c) restricciones para interactuar con otras agencias de investigación y (d) generar estadísticas históricas inconsistentes.

3.2. Fases II y III. Elaboración y construcción

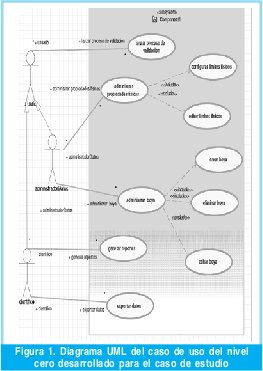

La fase de elaboración, durante esta etapa se definieron los casos de uso (Ver Figura 1) para los siguientes actores: (1) Usuario; operador con conocimientos básicos en ciencias del mar (2) Investigador, experto en oceanografía que utiliza el software para inspeccionar la calidad de los datos: (3) Administrador de Datos, es el administrador de los datos del sistema, responsable de la generación de los archivos de salida para alimentar oportunamente CENIMARC, adicionalmente edita los límites físicos de los parámetros si el investigador lo solicita.

Posteriormente se detallaron los casos de uso planteados en la Figura 1 y el diagrama UML de clases, los cuales fueron refinados a través de las iteraciones del proceso de desarrollo y documentados en [10], el diagrama de clases resultante se encuentra divido por capas: la capa de presentación que incluye todas las clases de elementos gráficos que se utilizan en la implementación y diseño de la interfaz gráfica del software; la capa de negocio (ver Figura 2) que son las clases que soportan toda la lógica del software para realizar las actividades de control de calidad y validación de datos oceanográficos, mientras que la persistencia de s los datos validados es almacenada un repositorio físico en el equipo, en el cual se utilizan las funciones propias de I/O de Matlab.

En esta misma etapa se definió el flujo de actividades que la herramienta desarrollada debe cumplir para realizar la validación de datos, este flujo actividades esta descrito en la Figura 3 y resultado de las iteraciones [10]. Cabe mencionar que se realizo una partición en el diagrama con el propósito de ilustrar el proceso desde el inicio del muestreo propio de los sensores hasta el final de la validación de datos y los resultados generados a partir del proceso.

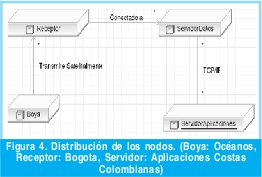

Al tener una distribución a lo largo del territorio nacional se identificaron características del sistema teniendo en cuenta el diagrama de despliegue de la Figura 4, en el cual se define el algoritmo propietario de Axys technology ya que es quien proporciona las mediciones de los parámetros.

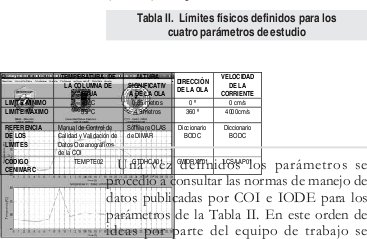

En las fase I y la fase II se procedió con la definición de los límites físicos mínimo y máximo de cada uno de los cuatro parámetros

medidos (Ver Tabla II), los cuales se obtuvieron a partir de las especificaciones técnicas de los sensores instalados en la boya, la documentación de la COI, el software OLAS de DIMAR y de las especificaciones del fabricante de la boya con su correspondencia en el diccionario de parámetros oceanográficos del Centro de Datos Oceanográficos Británico (BODC)[7] adaptado a CENIMARC.

Una vez definidos los parámetros se procedió a consultar las normas de manejo de datos publicadas por COI e IODE para los parámetros de la Tabla II. En este orden de ideas por parte del equipo de trabajo se estableció mediante una matriz de responsabilidad (RAZI) descrita en [10] el desarrollo y codificación de los requerimientos definidos.

3.3. Fase IV. Transición

La fase de transición se procede a instalar y probar la herramienta desarrollada en Matlab con los datos de prueba (paquetes hasta el momento recolectados) para verificar la funcionalidad de los algoritmos implementados, la asignación de banderas y la interfaz grafica. En esta fase se evidenció la necesidad de que para cada conjunto de datos horario existan los tres archivos base del software del fabricante (STATUS, WAVE y CURRENT), como requerimiento de puesta en marcha de la herramienta. Aunque inicialmente la herramienta fue desarrollada para su ejecución en tiempo real, se consideró importante flexibilizarla en esta fase de transición para validar datos de periodos de tiempo diferentes al actual, y así verificar los resultados de las

pruebas.

La herramienta tiene dos tipos de salidas: la primera se trata de un reporte estadístico que se encarga de suplir el requerimiento generar reporte dado un periodo de tiempo sobre las banderas aplicadas a los datos y del número de registros recibidos con relación a los esperados, por ejemplo, en un día se esperarían 24 registros, uno por cada hora. Este reporte es acompañado de gráficas temporales donde se puede visualizar tanto el comportamiento de cada parámetro con todos los valores registrados originalmente (ver Figura 5) como los valores calificados como buenos.

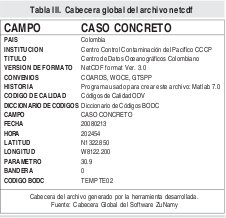

El segundo tipo de salida que genera el software para cumplir con la condición de exportar datos son los archivos planos en los formatos CVS y como archivos NetCDF. Este archivo consiste en unas cabeceras que explican el contenido del archivo y a continuación la matriz de datos. Para la cabecera global de se definió como lo muestra la tabla III: el país, la institución que realiza el control de calidad, versión de for mato netcdf utilizado, diccionario de datos oceanográficos utilizado, banderas de calidad utilizadas entre otros campos. Con la implantación de la herramienta computacional se genero una relación de beneficio en cuanto al tiempo que toman los investigadores en desempeñar la tarean de seguimiento a loso datos transmitidose por la boya de oleaje.

4. Resultados

El desarrollo de la investigación condujo a establecer axiomas matemáticos que permiten asignar las banderas de calidad a los parámetros de los datos transmitidos. Estos axiomas son descritos a continuación:

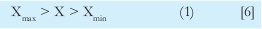

• Chequeo contra límites físicos válidos: Esta función esta diseñada para comparar los valores observados con los límites físicos inferior y superior definidos para cada parámetro:

• Consistencia del perfil. En esta prueba se calcula el valor estadístico del valor mínimo y máximo de cada conjunto de datos para verificar si los datos son internamente consistentes es decir con respecto a su propio perfil (columna de agua) o con los de un día o mes comparables

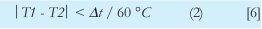

• Temperaturas consecutivas: Esta función esta diseñada para detectar los errores en la medida de la temperatura de la columna de agua, donde T1 y T2 son medidas de temperatura consecutivas y es el intervalo de la muestra en minutos. El numero 60 se refiere al cambio de dos temperaturas consecutivas que no puede superar este umbral y es un número definido en el manual de la COI.

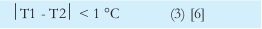

• Tasa de cambio en las temperaturas: Este algoritmo verifica que el cambio de dos temperaturas consecutivas no sea mayor que un grado centígrado, donde T1 y T2 son medidas de temperatura consecutivas en una hora, es decir, que la temperatura de T2 menos la de T1 no debe ser mayor a 1°C.

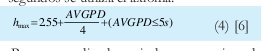

• Altura de la ola versus promedio del periodo de la ola: Este algoritmo permite verificar la altura significativa máxima de la ola permitida según el promedio del periodo de la ola. Para promedio de periodos por debajo de 5 segundos se utiliza el axioma:

Para promedio de periodos por encima de 5 segundos se utiliza el axioma:

La máxima altura de la ola permitida según el promedio de los periodos de las olas hmax , y en donde AVGPD es el promedio de periodo de la ola.[6]

•Dirección de la ola: Se examinan todos los valores de dirección de la ola (determinada a cualquier frecuencia) que estén dentro de 000° y 360°. [6]

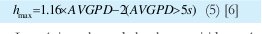

•Directional spread 2: Esta prueba se aplica debido a que la dirección de propagación es muy sensible a errores en los instrumentos y ruidos. El algoritmo verifica que la dirección de propagación de la ola 2 no se pase de un límite máximo indicado ya que esta dirección está estrechamente ligada a la dirección de la ola. Esta prueba 2 del espectro del pico de la ola se debe hacer para cualquier valor de 2 mayor que 30°, es decir cualquier dato que de acuerdo a la medición de los sensores proviene de las costas será marcado con la bandera de calidad (8) - dato malo. Adicionalmente a los axiomas se establecieron las reglas. Para el caso de estudio se establecieron las reglas de la Tabla IV y su equivalencia con los valores de las banderas de calidad de CENIMARC.

5. Conclusiones

El uso de las TI en ambientes oceanográficos involucra una ganancia en la certeza de la información y la posibilidad de tomas de decisiones con mayor rapidez gracias a la velocidad de procesamiento que estas tienen, esto a su vez representa un progreso importante para Colombia. Debido a esta investigación las autoridades nacionales podrán avisar con mayor celeridad y precisión a las poblaciones costeras cuales podrían ser su situación de riesgo a

partir de pronósticos con datos validados y de las condiciones oceanográficas actuales.

De acuerdo a las pruebas realizadas, el proceso de validación manual de los datos medidos por una boya de oleaje direccional tarda entre 4 a 6 horas; con el uso de la herramienta desarrollada debidamente configurada la duración del proceso de control de calidad se reduce a 2 minutos a la sumo. Esto muestra la importancia de aplicar las tecnologías de la información en la cadena de suministro de datos e información oceanográfica.

Con el uso de la herramienta desarrollada se asegura la disponibilidad, integridad y confiabilidad oportuna de datos de temperatura superficial de la ola, dirección de la ola, altura de la ola y velocidad de la ola del oleaje en el repositorio de CENIMARC; además le permitirá a los investigadores contar con un criterio de calidad para determinar su uso en los diferentes estudios de cambios climático, morfología de costa, validación de modelos de pronósticos, etc.

Con la aplicación de la metodología RUP el sistema pudo ser interpretado como un todo, lo cual permitió adaptar el análisis de datos de oleaje planteados por el NDBC y el programa IODE-COI a las necesidades y especificaciones del caso colombiano. Además, dadas las características de diseño este podría ser ajustado al análisis de los mismos parámetros en otras regiones del continente debido a su flexibilidad en la configuración de los límites físicos mínimos y máximos de los cuatro parámetros nombrados anteriormente.

Con el uso de las tecnologías de información se logra no solo innovar con el uso de boyas direccionales de oleaje de transmisión en tiempo real por parte de la DIMAR, sino que se logró automatizar y estandarizar un proceso de control de calidad de datos oceanográficos colombianos.

Con esta primera implementación del formato NetCDF como archivos de salida de software oceanográfico colombiano se da un avance importante en el tema de intercambio de datos oceanográficos en el ámbito nacional y regional.

Referencias bibliográficas

- BODC. 2006. Data Quality Control Procedures: Draft Version 1.0 [en línea]. Sixth Framework of EC DG Research. [Consulta: 24 de abril de 2007]. Disponible en: http://www.simorc.com/documents/simorc/html_page/06- 17_simorc_quality_control_of_data__document.doc

- CARDIN V. y PERINI L. 2005. Data quality control procedure applied to the M3A buoys [en línea]. Istituto Nazionale di Oceanografia e di Geofisica Sperimentale. [Consulta: 23 de abril de 2007]. Disponible en: www.mersea.eu.org/Insitu-Obs/DQCL0_M3A.pdf

- CORIOLIS. 2005. In-situ data quality control [en línea]. Coriolis data centre. [Consulta: 24 de abril de 2007]. Disponible en: http://iodeweb5.vliz.be/ oceanteacher index.php?module=contextview&action= contextdownload&id=gen11Srv32Nme37_1766.

- IOC. 1993. Manual of Quality Control Procedures for Validation of Oceanographic Data [en línea]. Manuals and Guides No. 26. [Consulta: 23 de abril de 2007]. Disponible en: http://unesdoc.unesco.org/ulis/cgibin/ ulis.pl?database=ged&set=462FB810_5_88&rec=9&mode=e&lin=1&req=2&nl= 1&sc1=1&sc2=1&ref=http://unesdoc.unesco.org/ulis/index.html&by=2.

- IOC. 2008. IODE/JCOMM Forum on Oceanographic Data Management and Exchange Standards [en línea]. IOC Project Office for IODE. [Consulta: 10 de enero de 2008]. Disponible en: http://www.iode.org/ index.php?option=com_oe&task=viewEventRecord&eventID=181

- 6. NDBC. 2003. Technical Document 03-02, Handbook of Automated Data Quality Control Checks and Procedures of the National Data Buoy Center [en línea]. Consulta [Febrero de 2007]. Disponible en: www.ndbc.noaa.gov/ handbook.pdf

- PLATE, M. 2001. Methods for Data Validation and Handling [en línea]. Consulta [Abril 24 de 2007]. Disponible en: www.sma.df.gob.mx/simat20/ ponencias/sesion5/validatinmplate_mathew2.pdf

- 8. PRESSMAN, R. 2002. Ingeniería de Software un enfoque práctico. Quinta edición. Editorial Mc Graw Hill.

- SANCHEZ, R. 2006. Diseño e implementación de una herramienta computacional para el control de calidad y validación de datos oceanográficos físicos. Tesis de pregrado. Centro Control Contaminación del Pacífico y Programa de Ingeniería Física de la Universidad del Cauca. Colombia. 141 pp.

- Bernal, Puente, Rodríguez. Aplicación de las tecnologías de la información y las comunicaciones en el control de calidad de datos oceanográfico. Universidad Distrital francisco José de Caldas. Tesis de Pregrado

Notas

- Es una representación binaria cuyas principales compuesto de una cabecera que documenta las características de los datos.

- 2Proyecto denominado Sistema de Medición de Parámetros Oceanográficos y de Meteorología Marina (SMPOMM).

- Tomado del inglés: Ocean data for Offshore and Research Communities.

- Tomado del inglés: Rational Unified Process.

- Laboratorio Climático del Océano.

- Tomado del inglés: Laboratorio Climático del Océano.

- Tomado del inglés: British Oceanographic Data Centre.

Creation date:

License

From the edition of the V23N3 of year 2018 forward, the Creative Commons License "Attribution-Non-Commercial - No Derivative Works " is changed to the following:

Attribution - Non-Commercial - Share the same: this license allows others to distribute, remix, retouch, and create from your work in a non-commercial way, as long as they give you credit and license their new creations under the same conditions.

2.jpg)