DOI:

https://doi.org/10.14483/22486798.3157Publicado:

01-07-2010Número:

Vol. 15 Núm. 2 (2010): Experiencias de investigación sobre evaluación (Jul-Dic)Sección:

Artículo de InvestigaciónLa evaluación externa de la producción escrita en Bogotá (2005-2007): más allá de la búsqueda del déficit en los estudiantes

The external large-scale evaluation carried out between 2005-2007, in the fifth and ninth grades of the secondary school, by the secretaría de educación of Bogotá

Palabras clave:

evaluación, escritura, producción textual, política educativa, política evaluativa (es).Palabras clave:

Evaluation, writing, text production, education policy, politics evaluative (en).Descargas

Referencias

Adam, J. M. (2001). Les textes, types et prototypes. Paris: Nathan.

Adam, J. M. (1999). Linguistique textuelle. Paris: Nathan.

Bajtin, M. (1998). Estética de la creación verbal. México: Siglo XXI.

Bronckart, J. P. (1996). Activité Langagiere, Textes et Discours. Paris: Niestle.

Bustamante, G. & Pérez Abril, M. (1996). Evaluación escolar, resultados o procesos. Bogotá: Magisterio.

Chartier, R. (1995). El orden de los libros. Barcelona: Gedisa.

Icfes (2007). Sobre las pruebas Saber y de Estado: una mirada a su fundamentación y orientación de los instrumentos en lenguaje. Bogotá: Icfes.

Jurado, F. (2009). Los sistemas nacionales de evaluación en América Latina: ¿Impacto pedagógico u obediencia institucional? Bogotá: Editorial Universidad Nacional de Colombia.

Kalman, J. (2000). Ya sabe usted, es un papel muy importante: el conocimiento de la lengua escrita en mujeres de baja o nula escolaridad. México: Colección Pedagógica Universitaria. No 32-33. Edición de 25 Aniversario. Recuperado de http://www.uv.mx/cpue/coleccion/N_32_33/Ya_sabe_usted.html

Murillo Torrecilla, F. J. (2008). Los modelos multinivel como herramienta para la investigación educativa. Magis, Revista Internacional de Investigación en Educación, 1(1): 45-62.

Pérez Abril, M. (2003a). Leer y escribir en la escuela. Algunos escenarios pedagógicos y didácticos para la reflexión. Bogotá: Icfes.

Pérez Abril, M. (2003b). Evaluar para transformar aportes de las pruebas Saber al trabajo en el aula. Una mirada a los fundamentos e instrumentos de lenguaje 2002-2003. Bogotá: Icfes.

Perrenoud, P. (2008). La evaluación de los alumnos. De la producción de la excelencia a la regulación de los aprendizajes. Entre dos lógicas. Buenos Aires: Colihue.

Rockwell, E. (1995). La escuela cotidiana. México: Fondo de Cultura Económica.

Secretaría de Educación de Bogotá (2005). Lineamientos de evaluación para Bogotá. Bogotá: Secretaría de Educación de Bogotá.

Secretaría de Educación de Bogotá (2007a). Las evaluaciones externas y la evaluación de aula en lenguaje. Bogotá: Alcaldia Mayor de Bogotá.

Secretaría de Educación de Bogotá (2007b). Resultado de la pruebas Comprender de lenguaje. Primera aplicación. Grados quinto y noveno. Análisis comprensivo y pedagógico. Bogotá: Secretaría de Educación de Bogotá.

Secretaría de Educación de Bogotá (2007c). Serie Cuadernos de Evaluación.Pruebas Comprender de lenguaje. Evaluación de la comprensión y el aprendizaje. Grados 5° y 9°. Guía de orientación para profesores. Bogotá: Secretaría de Educación Distrital y Alcaldía Mayor de Bogotá. Recuperado de

Verón, E. (2005). Fragmentos de un tejido. Barcelona: Gedisa.

Cómo citar

APA

ACM

ACS

ABNT

Chicago

Harvard

IEEE

MLA

Turabian

Vancouver

Descargar cita

La evaluación externa de la producción escrita en Bogotá (2005-2007): más allá de la búsqueda del déficit en los estudiantes

The external large-scale evaluation carried out between 2005-2007, in the fifth and ninth grades of the secondary school, by the secretaría de educación of Bogotá

Mauricio Pérez-Abril* Milena Barrios Martínez**

Cómo citar este artículo: Castrillón, C.,Camargo, Z. y Caro, M.(2010). La evaluación externa de la producción escrita en Bogotá (2005-2007): más allá de la búsqueda del déficit en los estudiantes. Enunciación 15 (2) 17-31

Recibido: 10 de abril de 2010 / Aceptado 18 de mayo de 2010

*Docente e investigador de la Facultad de Educación de la Pontificia Universidad Javeriana de Bogotá, Colombia. Filólogo, con estudios de posgrado en desarrollo curricular. Candidato a Doctor en Educación de la Universidad Pedagógica Nacional de Colombia. Director del grupo de investigación Pedagogías de la Lectura y la Escritura. Correo electrónico: mauricioperezabril@gmail.edu.co

**Psicopedagoga de la Universidad Pedagógica Nacional. Docente de la Facultad de Educación de la Pontificia Universidad Javeriana de Bogotá. Magíster en Educación de la Pontificia Universidad Javeriana. Miembro del grupo de investigación Pedagogías de la Lectura y la Escritura. Correo electrónico: milebama17@yahoo.com

Resumen

En este artículo se explicitan algunos de los elementos centrales de la propuesta de evaluación masiva y externa, realizada por la Secretaría de Educación de Bogotá durante los años 2005 al 2007, para los grados quinto y noveno de educación básica, como parte de la política educativa de la ciudad, que respondió a una perspectiva de la evaluación como comprensión y como investigación. La apuesta de la política, en este caso, se orientó a retomar los procesos evaluativos ligados a procesos de investigación, orientados por criterios que van más allá de la medición estandarizada de resultados y de la búsqueda del déficit en los estudiantes. Para adelantar estas acciones, la Secretaría de Educación invitó a diferentes grupos de investigación de distintas universidades de la ciudad, situados en perspectivas conceptuales y metodológicas diferentes, para ocuparse de poner en marcha este proceso evaluativo, al menos desde dos enfoques distintos para cada campo de conocimiento, de tal modo que se pudiera contar con dos lecturas complementarias del objeto de evaluación.

El artículo se basa en la investigación realizada por nuestro grupo como partícipe de este proceso y presenta algunos de los elementos distintivos de la evaluación desarrollada. Especialmente se presenta la posición sobre evaluación, los elementos constitutivos de la situación de evaluación y los efectos que produce optar por un tipo de situación. De manera breve, también se presenta el instrumento definido y una síntesis de los resultados.

Palabras clave: evaluación, escritura, producción textual, política educativa, política evaluativa.

Abstract

This paper analyzes some key elements of the external large-scale evaluation carried out between 20052007, in the fifth and ninth grades of the secondary school, by the Secretaría de Educación of Bogotá. The evaluation study as part of the educational policy, was based mainly on research processes and it was oriented by criteria that pretended to overcome the measurement of standardized results and the deficit approach in education. To accomplish the study, groups of re- searchers belonging to different universities and knowledge fields were invited to participate, so that the study will assume at least two different and complementary conceptual perspectives to understand the object of evaluation.

This paper focuses on the work made by my research group as participant in the study. It presents the distinctive evaluation conception, the elements of the evaluative situation, the effects produced by the se- lection of a specific situation, as well as the instrument and a brief summary of the results.

Keywords: Evaluation, writing, text production, education policy, politics evaluative.

Introducción

Resulta hoy ingenuo pedirle a un proceso evaluativo que sea objetivo, por más técnicamente realizado que esté, soportado conceptualmente, avalado por juicios de expertos o apoyado en sofisticados y complejos modelos de procesamiento estadístico. Esta afirmación sobre la imposibilidad de objetividad (Bustamante & Pérez, 1996) opera de igual modo tanto para la evaluación en el aula, como para la evaluación masiva y para la externa. Para el caso de la evaluación de los aprendizajes, la situación resulta particularmente compleja: por un lado, porque definir, acotar y medir aquello que se evalúa el objeto es una tarea difícil, pues no se trata de algo dado, de un dato que se recoge, se procesa y se mide de modo aproblemático; se trata, en gran medida, de un dato que produce el evaluador, sea éste el Estado, el profesor o la institución. Un dato que se construye, entre otros aspectos, en función de la concepción sobre la enseñanza, el aprendizaje, la noción de sujeto, y que se orienta desde intereses académicos, políticos, las posturas éticas e ideológicas de quien realiza la evaluación.

Por otro lado, porque los estudiantes no están situados en las mismas condiciones de acceso al capital simbólico. Las coordenadas socio-espacio-temporales en las que se nace; la pertenencia a una clase económica, a una familia, a un entorno particular disponen de modo diferente a los sujetos para sus recorridos a través de las aulas, de los currículos, de los modos de enseñar, y estos aspectos inciden de manera fuerte en los resultados arrojados en los procesos evaluativos, hasta el punto de dudar si lo que se evalúa es el capital simbólico de los sujetos (ligado a la procedencia de clase o la desigualdad en el acceso a la cultura escrita) o los saberes que se enseñan en la escuela. Dicho en otro registro, resulta complejo medir el “efecto colegio” solo a través de instrumentos estandarizados, pues es muy difícil discriminar la incidencia del contexto sociocultural y familiar, así como de las disposiciones del sujeto, a la hora de evaluar. Cabe señalar que las investigaciones basadas en modelos multinivel sí logran medir el “efecto colegio” y “el efecto aula”, pero empleando diversidad de fuentes:

Los modelos multinivel constituyen la metodología de análisis más adecuada para tratar datos “jerarquizados” o “anidados” (por ejemplo, los estudiantes en aulas, o las aulas en escuelas), lo que la convierte en una estrategia imprescindible para la investigación educativa de carácter cuantitativo. Así, además de mejorar la calidad de los resultados, posibilita realizar análisis novedosos, tales como estimar la aportación de cada nivel de análisis (la del efecto del aula o la escuela) o las interacciones entre variables de distintos niveles. De esta forma se está en mejores condiciones de realizar estudios sobre factores asociados, sobre valor agregado o sobre equidad educativa, entre otros (Murillo, 2008, p. 45).

Así las cosas, si se emplea un único instrumento resulta difícil saber si el resultado de tal evaluación es una medición más de las desigualdades sociales, para lo cual no se requeriría adelantar evaluaciones. Esta situación conlleva a que en los procesos evaluativos se acuda a otras fuentes de información adicional a la arrojada por los instrumentos estandarizados.

Por su parte, al intentar medir los aprendizajes, los instrumentos se estrellan contra la diversidad de sujetos, sus trayectorias, sus disposiciones; estos elementos distan mucho de ser medibles de modo comparable y estable. Por esto, algunos sistemas de evaluación en América Latina (Jurado, 2009), interpretan los resultados de sus procesos evaluativos en relación con los factores socioeconómicos y socioculturales, propios de los estudiantes y las escuelas. Si bien esto no soluciona el asunto de la objetividad, al menos reduce la ingenuidad. Esto conduce, necesariamente, a asumir que las escalas homogéneas estandarizadas para toda la población, en los procesos de evaluación masiva y externa son problemáticas.

Por lo anterior, se evidencia la dificultad de legitimar una evaluación masiva y externa, apoyándose únicamente en instrumentos y escalas de evaluación de los aprendizajes. Consideramos que parte de la legitimidad de la evaluación ha de buscarse del lado de la explicitación de los propósitos que persigue el proceso evaluativo a nivel global, y del análisis de las decisiones e implicaciones derivadas de haber optado por una u otra perspectiva teórica, por uno u otro tipo de instrumento; de haber elegido cierto modo de abordar los datos que, dicho sea de paso, son producidos por esas posiciones desde las que la evaluación se diseña, se piensa, se realiza. Por lo tanto, resulta central, en cualquier proceso evaluativo, señalar las razones por las que se elige una perspectiva y los intereses concretos que la orientan.

Pero estas afirmaciones no implican que sea imposible evaluar: exigen reconocer que hay diversas posibilidades, que un objeto de evaluación puede construirse de diferentes modos y que es posible generar diversidad de tipos de resultados que, a su vez, pueden producir diferentes efectos. Es decir, esto supone situarse más del lado de la evaluación como comprensión e investigación que de la evaluación como fábrica de producción de jerarquías generalizantes (Perrenoud, 2008).

En este encuadre, a la evaluación masiva y externa deberá pedírsele que explicite los supuestos en los que se soporta, desde qué enfoque teórico sobre el lenguaje en nuestro caso, se realiza, por qué razones se opta por esa y no por otra perspectiva, por qué se eligió y se diseñó cierto tipo de situación de evaluación y no otra, pues de esas decisiones se derivan sus efectos. Esta no es una novedad de la investigación que presentamos, pero sirve de marco para justificar el sentido de este texto: mostrar las decisiones que se tomaron en un proceso particular, especialmente en relación con el diseño de la situación evaluativa.

En este marco, buscamos hacer un aporte a esa tarea de explicitación. Nos interesa presentar la perspectiva por la que se optó en un momento particular de la política educativa de la ciudad de Bogotá: la administración 2005-2007, en la que asumiendo la imposibilidad de la objetividad y desde una perspectiva más interesada por la investigación, las miradas complementarias y la exploración de diversidad de enfoques y de construcción de los objetos evaluativos, se optó por evaluar el lenguaje desde dos enfoques diversos, empleando dos instrumentos diferentes y diseñando situaciones de evaluación igualmente distintas, proceso evaluativo que se denominó pruebas Comprender.

Uno de los enfoques se ocupó de evaluar la lectura. Según este enfoque, la función central del lenguaje es transformar la experiencia humana en sentido. Con la prueba se buscó indagar acerca de cómo leen los estudiantes las posibilidades de significación que brinda la lengua, según propósitos estructurales y contextos socioculturales. La prueba cuyo atributo evaluado resultó consistente, aunque informa sobre un nivel medio de desempeño permitió apreciar que los estudiantes bogotanos: a) diferencian entre propósitos incorporados en la lengua y finalidades aportadas por el contexto; b) reconocen las implicaciones pragmáticas que tiene el hecho de enunciar de cierta manera; y c) comprenden que la posición de los interlocutores en una situación comunicativa determina ciertos aspectos de la significación. En general, se observa que los estudiantes leen las posibilidades que brinda la lengua para comunicar las condiciones de la comunicación (hablantes e implicaciones pragmáticas), así como sus efectos (estados de cosas y órdenes de realidad).

El otro enfoque se ocupó de evaluar la producción escrita, para lo cual se construyó un instrumento y se diseñó una situación particular de evaluación, desde una perspectiva discursiva, recogiendo la experiencia de algunos procesos evaluativos adelantados en Colombia desde hace más de una década.

Esta exploración se inscribe directamente en la formulación de la política evaluativa oficial que regía para el periodo en mención:

Según esta concepción, se trataría más bien de interpretar, buscar las categorías en virtud de las cuales es construida, en la comunicación, la información socialmente relevante (o sea, vincular las significaciones con la complejidad social). No se puede renunciar a valorar la educación en toda su complejidad, y para ello es necesario no limitarse a una evaluación de productos, como si los sujetos se desarrollaran al margen de su inmersión en la vida social (Secretaría de Educación de Bogotá, 2005, p. 33).

Reconociendo la pertinencia de este encuadre de la política evaluativa, en el marco de las pruebas Comprender, desde el grupo de investigación Pedagogías de la Lectura y la Escritura, de la Pontificia Universidad Javeriana, decidimos participar entre los años 2005 y 2007 en la construcción y el análisis de los resultados de la prueba de evaluación de la producción escrita para los grados quinto y noveno.

A continuación se presentan algunos elementos relacionados con el proceso seguido para la definición de la situación de evaluación, del enfoque, las especificaciones y los componentes que conformaron la prueba, así como algunos de los resultados que se obtuvieron. Por razones de extensión, se desarrollará un poco más lo relacionado con el diseño de la situación de evaluación, pues este elemento constituye el aporte distintivo respecto a los procesos seguidos en el país en la historia reciente de la evaluación estatal, en la historia reciente de la evaluación masiva. Para ampliar información, se puede consultar el informe completo de resultados (Secretaría de Educación de Bogotá, 2007b).

Definición de la situación de evalución y el intrumento

Para la definición de la situación de evaluación, así como del instrumento, se tuvo en cuenta la participación de los integrantes del grupo de investigación y de grupos de maestros de la ciudad de Bogotá, representantes de las diferentes localidades, con el fin de diseñar la situación de evaluación, discutir y ajustar colectivamente el objeto de evaluación y determinar algunas de las características de la prueba, en función de las prácticas de enseñanza que tienen lugar en las aulas de la ciudad.

Este proceso se justificaba, entre otros aspectos, porque Colombia no cuenta con una prescripción detallada de lo esperable para los diferentes grados de la escolaridad. Se cuenta con lineamientos curriculares que son más la declaración de un enfoque o una perspectiva de trabajo pedagógico, didáctico y disciplinar que una directriz rígida, y con un documento de estándares curriculares que para el caso del lenguaje no señala contenidos concretos ni saberes hacer específicos para cada grado, pues su formulación es para los ciclos y no para los grados. Es por ello que la participación de los maestros en la construcción del objeto de evaluación y de algunos de los criterios de evaluación fue determinante, pues son ellos quienes conocen y pueden determinar lo realmente esperable de un estudiante que cursa los grados quinto o noveno en los que se realizaría la prueba.

Para concretar el proceso, se revisaron, analizaron y discutieron las experiencias anteriores de evaluación masiva, externa de la escritura adelantadas por el Icfes en Colombia, durante los últimos quince años (Pérez Abril, 2003a) y en otros países de América Latina (Jurado, 2009). Al respecto, se analizaron los enfoques disciplinares sobre el lenguaje, los referentes pedagógicos y didácticos, así como las características de los instrumentos de evaluación de la escritura. Igualmente, se analizaron las tendencias en la enseñanza y la evaluación de la producción escrita en las aulas, y se realizaron sondeos con los estudiantes y los docentes para explorar y definir los temas de interés para los grados que serían evaluados (quinto y noveno). En el sondeo realizado con 75 docentes, y sus correspondientes estudiantes, se identificó que en las aulas se trabaja desde un enfoque de escritura como proceso, en el que se privilegian escritos que partan de los intereses de los estudiantes y que se busca que los textos tengan un destinatario concreto.

Tras la discusión con grupos de maestros de la educación básica de la ciudad, en talleres quincenales realizados durante seis meses se diseñó la situación de evaluación, que consideramos constituye el elemento más valioso del proceso, en la medida que marcó una diferencia respecto a las evaluaciones masivas adelantadas en el país. También se determinó que, en cuanto al objeto de evaluación, se atendería a elementos relacionados con el dominio textual (conexión, cohesión, puntuación, progresión temática, ortografía), del dominio discursivo (tipo textual, intencionalidad y léxico) y de la práctica sociocultural, estos elementos son cercanos a las categorías definidas para la evaluación en el país.

La evaluación, para la prueba que nos ocupa, consistió en la escritura de un texto de tipo narrativo, para el grado quinto, y argumentativo para el grado noveno, enmarcado en una actividad sociocultural real, como lo es un concurso de cuentos y ensayos para un periódico distrital. El escrito atendió a un tema determinado: para el caso del grado quinto, se solicitó la escritura de un texto sobre el mundo de los animales (2005) y los viajes espaciales (2007); para el caso de grado noveno el tema fue adolescencia, salud y medios de comunicación (2005) y la tecnología y el hombre (2007). Algo similar se hizo, en otro contexto, en las pruebas masivas y externas de la Provincia de Buenos Aires desde 1996 (Jurado, 2009), y en las pruebas del Serce, en el 2005 (pilotaje) y el 2006 (aplicación).

Sobre la situación de evaluación: generar condiciones para el éxito en vez de buscar el déficit

La tradición de la evaluación masiva en Colombia se ha caracterizado por diseñar situaciones de evaluación en las cuales no se explicitan las reglas con anterioridad, ni a los docentes ni a los estudiantes. La evaluación que se realizó con las pruebas Comprender buscó poner en tensión esa tradición. En este sentido se propuso una evaluación que declaró y explicitó, con dos meses de anterioridad al momento de la aplicación y de manera clara, lo que se esperaba que los estudiantes hicieran con la lengua escrita. Esta ex- plicitación, tanto del objeto como del instrumento y los parámetros de evaluación, se realizó a través de una guía de prueba y una cartilla (Secretaría de Educación de Bogotá, 2007c). Por su parte, cabe aclarar que el objeto, así como el instrumento de evaluación, si bien se basan en experiencias previas de evaluaciones masivas de producción de textos realizadas en el país, fueron discutidos y ajustados con los docentes de la ciudad, en tensión con el marco de las políticas curriculares y evaluativas y en relación con la discusión internacional al respecto (Icfes, 2007).

Otra característica de esta situación de evaluación consistió en entregar a los estudiantes apoyos e infraestructuras básicos: además de la antología de textos sobre el tema, entregada con anterioridad, los estudiantes podían llevar a la evaluación notas sobre la temática, diccionarios, manuales de redacción y otras fuentes relacionadas con el tema sobre el que versaría la prueba nótese que con estos elementos se trata de producir condiciones para el éxito y no para el fracaso de los evaluados. Interesa explorar hasta dónde pueden llegar los estudiantes si se construyen unas condiciones básicas que soporten el proceso de escritura. Esta idea parte del supuesto de que si el estudiante cuenta con una situación que construye y aporta las condiciones necesarias para hacer lo que la evaluación le pide, su desempeño podrá será exitoso. De este modo, la prueba mediría hasta dónde puede llegar el estudiante, si se garantizan ciertas condiciones. Sin embargo, es claro que la existencia de estas condiciones no es suficiente para equilibrar las desigualdades de los estudiantes frente a la cultura escrita, pero sí genera condiciones más respetuosas frente a esa inequidad.

Así, este enfoque de la evaluación, especialmente en lo relacionado con el diseño de la situación de evaluación, se distancia de la búsqueda del déficit del aprendizaje y nos acerca a una evaluación que genera condiciones para la producción de textos. Por lo anterior, como se señaló, a los estudiantes y a los docentes se les informó, por escrito y de manera detallada, cuál era el objeto de evaluación, qué se esperaba de los estudiantes en dicha prueba y cuáles eran los criterios, así como las categorías y escalas desde las cuales se evaluarían los escritos. Este enfoque puede verse como laconstrucción de un“contratoevaluativo”explícitoentre el evaluador y el evaluado. Dicho contrato quedó plasmado en el documento guía de fundamentación de la prueba, y en los otros complementarios que se entregaron a docentes y, a través de ellos a los estudiantes, con anterioridad a la prueba. Existen experiencias previas de explicitación de estos elementos, por ejemplo en el sistema de evaluación argentino.

Además, con el fin de garantizar que los estudiantes evaluados, en independencia de su ubicación en una localidad o estrato específico, y en independencia de su recorrido educativo, contaran con la información básica sobre el tema que sería objeto de escritura, se entregó a los docentes y estudiantes de la ciudad, con algunas semanas de anticipación, una cartilla, una antología con textos referentes a los temas de evaluación. Igualmente, se invitó a los docentes a complementar, con otras fuentes, la aproximación de los estudiantes a la temática. Con lo anterior se logró que los estudiantes, junto con los docentes, leyeran y analizaran los textos de esas cartillas con el fin de tener una base de información que posibilitara contar con condiciones para la escritura (producción) del texto que les fue solicitado, a partir de una petición particular realizada el día de la prueba. Por otra parte, los estudiantes pudieron consultar información complementaria sobre el tema en otras fuentes. Si bien estos elementos no suplen las diferencias generadas por las condiciones socioculturales y por las diferencias de acceso a la información, por parte de los estudiantes, sí construye una situación mucho más favorable para la escritura que una situación prototípica de evaluación en la que estos elementos están ausentes.

De este modo, el estudiante podía usar durante la evaluación la información de la cartilla u otra información que considerara pertinente. El sentido de estos textos fue únicamente garantizar que los estudiantes llegaran a la prueba con suficiente información sobre el tema del cual se les pediría escribir, pues es importante señalar que no se evaluaba la comprensión de los textos de las cartillas, por tratarse de una prueba de producción textual y no de comprensión lectora.

Por otro lado, el día de la evaluación el estudiante tuvo la posibilidad de preparar un borrador del texto, antes de escribir la versión definitiva. Este elemento, nuevo en la evaluación de la producción escrita en Colombia, se ajusta a la idea de la escritura como proceso y no como producto (Secretaría de Educación de Bogotá, 2007a).

Es claro que la escritura implica sucesivas reescrituras, que la evaluación masiva no puede abordar, mientras en el trabajo de aula sí es posible, incluso imprescindible. Pero consideramos que en la evaluación masiva, si el estudiante puede al menos escribir dos veces su texto estará, en tanto escritor, en mejores condiciones que si se le pide una única escritura. Si a esto se agrega el contar con información suficiente sobre el tema objeto del escrito y sobre los parámetros desde los cuales será evaluado su texto, tendremos en realidad algunas condiciones mínimas para la producción del escrito.

Dado que la reescritura implica usar herramientas (preparar un borrador, tachar, corregir, usar diccionarios, manuales de gramática, etcétera), en esta evaluación los estudiantes pudieron hacer uso de ellas; de hecho se les pidió llevarlas y se solicitó a los docentes disponer de esas herramientas el día de la evaluación, en los contextos en los que los estudiantes no contaran con ellas, puesto que la escritura, en tanto proceso, supone su uso. Al fin y al cabo, lo que interesa en este tipo de evaluación no es el dominio memorístico de reglas ortográficas o gramaticales, sino la posibilidad de producir una unidad de significado y de sentido: un todo coherente que cumpla con condiciones textuales y discursivas pertinentes y que se sitúe en una práctica social concreta (la escritura de un texto para su publicación en un periódico distrital).

Como puede notarse, la lógica que está detrás de este enfoque de evaluación se refiere más a la posibilidad de producir enunciados propios ordenados en una estructura y cumpliendo una función discursiva, que a indagar el dominio de la normativa lingüística. La posibilidad de disponer de diccionarios y manuales de gramática se relaciona con el hecho de que el estudiante, en caso de requerir un soporte pudiera contar con él, con el propósito de revisar su texto, una vez éste hubiese sido producido. Por supuesto que el dominio de aspectos formales de la escritura fue objeto de esta evaluación, pero no fue el objeto privilegiado, pues se trata de una evaluación de la producción escrita en el sentido global del término y no de una evaluación de la prescripción lingüística. En otras palabras, consideramos que el dominio de las regularidades de la lengua, de sus reglas de funcionamiento, es soporte de la producción del escrito y debe ser evaluado como tal, pero no es el fin último, ni de la enseñanza de la lengua, ni de la escritura como práctica, ni de la evaluación. Como se observa, se está frente a una situación de evaluación más cercana del proceso que vive un sujeto que enfrenta la escritura de un texto auténtico, que de la evaluación típica del examen.

Como era de esperarse, los resultados evidenciaron el efecto de estas condiciones, pues los estudiantes produjeron textos, por ejemplo, de mayor extensión y con características textuales y discursivas que, si bien manifiestan dificultades, resultaron más consistentes que en evaluaciones anteriores (Pérez Abril, 2003b), aunque es imposible soportar esta afirmación en un estudio comparativo, pues ni los instrumentos, ni las poblaciones, ni las situaciones de evaluación son comparables. En términos de la difusión de los resultados a través de los medios, es claro que desde los resultados arrojados por esta prueba no se derivaron los típicos titulares de prensa a que estamos acostumbrados en nuestro país, del corte “Se rajaron los estudiantes”o “La escuela no está haciendo la tarea”. Esto nos indica que la situación de evaluación y las condiciones que se generan para ésta tienen un efecto en los modos de escribir de los estudiantes que, a su vez, inciden en la difusión y uso de los resultados y, por supuesto, en la valoración de la labor de los docentes.

Desde esta exploración queda claro que el enfoque que se decide, así como el tipo de situación que se diseña, inciden en los resultados que se obtienen. Así las cosas, podríamos afirmar que, en gran medida, el déficit que suele hallarse en los resultados de los exámenes es, en cierto modo, un efecto de la prueba misma y de los supuestos que le subyacen. Veamos a continuación, de manera breve, algunos elementos teóricos desde los cuales se definió el objeto y el instrumento de evaluación.

La noción de cultura escrita

Las pruebas diseñadas parten de la base que escribir significa producir ideas genuinas y configurarlas en un texto que obedece a unas reglas sociales de circulación: se escribe para alguien, con un propósito, en una situación particular en atención de la cual se construye un interlocutor y se selecciona un tipo de texto pertinente a la situación de enunciación.

Ya nos mostró Bajtin (1998), que desde el momento en que aparecemos en el mundo, nos vinculamos a prácticas culturales al interior del grupo social o los grupos a los que pertenecemos. En esas prácticas, circulan textos que son usados con funciones específicas y se organizan en formas discursivas más o menos estables. La existencia de esos modos del discurso se relacionan directamente con los modos de pensar, de valorar que las culturas han decantado, a través de ellos conocemos explicaciones, visiones del mundo; llenamos el mundo de significados y sentidos.

Por lo anterior, la lectura y la escritura son, ante todo, prácticas sociales y culturales (Chartier, 1995; Rockwell, 1995) que están ligadas a la tradición de un grupo social; se puede afirmar que los factores socioculturales determinan las formas de los textos, así como sus condiciones de producción, recepción y circulación (Verón, 2005). Al producir un texto, debemos anticipar elementos como el interlocutor o auditorio al que éste se dirige, el tipo de léxico, la forma textual y discursiva pertinente a la situación de enunciación. Se escribe para que pase algo en el mundo. Desde este enfoque de enseñanza de la escritura, la apropiación del sistema de la lengua deja de ser un fin en sí mismo, para convertirse en una condición para la participación y comprensión de una práctica social determinada, perspectiva que no puede obviarse en el momento de evaluar o pedir cuentas del uso que los estudiantes hacen del lenguaje escrito.

Estos elementos constituyen, en parte, lo que se suele nombrar como cultura escrita. Por cultura escrita nos referimos, pues, al acervo de textos, sus estructuras y funciones, así como a los sistemas de escritura, alfabéticos y no alfabéticos, producidos en la historia de las culturas, que han permitido registrar la vida, plasmar las grandes creaciones estéticas y literarias en diferentes tipos de soportes, desde el papiro, las láminas de metales procesados, las tablillas de arcilla, los petroglifos y el papel, hasta las formas digitales, y también ha permitido registrar las grandes injurias y vergüenzas de la humanidad, para guardar una memoria. La existencia de esa posibilidad de registrar en textos ha ganado un lugar central en las prácticas sociales; así, hoy es muy difícil imaginar una sociedad en la que no circulen, no se escriban, no se comenten ni se lean textos.

El concepto de cultura escrita alude simultáneamente a dos fenómenos claramente distinguibles y, sin embargo, íntimamente vinculados. Por un lado, se refiere a la cultura que se escribe: desde las grandes obras literarias y tratados científicos en los que se resguarda la experiencia humana y su conocimiento acumulado, hasta los textos legales y administrativos que cristalizan las relaciones sociales y políticas y, por lo mismo, sirven de doctrina para gobernar la vida en sociedad. Incluye incluso los usos fugaces de la escritura: mensajes, listas, notas, letreros y avisos, entre otros. Por otro lado, cultura escrita alude a la cultura que surge al usar la escritura; las prácticas, usos y convenciones de la palabra escrita enraízan en contextos específicos, relaciones de poder y la vida comunitaria de las personas. En este sentido, la noción de cultura escrita agrupa tanto los textos como sus dimensiones históricas, sus contextos de uso, sus formas y, sobre todo, la ubicación de la escritura en cuanto uso de lenguaje en un tejido social (Kalman, 2000, p. 153). Este concepto de cultura escrita constituyó el marco conceptual general para la construcción de la prueba.

Perspectiva sobre el lenguaje y la escritura

La perspectiva que se esboza no es una idea novedosa: consiste en partir de la concepción de lectura y escritura como prácticas culturales para desde allí reflexionar sobre las condiciones pedagógicas y didácticas de la escuela, de cara a pensar elementos que aporten a la definición de un enfoque para la evaluación, tanto masiva como de aula.Teóricamente y desde la investigación, esta perspectiva se revela como una idea consistente y muy potente, aunque, al menos en nuestro país, aún no ha tocado, de manera clara, las prácticas educativas ni las prácticas evaluativas de carácter masivo, tal vez por tratarse de un desarrollo teórico relativamente reciente y por las dificultades de orden técnico que esta opción supone para una evaluación de tipo masivo.

Desde los planteamientos anteriormente expuestos es lógico postular como fin de la enseñanza y, por tanto, como objeto de la evaluación en el campo del lenguaje, la inserción crítica (con criterio) de los sujetos en la cultura escrita y en prácticas socioculturales concretas en las que la escritura es un elemento nuclear, de tal modo que el dominio de los géneros discursivos sea una condición para dicha inserción. Esta orientación de la pedagogía del lenguaje le imprime un carácter político y social a la evaluación, que va más allá de la dimensión técnica, lingüística y normativa, como preocupaciones centrales de la enseñanza.

Por otro lado, debemos decir que la selección de esta perspectiva obedece también al amplio recorrido que esta corriente ha desarrollado en el campo de la didáctica del discurso, la argumentación y la escritura en Colombia y en la región, y a la concordancia que muestra con el enfoque planteado por los lineamientos curriculares actuales que rigen la educación en nuestro país. A su vez, es la base de muchas de las innovaciones y prácticas pedagógicas relevantes en nuestro contexto, en América Latina y en Europa.

¿Por qué evaluar la escritura?: el lugar de la escritura en la vida social y académica

Como se señaló anteriormente, la escritura es un código cultural. Ser usuario de éste permite vincularse a cierto tipo de interacciones sociales y académicas fundamentales, y no dominarlo significa, en parte, estar excluido no sólo de la cultura escrita, sino de ciertas prácticas sociales y culturales. Esto hace que la escritura tome un lugar privilegiado en la agenda educativa de un país y, por ende, en las evaluaciones que este desarrolla.

Por otro lado, la escritura está ligada al desarrollo cognitivo y permite la organización del pensamiento propio, en la medida que se trata de una actividad reflexiva de alta complejidad. Escribir posibilita tomar distancia de nuestro propio pensamiento, reflexionar sobre el sentido de las ideas y la organización que hacemos de estas. Por eso, cotidianamente se habla de la escritura como la posibilidad de “poner en blanco y negro el pensamiento”. Definitivamente, al escribir terminamos de aprender en la medida que el texto exige producir una estructura que ordene los pensamientos propios, las comprensiones que se tienen sobre algún asunto.

Adicionalmente, la escritura es una condición necesaria para el desempeño en la educación superior y en los ámbitos laboral y profesional. Por tal razón, la formación académica en la educación básica debe pasar, necesariamente, por el fortalecimiento de la escritura, ya que la vida académica, profesional y laboral están mediadas por ésta: la universidad es, de modo dominante, un escenario de lectura y escritura.

En este marco general, para la definición del objeto de evaluación abordamos la distinción entre texto: secuencia textual (Adam, 1999), discurso: actividad discursiva, pertenencia a un género, planteada por Bronckart (1996) y Adam (2001), y práctica sociocultural, planteada por Bajtin (1998). Esta triple distinción está asociada a discriminar entre: a) mecanismos de textualización (análisis textual); b) mecanismos de puesta en discurso (orientación a un auditorio, selección de un tipo de léxico en función del interlocutor, etcétera); y c) ubicación de la escritura en una práctica social (el mundo del periodismo escrito, el campo jurídico, el ámbito académico, el universo científico o literario, etcétera). Como puede verse, la distinción resulta clave para pensar los alcances y el objeto de la evaluación. También resulta central para repensar la organización y el sentido del trabajo pedagógico y didáctico en el campo del lenguaje en la educación básica.

Si consideramos que el discurso y la actividad discursiva constituyen la unidad de trabajo pedagógico y didáctico, como se señaló anteriormente, dicha unidad debe ser retomada para efectos de la evaluación. Es decir, la unidad de análisis en la evaluación, sea masiva o de aula, desde la perspectiva expuesta, será la práctica discursiva. Lo anterior implica que el texto que se pide producir al estudiante corresponde a un género discursivo particular y se inscribe en una práctica social concreta. Este enfoque, tal como se indicó, supone que el texto solicitado en la evaluación cumple con una finalidad discursiva, se orienta a un interlocutor o auditorio real o potencial, configurado por la prueba, y toma una forma discursiva específica (un género). Por otro lado, se trata de un enfoque procesual de la escritura, en el sentido de considerar que producir un texto supone momentos de preparación, escritura de borradores, revisiones, etcétera.

Aspectos que componen la estructura de la prueba

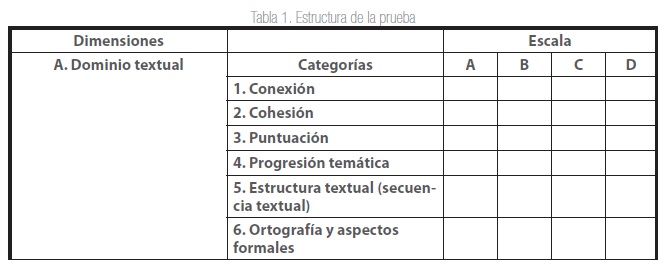

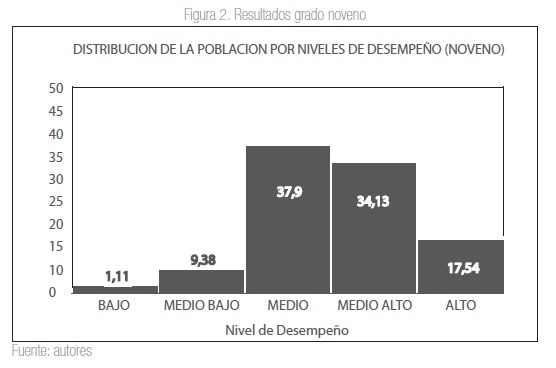

Con base en el objeto de evaluación definido, se estableció la siguiente estructura de prueba (tabla

1) compuesta de tres dimensiones (dominio textual [A], dominio discursivo [B] y práctica sociocultural [C]), cada una de las cuales se evaluó a través de unas categorías. Cada categoría se evalúa siguiendo una escala cualitativa, definida teniendo en cuenta ciertos criterios y condiciones. Como puede notarse, la estructura de evaluación en las dimensiones A, B y C es la misma para los grados quinto y noveno, diferenciándose en la categoría correspondiente al tipo textual demandado por la prueba, la cual hace parte del dominio discursivo: B1: narración para el grado quinto y B2: argumentación para el grado noveno.

A continuación se presenta la estructura de la prueba. La explicación de las categorías se puede consultar en el informe de resultados (Secretaría de Educación de Bogotá, 2007b).

Sobre el procesamiento de los resultados

Es preciso aclarar que, una vez definida y diseñada la prueba, ésta fue sometida a un proceso de pilotaje, en función del cual se realizaron ajustes a los tiempos de aplicación, las características de los enunciados y las escalas de evaluación. Lo anterior posibilitó contar con una noción más real de las características de los textos que producían los estudiantes de estos grados, lo cual permitió la preparación de un grupo de evaluadores, que fueron quienes realizaron la mirada final sobre los textos y evaluaron las tendencias en los escritos de los estudiantes de la ciudad de Bogotá.

Con base en las categorías anteriormente mencionadas, y utilizando algunos de los textos producidos por los estudiantes en el pilotaje, se procedió a preparar el grupo de evaluadores. Para ello se realizaron continuos talleres en los que se definieron y ajustaron los criterios (dimensiones, categorías, escalas), buscando así una mirada más homogénea de parte de todo el grupo. Además, para asegurar en lo posible esta homogeneidad, se realizó un trabajo de “cotejo” de evaluadores en el que mediante una secuencia ordenada el 10% de los textos de cada calificador era revisado y calificado por otro. De esta forma se obtuvo doble calificación de algunos textos, la cual al ser analizada estadísticamente, siguiendo un modelo estadístico de teoría de respuesta al ítem (modelo Rash), arrojaba los índices de fiabilidad en la calificación de cada persona y ajustaba sus calificaciones en relación con las del grupo. El ajuste de estos criterios requirió de varias sesiones de trabajo conjunto para la discusión de las razones para otorgar una u otra escala a los desempeños de los estudiantes en la prueba.

Una vez recibidos los textos de la evaluación final, aplicada a los estudiantes de la ciudad, se procedió a realizar su calificación, utilizando la rejilla de categorías presentada anteriormente. Dichas rejillas fueron leídas y enviadas a una base de datos que posteriormente se procesó con la ayuda del software SPSS.

Inicialmente se realizó un conteo de frecuencias, observando la cantidad de estudiantes que se encontraban en cadaniveldelaescalaparacadaunadelascategorías y, posteriormente, se realizó una ponderación (asignación de valor a cada nivel de la escala), con el propósito de obtener resultados generales para la ciudad y para establecer correlaciones (esta correlación se observó a partir de los resultados de la prueba estadística de varianza Anova) con algunas variables de orden social y cultural (tanto del estudiante como de la institución) que fueron indagadas, para realizar una lectura de los resultados desde los contextos particulares.

Ambos procesamientos, de orden descriptivo (frecuencias y medias) y analítico (Anova y Rasch), enriquecieron el análisis de los resultados, pues permitieron tener un panorama general del estado de la escritura de los estudiantes de estos grados, a la vez que facilitaron la visualización de algunos de los factores que tenían incidencia en que dichos resultados se dieran de una manera u otra.

Algunos resultados

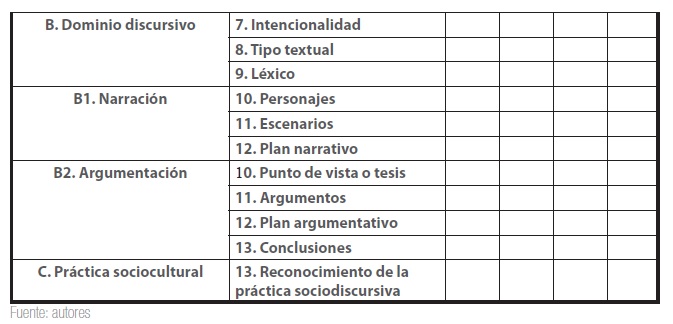

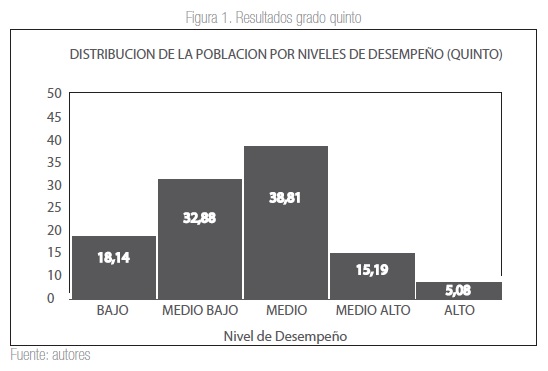

Aunque la prueba Comprender fue aplicada en los años 2005 y 2007, a continuación presentaremos los resultados correspondientes al 2007, por ser el más reciente.

La prueba fue aplicada a 8.409 estudiantes pertenecientes a instituciones oficiales y no oficiales de la ciudad de Bogotá, escogidas al azar a partir de las bases de datos de la Secretaría de educación de Bogotá. El 40% de estos estudiantes pertenecían al grado quinto y el 60% al grado noveno.

En general se pudo observar (figuras 1 y 2) que el desempeño de la población alcanzó los niveles básicos esperados para la prueba de lenguaje escrito (más del 80% de los estudiantes del grado noveno y del 50% del grado quinto se ubican por encima del nivel medio), lo que parece indicar que el trabajo de la escritura enmarcado en prácticas con sentido para los estudiantes (la publicación del escrito para que alguien lo lea), facilita el logro de los objetivos y la construcción de mejores textos. Estos resultados contrastan con aquellos hallados en evaluaciones anteriores, tal como se han analizado por parte del Icfes (2003).

Se observó que la población está en capacidad de hacer uso de los recursos de conexión, cohesión, puntuación, ortografía y demás, generalmente a nivel intrafrásico e interfrásico, pero se le dificulta el trabajo de dichos recursos en apartados más globales como párrafos o en el nivel del texto. En tanto discurso, la mayoría de los estudiantes reconocen la intencionalidad y el tipo textual demandado por la práctica e intentan configurar sus escritos en función del auditorio propuesto.

Para el grado quinto, por ejemplo, en cuanto a práctica sociocultural, se observó que los estudiantes conocen que un texto narrativo se conforma de personajes, escenarios y se construye en función de un plan narrativo, pero no saben cómo caracterizar o desarrollar de manera suficiente estos elementos. En tanto que para el grado noveno, aunque los estudiantes reconocían que un texto argumentativo exige el planteamiento de un punto de vista y unos argumentos que se relacionan entre sí, se les dificulta organizar la información de acuerdo a un plan y generar conclusiones acordes con sus planteamientos.

Breve discusión de los resultados

Si bien no es posible establecer comparaciones rigurosas con las evaluaciones masivas, externas, adelantadas en la ciudad con anterioridad, estos resultados no permitirían realizar afirmaciones tan fuertes como las difundidas en los medios de comunicación en los procesos anteriores, relacionados con que los estudiantes, la escuela o el docente se “rajaron”, “no aprobaron”. Al contrario, si bien hay muchos aspectos por mejorar, los resultados arrojados por esta prueba son más positivos que los observados en otras pruebas masivas que señalan la escritura como un campo débil en nuestro país (Icfes, 2007). Ello nos ha llevado a pensar que este tipo de evaluación ha permitido evidenciar que si se generan las condiciones mínimas para que los estudiantes produzcan textos, los resultados pueden mejorar. Nos referimos a condiciones como anticipar las reglas de la evaluación frente a los docentes y los estudiantes, y brindar a los estudiantes la información y recursos que necesitan para la escritura de un texto.

La óptima respuesta en relación con la identificación de la temática y el trabajo sobre esta, también nos permite pensar que la antología de textos entregada a los estudiantes para la evaluación disminuyó un tanto la inequidad en relación con el capital cultural de estos, permitiéndoles tener cierta claridad en la temática a desarrollar en sus escritos. Además las notas, los resúmenes y demás información que podían llevar el día de la evaluación, equiparaba las condiciones de escritura a las que usualmente nos enfrentamos: nadie nos esconde el manual de dudas e incorrecciones de la lengua, tenemos la posibilidad de consultar fuentes, etcétera.

Como se señaló con anterioridad, y como se puede leer desde los resultados obtenidos, esta evaluación, y en general esta política evaluativa, toma distancia del enfoque deficitario dominante, desde el cual se diseña una evaluación para identificar lo que los estudiantes no saben y lo que no saben hacer. Si invertimos la in- tencionalidad y buscamos reconocer hasta dónde pueden llegar los estudiantes, dadas ciertas condiciones mínimas, el asunto cambia. Y por supuesto produce efectos distintos. Pero, tal vez, lo más relevante es que envía un mensaje pedagógico fuerte a las instituciones escolares, relacionado con preguntar desde el centro de la cultura escolar: ¿cuál es el enfoque evaluativo que circula en las aulas, qué sentido tiene y qué efectos produce?, ¿cómo se está concibiendo la escritura y, por ende, como se está evaluando?

Los estudiantes produjeron textos aceptables, aunque, como se anotó, sigan existiendo ciertas debilidades. Esto indica que el enfoque desde el que se evalúa produce, de algún modo, el tipo de resultados que se obtienen. En otras palabras, las decisiones de política educativa, en este caso de política de evaluación, prefiguran los resultados.

Reconocimiento

El artículo presenta una investigación sobre los resultados de las pruebas“Comprender”(2005 -2007), enmarcada en el proyecto “Currículo y Evaluación” adelantado por la Secretaría de Educación de Bogotá y el Instituto para la Investigación Educativa y el Desarrollo Pedagógico Idep, que hace parte de la consolidación del sistema integral de evaluación de Bogotá

Referencias

Adam, J. M. (2001). Les textes, types et prototypes. Paris: Nathan.

(1999). Linguistique textuelle. Paris: Nathan.

Bajtin, M. (1998). Estética de la creación verbal. México: Siglo XXI.

Bronckart, J. P. (1996). Activité Langagiere, Textes et Discours. Paris: Niestle.

Bustamante, G. & Pérez Abril, M. (1996). Evaluación escolar, resultados o procesos. Bogotá: Magisterio.

Chartier, R. (1995). El orden de los libros. Barcelona: Gedisa.

Icfes (2007). Sobre las pruebas Saber y de Estado: una mirada a su fundamentación y orientación de los instrumentos en lenguaje. Bogotá: Icfes.

Jurado, F. (2009). Los sistemas nacionales de evaluación en América Latina: ¿Impacto pedagógico u obediencia institucional? Bogotá: Editorial Universidad Nacional de Colombia.

Kalman, J. (2000). Ya sabe usted, es un papel muy importante: el conocimiento de la lengua escrita en mujeres de baja o nula escolaridad. México: Colección Pedagógica Universitaria. Nº 32-33. Edición de 25 Aniversario. Recuperado de http://www.uv.mx/cpue/coleccion/N_32_33/Ya_sabe_usted.html

Murillo Torrecilla, F. J. (2008). Los modelos multinivel como herramienta para la investigación educativa. Magis, Revista Internacional de Investigación en Educación, 1(1): 45-62.

Pérez Abril, M. (2003a). Leer y escribir en la escuela. Algunos escenarios pedagógicos y didácticos para la reflexión. Bogotá: Icfes.

(2003b). Evaluar para transformar aportes de las pruebas Saber al trabajo en el aula. Una mirada a los fundamentos e instrumentos de lenguaje 2002-2003. Bogotá: Icfes.

Perrenoud, P. (2008). La evaluación de los alumnos. De la producción de la excelencia a la regulación de los aprendizajes. Entre dos lógicas. Buenos Aires: Colihue.

Rockwell, E. (1995). La escuela cotidiana. México: Fondo de Cultura Económica.

Secretaría de Educación de Bogotá (2005). Lineamientos de evaluación para Bogotá. Bogotá: Secretaría de Educación de Bogotá.

(2007a). Las evaluaciones externas y la evaluación de aula en lenguaje. Bogotá: Alcaldia Mayor de Bogotá.

(2007b). Resultado de la pruebas Comprender de lenguaje. Primera aplicación. Grados quinto y noveno. Análisis comprensivo y pedagógico. Bogotá: Secretaría de Educación de Bogotá.

(2007c). Serie Cuadernos de Evaluación. Pruebas Comprender de lenguaje. Evaluación de la comprensión y el aprendizaje. Grados 5° y 9°. Guía de orientación para profesores. Bogotá: Secretaría de Educación Distrital y Alcaldía Mayor de Bogotá. Recuperado de http://www.sedbogota.edu.co/AplicativosSED/Centro_Documentacion/anexos/publicaciones_2004_2008/ guias_eval_lenguaje_5_9.pdf

Verón, E. (2005). Fragmentos de un tejido. Barcelona: Gedisa.

Licencia

La revista Enunciación es una publicación de acceso abierto, sin cargos económicos para autores ni lectores. A partir del 1 de enero de 2021 los contenidos de la revista se publican bajo los términos de la Licencia Creative Commons Atribución – No comercial – Compartir igual (CC-BY-NC-SA 4.0 CO), bajo la cual otros podrán distribuir, remezclar, retocar, y crear a partir de la obra de modo no comercial, siempre y cuando den crédito y licencien sus nuevas creaciones bajo las mismas condiciones.

El titular de los derechos de autor es la revista Enunciación, conservando todos los derechos sin restricciones, respetando los términos de la licencia en cuanto a la consulta, descarga y distribución del material.

Cuando la obra o alguno de sus elementos se hallen en el dominio público según la ley vigente aplicable, esta situación no quedará afectada por la licencia.

Asimismo, incentivamos a los autores a depositar sus contribuciones en otros repositorios institucionales y temáticos, con la certeza de que la cultura y el conocimiento es un bien de todos y para todos.