DOI:

https://doi.org/10.14483/23448393.18543Published:

2022-11-20Issue:

Vol. 28 No. 1 (2023): January-AprilSection:

Systems EngineeringPrototipo de exploración educativa basada en realidad mixta para cirugía con casco Meta 2

Educational Exploration Prototype Based on Mixed Reality for Surgery with a Meta 2 Headset

Keywords:

realidad aumentada, realidad mixta, casco Meta 2, exploración quirúrgica (es).Keywords:

Augmented reality, mixed reality, Meta 2 headset, surgical exploration (en).Downloads

References

S. Abou El-Seoud, A. Mady, and E. Rashed, “An interactive mixed reality ray tracing rendering mobile application of medical data in minimally invasive surgeries”, Int. J. Interact. Mob. Technol.

(iJIM), vol. 13, no. 3, pp. 29-39, 2019. https://doi.org/10.3991/ijim.v13i03.9893 DOI: https://doi.org/10.3991/ijim.v13i03.9893

P. R. Armijo, C.-K. Huang, R. High, M. Leon, K.-C. Siu, and D. Oleynikov, “Ergonomics of minimally invasive surgery: An analysis of muscle effort and fatigue in the operating room between laparoscopic and robotic surgery”, Surg. Endosc, vol. 33, no. 7, pp. 2323-2331, 2019. DOI: https://doi.org/10.1007/s00464-018-6515-3

E. Azimi, R. Liu, C. Molina, J. Huang, and P. Kazanzides, “Interactive navigation system in mixedreality for neurosurgery”, 2020 IEEE Conference on Virtual Reality and 3D User Interfaces Abstracts and Workshops (VRW), pp. 782-783, 2020. https://doi.org/10.1109/VRW50115.2020.00242 DOI: https://doi.org/10.1109/VRW50115.2020.00242

H. Brun, R. A. B. Bugge, L. K. R. Suther, S. Birkeland, R. Kumar, E. Pelanis, and O. J. Elle, “Mixed reality holograms for heart surgery planning: First user experience in congenital heart disease”, Eur. Heart J. Cardiovasc. Imaging, vol. 20, no. 8, pp. 883-888, 2019. https://doi.org/10.1093/ehjci/jey184 DOI: https://doi.org/10.1093/ehjci/jey184

G. Caccianiga, A. Mariani, E. De Momi, G. Cantarero, and J. D. Brown, “An evaluation of inanimate and virtual reality training for psychomotor skill development in robot-assisted minimally invasive surgery”, IEEE Trans. Med. Robot. Bionics, vol. 2, no. 2, pp. 118-129, 2020. https://doi.org/10.1109/TMRB.2020.2990692 DOI: https://doi.org/10.1109/TMRB.2020.2990692

J. Cartucho, D. Shapira, H. Ashrafian, and S. Giannarou, “Multimodal mixed reality visualisation for intraoperative surgical guidance”, Inter. J. Comput. Assist. Radiol. Surge, vol. 15, no. 5, pp. 819-826, 2020. https://doi.org/10.1007/s11548-020-02165-4 DOI: https://doi.org/10.1007/s11548-020-02165-4

B. Fiani, F. De Stefano, A. Kondilis, C. Covarrubias, L. Reier, and K. Sarhadi, “Virtual reality in neurosurgery: “Can you see it?” - A review of the current applications and future potential”, World Neurosurg, vol. 141, pp. 291-298, 2020. https://doi.org/10.1016/j.wneu.2020.06.066 DOI: https://doi.org/10.1016/j.wneu.2020.06.066

Y. Georgiou, and E. A. Kyza, “The development and validation of the ARI questionnaire: An instrument for measuring immersion in location-based augmented reality settings”, Int. J. Hum. Comput. Studies, vol. 98, pp. 24-37, 2017. https://doi.org/10.1016/j.ijhcs.2016.09.014 DOI: https://doi.org/10.1016/j.ijhcs.2016.09.014

K. D. Gray, J. G. Burshtein, L. Obeid, M. D. Moore, G. Dakin, A. Pomp, and C. Afaneh, “Laparoscopic appendectomy: Minimally invasive surgery training improves outcomes in basic laparoscopic procedures”, World J. Surg, vol. 42, no. 6, pp. 1706-1713, 2018. https://doi.org/10.1007/s00268-017-4374-z DOI: https://doi.org/10.1007/s00268-017-4374-z

H. G. Guedes, Z. M. Câmara Costa Ferreira, L. Ribeiro de Sousa Leão, E. F. Souza Montero, J. P. Otoch, and E. L. de Almeida Artifon, “Virtual reality simulator versus box-trainer to teach minimally invasive procedures: A meta-analysis”, Int. J. Surg, vol. 61, pp. 60-68, 2019. https://doi.org/10.1016/j.ijsu.2018.12.001 DOI: https://doi.org/10.1016/j.ijsu.2018.12.001

B. Hoppenstedt et al. “Applicability of immersive analytics in mixed reality: Usability study”, IEEE Access, vol. 7, pp. 71921-71932, 2019. https://doi.org/10.1109/ACCESS.2019.2919162 DOI: https://doi.org/10.1109/ACCESS.2019.2919162

H.-Z. Hu, X.-B. Feng, Z.-W. Shao, M. Xie, S. Xu, X.-H. Wu, and Z.-W. Ye, “Application and prospect of mixed reality technology in medical field”, Curr. Med. Sci, vol. 39, no. 1, pp. 1-6, 2019. https://doi.org/10.1007/s11596-019-1992-8 DOI: https://doi.org/10.1007/s11596-019-1992-8

F. Incekara, M. Smits, C. Dirven, and A. Vincent, “Clinical feasibility of a wearable mixedreality device in neurosurgery”, World Neurosurg, vol. 118, pp. e422-e427, 2018. https://doi.org/10.1016/j.wneu.2018.06.208 DOI: https://doi.org/10.1016/j.wneu.2018.06.208

A. Javaux, D. Bouget, C. Gruijthuijsen, D. Stoyanov, T. Vercauteren, S. Ourselin, J. Deprest, K. Denis, and E. Vander Poorten, “A mixed-reality surgical trainer with comprehensive sensing for fetal laser minimally invasive surgery”, Int. J. Comput. Assist. Radiol. Surg, vol. 13, pp. 1949-1957, 2018. https://doi.org/10.1007/s11548-018-1822-7 DOI: https://doi.org/10.1007/s11548-018-1822-7

T. Koike et al., “Development of innovative neurosurgical operation support method using mixed-reality computer graphics”, World Neurosurg, X, vol. 11, 2021. https://doi.org/10.1016/j.wnsx.2021.100102 DOI: https://doi.org/10.1016/j.wnsx.2021.100102

A. J Lungu, W. Swinkels, L. Claesen, P. Tu, J. Egger, and X. Chen, “A review on the applications of virtual reality, augmented reality and mixed reality in surgical simulation: An extension to different kinds of surgery”, Expert Rev. Med. Devices, vol. 18, no. 1, pp. 47-62, 2021. https://doi.org/10.1080/17434440.2021.1860750 DOI: https://doi.org/10.1080/17434440.2021.1860750

D. Panariello et al., “Using the KUKA LBR iiwa robot as haptic device for virtual reality training of hip replacement surgery”, 2019 Third IEEE International Conference on Robotic Computing (IRC), pp. 449-450, 2019. https://doi.org/10.1109/IRC.2019.00094 DOI: https://doi.org/10.1109/IRC.2019.00094

A. Parisi et al., “Minimally invasive surgery for gastric cancer: A comparison between robotic, laparoscopic and open surgery”, World J. Gastroenterol, vol. 23, no. 13, pp. 2376-2384, 2017. https://doi.org/10.3748/wjg.v23.i13.2376 DOI: https://doi.org/10.3748/wjg.v23.i13.2376

Z. Qi et al., “Holographic mixed-reality neuronavigation with a head-mounted device: Technical feasibility and clinical application”, J. Neurosurg. Focus, vol. 51, no. 2, 2021. https://doi.org/10.3171/2021.5.FOCUS21175 DOI: https://doi.org/10.3171/2021.5.FOCUS21175

M. Runciman, A. Darzi, and G. P. Mylonas, “Soft robotics in minimally invasive surgery”, Soft Robotics, vol. 6, no. 4, pp. 423-443, 2019. https://doi.org/10.1089/soro.2018.0136 DOI: https://doi.org/10.1089/soro.2018.0136

Y. Saito et al., “Intraoperative 3D hologram support with mixed reality techniques in liver surgery”, Ann. Surg, vol. 271, no. 1, pp. e4-e7, 2020. https://doi.org/10.1097/SLA.0000000000003552 DOI: https://doi.org/10.1097/SLA.0000000000003552

S. Sharif, and A. Afsar, “Learning curve and minimally invasive spine surgery”, World Neurosurg, vol. 119, pp. 472-478,

https://doi.org/10.1016/j.wneu.2018.06.094 DOI: https://doi.org/10.1016/j.wneu.2018.06.094

R. Wierzbicki et al., “3D mixed-reality visualization of medical imaging data as a supporting tool for innovative, minimally invasive surgery for gastrointestinal tumors and systemic treatment as a new path in personalized treatment of advanced cancer diseases”, J. Cancer Res. Clin. Oncol, vol. 148, pp. 237-243, 2022. https://doi.org/10.1007/s00432-021-03680-w DOI: https://doi.org/10.1007/s00432-021-03680-w

J. Zeiger, A. Costa, J. Bederson, R. K. Shrivastava, and A. M. C. Iloreta, “Use of mixed reality visualization in endoscopic endonasal skull base surgery”, Oper. Neurosurg, vol. 19, no. 1, pp. 43-52, 2020. https://doi.org/10.1093/ons/opz355 DOI: https://doi.org/10.1093/ons/opz355

Z.-Y. Zhang et al., “Preliminary application of mixed reality in neurosurgery: Development and evaluation of a new intraoperative procedure”, J. Clinic Neurosci, vol. 67, pp. 234238, 2019. https://doi.org/10.1016/j.jocn.2019.05.038 DOI: https://doi.org/10.1016/j.jocn.2019.05.038

How to Cite

APA

ACM

ACS

ABNT

Chicago

Harvard

IEEE

MLA

Turabian

Vancouver

Download Citation

Recibido: 20 de septiembre de 2021; Revisión recibida: 17 de mayo de 2022; Aceptado: 24 de junio de 2022

Resumen

Contexto:

Los cirujanos de intervenciones mínimamente invasivas requieren ampliar la información para realizar las rutas de intervención, este artículo describe un prototipo de realidad mixta de carácter educativo o pre quirúrgico que hace uso del Casco Metavision Meta II. Se crearon objetos 3D de estructuras morfológicas para neurocirugía y laparoscopia a partir de imágenes obtenidas de resonancia magnética MRI y TAC de un paciente real, con el fin de simular el acceso al cerebro y hacer reconocimiento del área abdominal.

Métodos:

Este prototipo tiene un enfoque educativo cuyo objetivo es incentivar el reconocimiento de esquemas morfológicos de órganos, para lo cual se diseñaron tres pruebas. Estas pruebas consistieron en la búsqueda de tumores a través de la navegación y la interacción con un objeto exhibido en el casco de realidad mixta Meta 2. Para el área neurológica se dedicaron dos de las tres pruebas, en las dos primeras pruebas se midió el tiempo de búsqueda con cinco tumores, y para el área abdominal se realizó también una prueba para la búsqueda de dos tumores, diseñándose diversas interacciones en el recorrido espacial del objeto 3D generado, usando pantallas con despliegues de los cortes tomados de imágenes de tomografía computarizada. Posterior al desarrollo de las tres pruebas se realizó un proceso de medición de inmersión a partir del uso de un cuestionario.

Resultados:

El 100% de los usuarios encontró altamente interesante la aplicación, en tanto que el 90% expresó que intentó fijar su foco de atención en el desarrollo exitoso de la prueba, indicador del nivel de absorción de la aplicación. También el 70% de los usuarios describió su experiencia como de alto nivel de inmersión.

Conclusiones:

Las pruebas demostraron que el prototipo es usable, absorbente y tiene un nivel de inmersión aceptable.

Palabras clave:

realidad aumentada, realidad mixta, casco Meta 2, exploración quirúrgica..Abstract

Context:

This article describes an educational or pre-surgical mixed-reality prototype using the Metavision Meta II headset. 3D objects of morphological structures for neurosurgery and laparoscopy were created from MRI and CT images of a real patient in order to simulate the access to the brain and conduct a reconnaissance of the abdominal area.

Method:

This prototype has an educational approach whose objective is to encourage the recognition of morphological schemes of organs, for which three tests were designed. These tests consisted of searching for tumors through navigation and interaction with an object displayed in the Meta 2 mixed-reality headset. Two of the three tests were dedicated to the neurological area, in which the search time was measured with five tumors, and a test was conducted for the abdominal area regarding the search of two tumors, designing various interactions in the spatial path of the generated 3D object. An immersion measurement process was conducted which was based on the use of a questionnaire.

Results:

100% of users found the application highly interesting, while 90% expressed that they tried to focus their attention on the successful completion of the test, an indicator of the level of absorption of the application. Furthermore, 70% of users described their experience as highly immersive.

Conclusions:

Tests showed the prototype to be usable, absorbent, and has an acceptable level of immersion.

Keywords:

augmented reality, mixed reality, Meta 2 headset, surgical exploration..Introducción

La cirugía mínimamente invasiva (CMI) es el conjunto de técnicas médicas que utiliza vías naturales o mínimos abordajes para introducir herramientas de diagnóstico e intervención usando la visión directa o de cámaras endoscópicas 1. Este tipo de cirugía puede ser aplicada en multitud de especialidades médicas como ginecología, urología, traumatología, cardiología, cirugía vascular y neurología. Dicha técnica requiere que los cirujanos desarrollen un conjunto de habilidades físicas y mentales que a veces son más complejas que en el caso de la cirugía abierta 2.

Algunos factores como la reducción de las horas de trabajo, y de menos horas de capacitación y de problemas de seguridad del paciente requieren que estas habilidades se adquieran fuera del quirófano, con el uso principalmente de simuladores que tradicionalmente consistían en cajas con el instrumental y algunos objetos al interior. Esto ha derivado hacia la generación de simuladores virtuales, área en crecimiento donde la medición de su efectividad es razón de estudio 3. En el campo de la medicina se espera que las capacitaciones y los entrenamientos médicos puedan planearse y practicarse sobre réplicas virtuales usando tecnologías de realidad virtual, realidad aumentada o realidad mixta 4; las cuales están inspiradas en medios de visualización para videojuegos y que en la actualidad están empezando a ser fuertemente usadas en áreas como la educación y la medicina 5. Se espera que este tipo de entrenamiento basado en simulación permita que los cirujanos adquieran las competencias adecuadas en campos de cirugía tan críticos como la neurocirugía 6, donde los errores humanos y técnicos pueden tener resultados negativos para el paciente 7), (8), (9).

La realidad virtual (VR por su sigla en inglés) recrea todo un escenario virtual de una posible realidad física. En el caso específico de las aplicaciones quirúrgicas uno de los impactos más relevantes de la realidad virtual se centra en el desarrollo de simuladores para cirugías mínimamente invasivas asistidas con robots 10), (11. Por su parte la realidad aumentada (AR por su sigla en inglés) usa parte de la imagen real (a través de video capturado en tiempo real) para sobreponer imágenes o información virtual 7.

Las primeras intervenciones asistidas por realidad aumentada se realizaron en el campo de la neurocirugía, y consistieron en la integración y visualización de datos de imágenes de tomografía computarizada (CT) sobre un microscopio operativo. Posteriormente se extendió su uso a la visualización tridimensional para ayudar con los procedimientos quirúrgicos laparoscópicos, y a otros procedimientos guiados por imágenes como extracción de tumores de cáncer de mama, procedimientos endonasales, cardíacos, digestivos y operaciones de hígado, evidenciando características superiores a las de los sistemas de navegación convencional. También ha permitido la manipulación virtual de una reconstrucción 3D a través de visualizaciones intracraneales 12, rotaciones, segmentaciones y otros procedimientos, con la finalidad de generar un conocimiento detallado de una posible situación quirúrgica 12), (13.

La realidad aumentada convencional tiene la característica y la limitante de usar las imágenes de video de un dispositivo y sobre ellas sobreponer la información aumentada, por tal motivo se ha avanzado hacia el uso de la realidad mixta (MR por su sigla en inglés) 14, la cual ofrece a los usuarios percibir tanto el entorno físico que los rodea como los elementos digitales (objetos virtuales) presentados a través de pantallas semitransparentes 15. Es importante recalcar que los sistemas de MR proporcionan a los usuarios la ilusión de que los objetos digitales coexisten en el mismo espacio junto a los objetos físicos reales 16.

Cuando se habla de cirugía guiada o navegación quirúrgica se hace mención al proceso que busca seguir una ruta en un espacio de tres dimensiones a partir de imágenes preoperatorias (Rx, CTScan, MRI), las cuales se despliegan en una pantalla en tiempo real 9. Estas imágenes pueden ser plantillas o guías para la cirugía que se construyen en el preoperatorio y en algunos casos se suele incluir el área de intervención además de la posición del instrumental en tiempo real 17. Las imágenes preoperatorias se obtienen de escáneres convencionales de CT (Computed Tomography) o MRI (Magnetic Resonance Imaging). Las CT usan la combinación de múltiples mediciones de rayos X desde diferentes ángulos para producir una serie de imágenes de cortes para tres dimensiones, en tanto que la MRI usan gradientes de campo magnético y ondas de radio. Estos dos tipos de imágenes médicas se adquieren antes de cierto grupo de intervenciones quirúrgicas, lo que permite que se procesen manual o automáticamente, con el objetivo de realizar y aislar mediante segmentación estructuras de interés como órganos, tumores, huesos o vasos.

Los métodos clásicos de segmentación incluyen umbrales, crecimiento de regiones, contornos activos, agrupación y clasificadores 18. Dada la importancia actual de la relación entre la medicina y la ingeniería, se evidencia el gran aporte que las nuevas tecnologías de visualización pueden brindar a los procedimientos diagnósticos y quirúrgicos 19, 20), (21), (22.

El presente artículo muestra el uso de la tecnología de realidad mixta con el casco Meta II de Metavision, el cual es usado en un prototipo que se espera permita la exploración y el diagnóstico en procedimientos preoperatorios para neurocirugía y laparoscopia de carácter educativo.

Materiales y métodos

Descripción del hardware y el software utilizado

El casco Meta II de la compañía Metavision (Fig. 1) permite tener un campo de visión real ampliado a través de un visor transparente que brinda al usuario una experiencia de inmersión con hologramas tridimensionales hiperrealistas.

Figura 1: Casco Meta II de Metavision

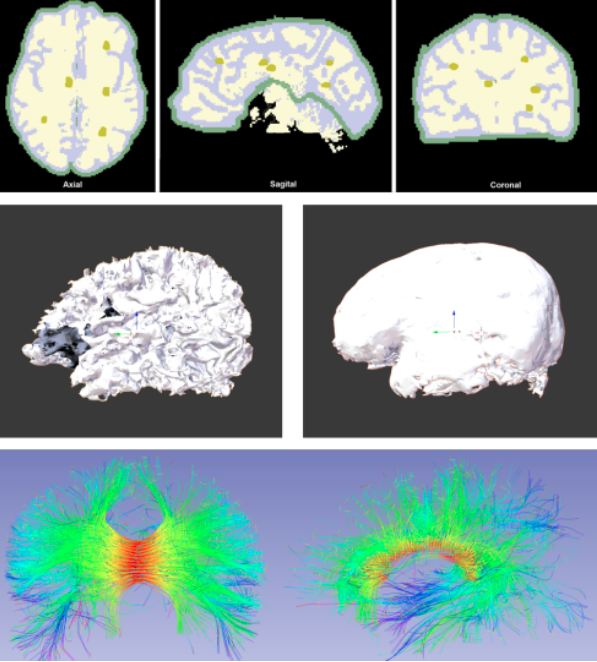

Para el manejo de los cascos de MR y la creación de los objetos virtuales se usó el motor de juegos Unity 3D en su versión 2018.1, el cual es un software para diseño, creación y representación de videojuegos. Las imágenes desplegadas en la realidad mixta se generaron a partir de MRI (imagen de resonancia magnética) y CT (tomografía computarizada), para posteriormente ser procesadas con los paquetes de software 3D Slicer y Blender, con el fin de segmentar elementos morfológicos específicos y mejorar su visualización. Las imágenes médicas utilizadas como información aumentada sobre la vista real fueron obtenidas del banco de imágenes por resonancia magnética del proyecto Slicer DMRI (dmri.slicer.org) de 3D Slicer.

Se crearon dos escenarios de entrenamiento, uno basado en imágenes craneales y otro para imágenes abdominales. A través de 3D Slicer y con las imágenes RMI, se obtuvo un modelo 3D del cerebro segmentando en estructuras muy específicas como materia gris, materia blanca y cuerpo calloso. Se incluyeron objetos virtuales que representan tractos neurológicos diferenciados por diversos colores, con el fin de mostrar estructuras que no son fácilmente visibles en el desarrollo de una intervención quirúrgica. Se crearon cinco tumores ficticios en zonas aleatorias del cerebro, con el fin de desarrollar una prueba de validación del prototipo de realidad mixta. Para la obtención de materia gris, materia blanca y tumores como objetos 3D, se hizo la segmentación de dichas zonas correspondientes a la parte central de cada corte del cerebro (axial, sagital y coronal) y posteriormente con el proceso de segmentación realizado se crearon las partes en un modelo 3D como se muestra en la Fig. 2.

Figura 2: Representación del cerebro como objeto tridimensional a partir de imágenes de RMI

En el caso de la aplicación para la prueba en el área abdominal, se usó un procedimiento similar al realizado con el cerebro, diferenciándose tan solo en la procedencia del tipo de imágenes que para este caso correspondían a imágenes de tomografía computarizada (CT). Los órganos reconstruidos en 3D corresponden al hígado y la vesícula biliar. Posteriormente se procedió a generar los huesos de la cavidad abdominal. Para este esquema abdominal también se crearon tumores ficticios con el fin de ser usados en el desarrollo de las pruebas de validación. Adicionalmente se ubicó el conjunto de imágenes médicas en tres pantallas virtuales que corresponden a las imágenes de TC para cada corte con el fin de proveer navegación a través de los cortes axial, sagital y coronal de cada una las estructuras anatómicas presentes, como se puede ver en la Fig. 3.

Figura 3: Montaje total del sistema de realidad mixta en entrenamiento para visualización preoperatoria en laparoscopia abdominal

Para el desarrollo de las pruebas el usuario recibió una charla inicial sobre las características del hardware, forma de usarlo, así como de las reglas y alcances de la prueba.

Prueba 1: usuario móvil y cerebro fijo

Para esta primera prueba el cerebro se ubicó en una posición fija y es el usuario quien se desplazó en el espacio, caminando, girando o moviendo la cabeza alrededor del objeto 3D, el cual se podía percibir como un holograma flotando en la habitación. Se usó un contador de tiempo mientras el usuario navegaba dentro del cerebro para encontrar cada uno de los cinco tumores, con el fin de motivar al usuario a hacer una exploración del elemento 3D. Dichos tumores aparecían de manera secuencial y cada usuario contó con un tiempo máximo de diez minutos. Este límite de tiempo también fue aplicado a las pruebas 2 y 3.

Una vez ubicado el tumor el siguiente desafío para el usuario fue explorar el cerebro con el objetivo de definir una vía de acceso hacia él, es decir un camino donde encontrara la mínima cantidad de ramificaciones, que en la práctica quirúrgica se reflejaría en el mínimo daño posible y en el menor compromiso de tractos neuronales y materia blanca lesionados.

Para cada ruta se guarda un archivo gráfico con dicha vía (en coordenadas tridimensionales a modo de mapa), y se repite de forma similar para los cinco tumores. En la Fig. 4 se observa un usuario realizando la prueba 1 así como la visual del despliegue del casco Meta II y un acercamiento al tumor.

Figura 4: Prueba 1: usuario móvil y cerebro fijo

Prueba 2: usuario fijo y cerebro móvil

En esta prueba el usuario no se desplazaba por la habitación, podía estar de pie o sentado, mientras la navegación en el cerebro se hacía con la ayuda de las manos, de tal manera que girando y acercando el objeto se pudieran encontrar los tumores y definir así las vías de acceso para cada uno de ellos. En la Fig. 5 se observa un usuario realizando la segunda prueba del sistema. Los círculos azules son los puntos donde se detectan las manos del usuario sobre el objeto virtual.

Figura 5: Prueba 2: usuario fijo y cerebro móvil

Prueba 3: visualización área abdominal

Para la validación del sistema de realidad mixta en el área abdominal, el usuario sujetó con sus manos un cursor virtual que permitió navegar dentro y fuera de la cavidad abdominal.

Se realizó un conteo de tiempo para la búsqueda de dos tumores, los cuales aparecían de forma secuencial. Se generaron unas pantallas virtuales con las imágenes de CT que parecen estar flotando en la habitación, para familiarizarse entre la posición 3D y el corte bidimensional.

La Fig. 6 muestra una vista de la aplicación.

Figura 6: Prueba 3: usuario interactuando con visualización área abdominal

Resultados

Las pruebas de validación del sistema de realidad mixta en neurocirugía se llevaron a cabo con diez usuarios, cinco mujeres y cinco hombres, entre los 25 y 50 años, de ocupación ingenieros y técnicos, quienes realizaron las dos pruebas con un descanso de cinco horas entre la primera y la segunda.

Para este proceso se tomaron los tiempos utilizados para encontrar cada tumor con el fin de evaluar el proceso de adaptación, familiarización y aprendizaje en el manejo del sistema. Además, se realizaron encuestas para la medición de la inmersión en entornos de realidad mixta basados en la ubicación. Se evaluaron aspectos como el interés, la absorción y la inmersión total en el sistema 23.

A partir de los datos de tiempo tomados en la primera prueba, se elaboró la gráfica tumores vs tiempo que se observa en la Fig. 7.

Figura 7: Prueba 1: tiempos de determinación de cada tumor para prueba de usuario fijo y cerebro móvil

En esta gráfica se evidencia una particularidad en el usuario 2, ya que tuvo los tiempos más altos para encontrar los primeros tumores. Este usuario manifestó sentir cansancio y un leve dolor de cabeza por el peso del dispositivo debido a que llevaba gafas para la miopía. De otra parte el, 80% de los usuarios tras encontrar el primer tumor, mostró mayor destreza para encontrar el segundo, debido a la apropiación de la dinámica del experimento.

En la Fig. 8 se muestran los tiempos obtenidos por los usuarios para encontrar los cinco tumores de la segunda prueba, en la cual el cerebro está fijo y es el usuario quien puede recorrer el espacio. En esta prueba también se presentó un abandono por parte del usuario 2, quien expresó que la manipulación del cerebro con las manos le agregó un grado de dificultad muy alto, generándole dolor de cabeza y cansancio en los brazos y manos.

Figura 8: Prueba 2: Tiempos de determinación de cada tumor para prueba de usuario móvil y cerebro fijo

Ambas gráficas muestran que los tiempos tienen alternancia, es decir, se encuentra rápido un tumor, luego el tiempo para el siguiente es más alto, y luego de nuevo disminuye el tiempo para el siguiente. Aunque esto no es concluyente, el cambio en el tiempo puede darse por dos factores: que el usuario aprenda a moverse dentro del entorno holográfico, o que simplemente el tumor esté ubicado en una zona de mayor o menor visibilidad.

Para la evaluación del prototipo de realidad mixta en neurocirugía se aplicó una adaptación de la encuesta basada en el cuestionario ARI (Augmented Reality Immersion) descrito en 24, midiendo los siguientes factores:

A. Compromiso: el 100% de los usuarios encontró altamente interesante la aplicación en neurocirugía y manifestó que el sistema fue fácil de manejar. El 80% de ellos al iniciar las pruebas sintió un poco de confusión debido a su escasa relación con la realidad aumentada, sintiendo mayor incomodidad en la segunda prueba que en la primera por la limitación de espacio que esta conlleva.

B. Absorción: el 70% de los usuarios manifestó un poco de impaciencia cuando no encontraban rápidamente los tumores, ya que sentía que no iba a culminar exitosamente la prueba. La mitad de los usuarios durante el experimento llegó a experimentar algún tipo de distracción relacionada con el medio donde se llevaron a cabo las pruebas, aunque el 90% de los usuarios expresó que intentó fijar su foco de atención en el desarrollo exitoso de las mismas

C. Inmersión total: solo la mitad de los usuarios llegó a sentir que los objetos que veían a través del Meta II eran reales, pero todos sintieron la necesidad de interactuar con dichos objetos. El 70% de los usuarios experimentó un alto nivel de inmersión. Algunos usuarios presentaron síntomas de mareos, causados en general por el peso del Meta II y por la escasa experiencia en la utilización de esta tecnología. Varios usuarios expresaron sentir cansancio visual, en particular los que usan gafas para miopía (tres usuarios), generándoles a veces disminución del interés por lograr un buen desempeño en las pruebas.

Conclusiones

El presente artículo mostró el diseño y la implementación de un sistema de realidad mixta para simular la navegación médica en neurocirugía y laparoscopia abdominal. Para dicha navegación se crearon objetos tridimensionales a partir de tomografías computarizadas (CT) e imágenes de resonancia magnética (MRI) de un paciente real, con el fin de obtener dichos objetos 3D similares a la realidad. La validación del sistema se llevó a cabo con usuarios a través de dos pruebas: una para el aplicativo en neurocirugía y una para el sistema en laparoscopia abdominal. En el caso del sistema en neurocirugía se realizaron encuestas de inmersión en sistemas de realidad aumentada.

Este sistema basado en la tecnología de visualización del casco Meta II permitió ampliar la información visual usando imágenes médicas de pacientes reales. El sistema fue probado en un grupo de usuarios con formación técnica, obteniéndose interesantes conclusiones.

Las pruebas basadas en la medición del tiempo estaban enfocadas en presentar a los participantes un reto para permanecer en el desarrollo de una tarea de entrenamiento. Siendo la inmersión un pilar importante en este tipo de proyectos, se obtuvo que el 90% de los participantes expresó que intentó fijar su foco de atención en el desarrollo exitoso de las pruebas. Por otro lado el 70% de los usuarios describieron su experiencia como de alto grado de inmersión, lo cual muestra que es un tipo de tecnología que ofrece un nivel de novedad y motivación que puede facilitar el grado de aprendizaje en este campo.

Los resultados de las pruebas permiten pensar que en un futuro próximo los cascos de realidad mixta pueden convertirse en un elemento imprescindible en los procedimientos de exploración, diagnóstico e intervención quirúrgica. Para trabajos futuros se espera implementar la realidad mixta en procedimientos más complejos, con mayor realismo y en intervenciones más específicas. Además incluir en las pruebas del sistema personal médico que pueda evaluar la aplicación desde el punto de vista funcional.

Referencias

License

Copyright (c) 2022 Eliana Aguilar, Pedro Solarte, Jesus Dorado, Andrés Vivas, Jose Maria Sabater

This work is licensed under a Creative Commons Attribution-NonCommercial-ShareAlike 4.0 International License.

From the edition of the V23N3 of year 2018 forward, the Creative Commons License "Attribution-Non-Commercial - No Derivative Works " is changed to the following:

Attribution - Non-Commercial - Share the same: this license allows others to distribute, remix, retouch, and create from your work in a non-commercial way, as long as they give you credit and license their new creations under the same conditions.

2.jpg)